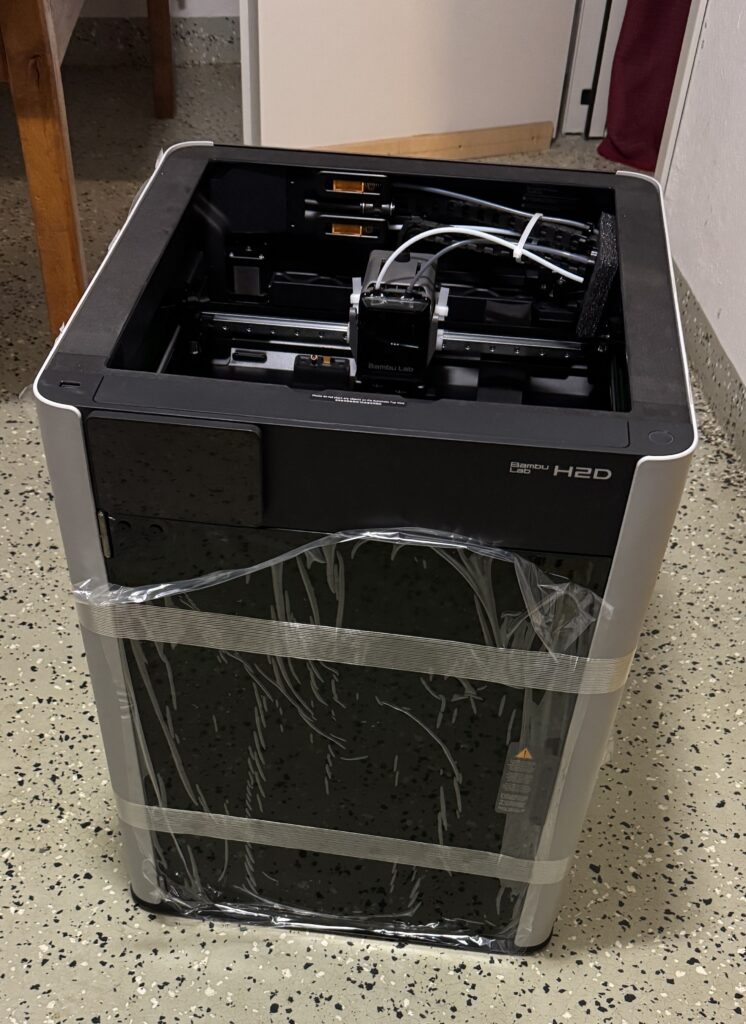

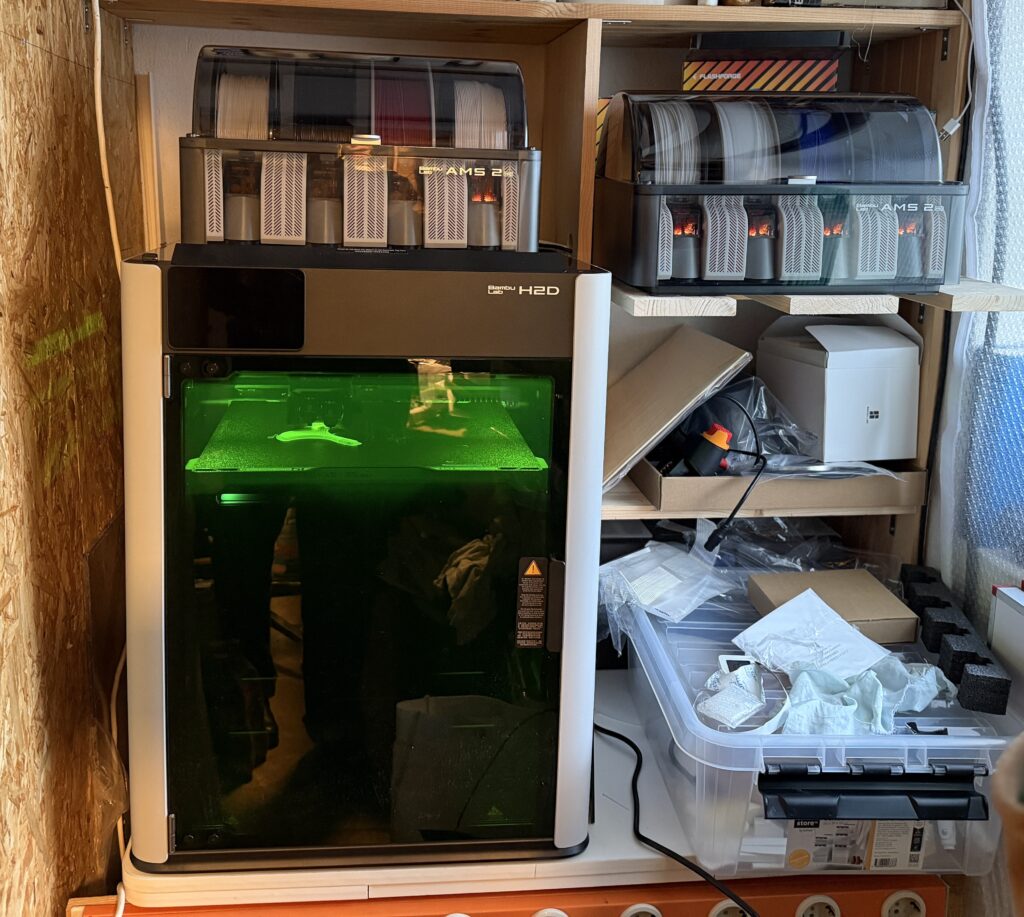

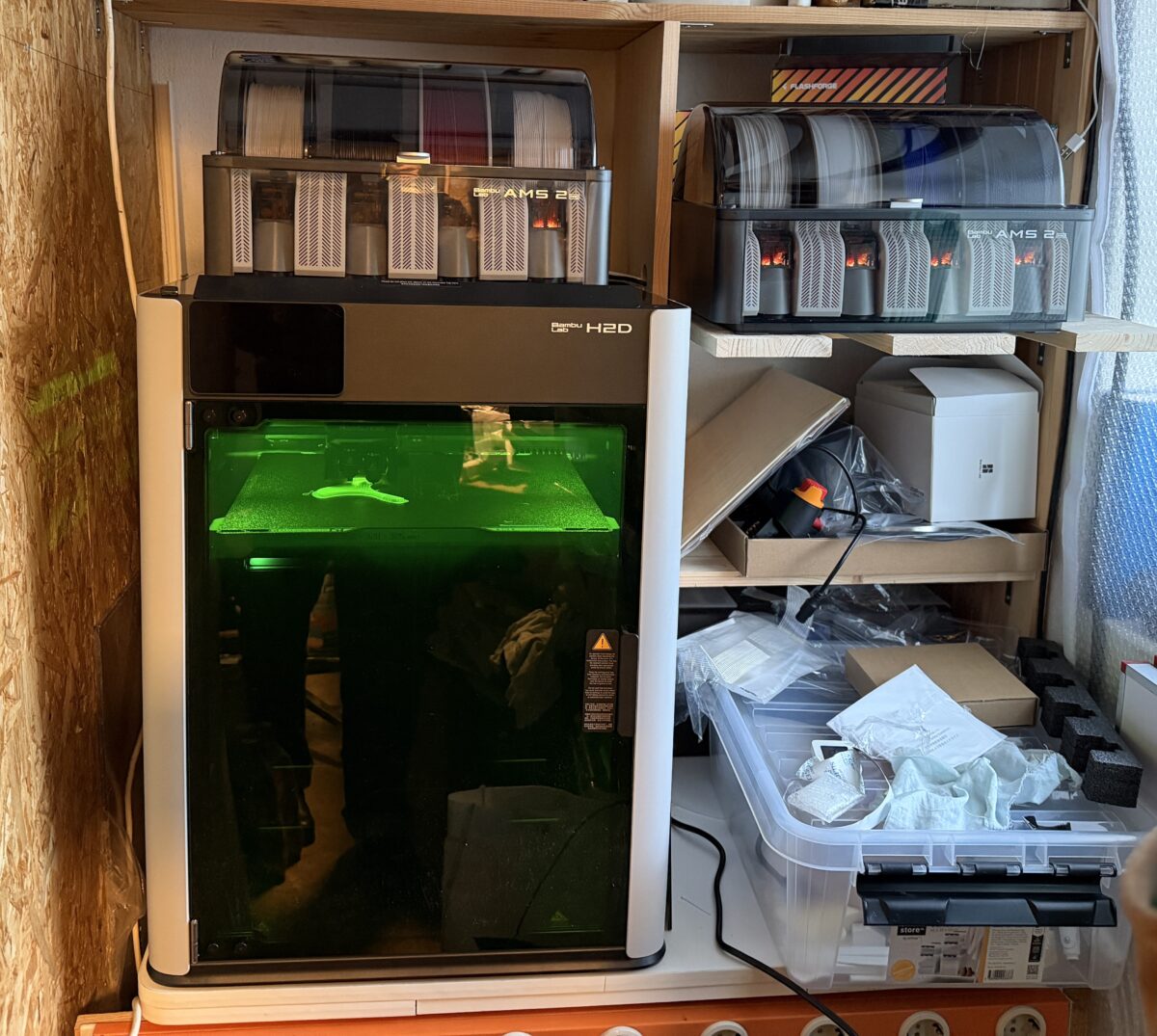

Der neue 3D Drucker H2D . Nach dem Eintreffen gleich ein 2. AMS bestellt, man gönnt sich ja sonst nichts

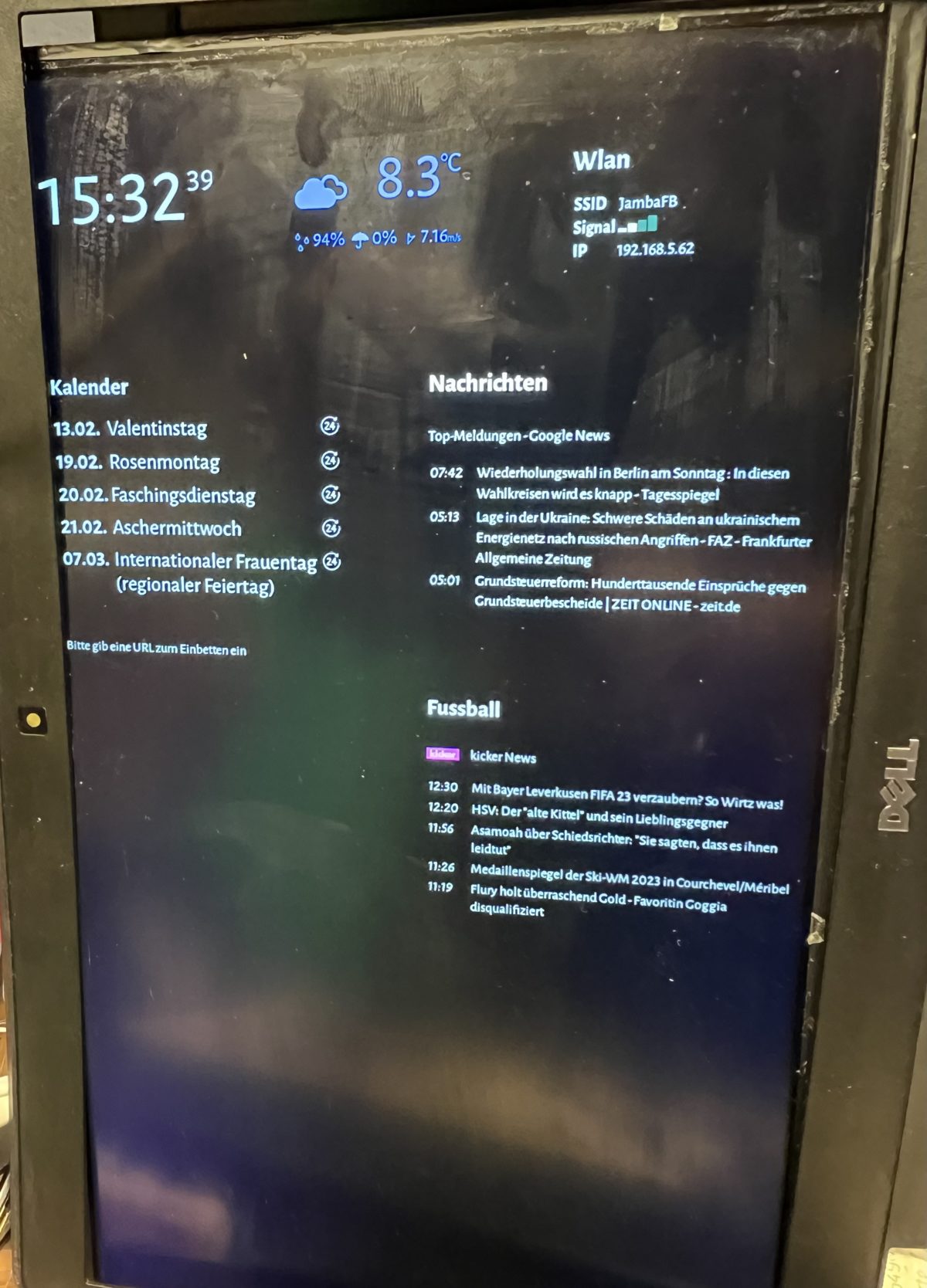

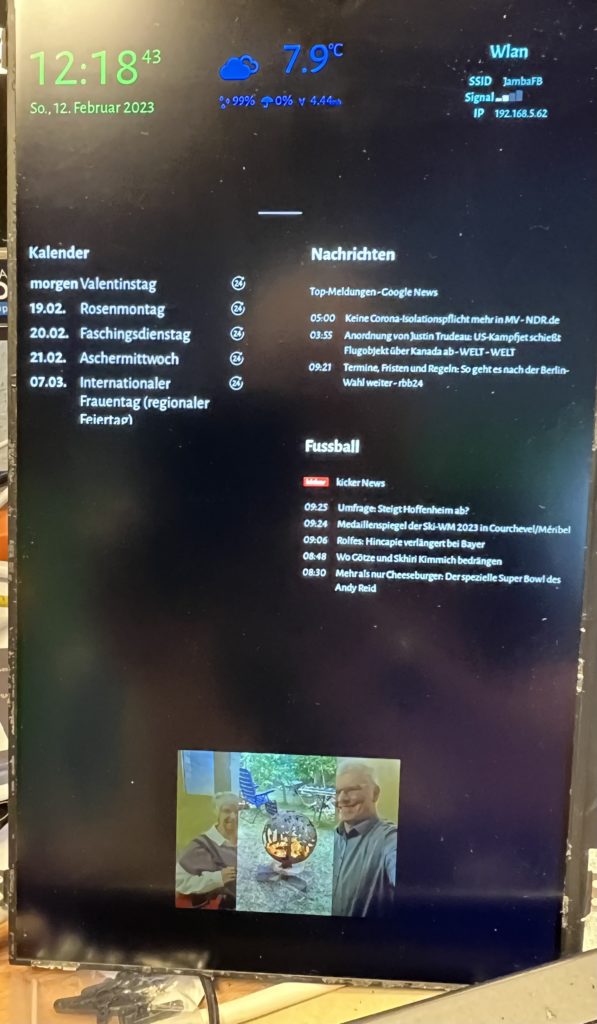

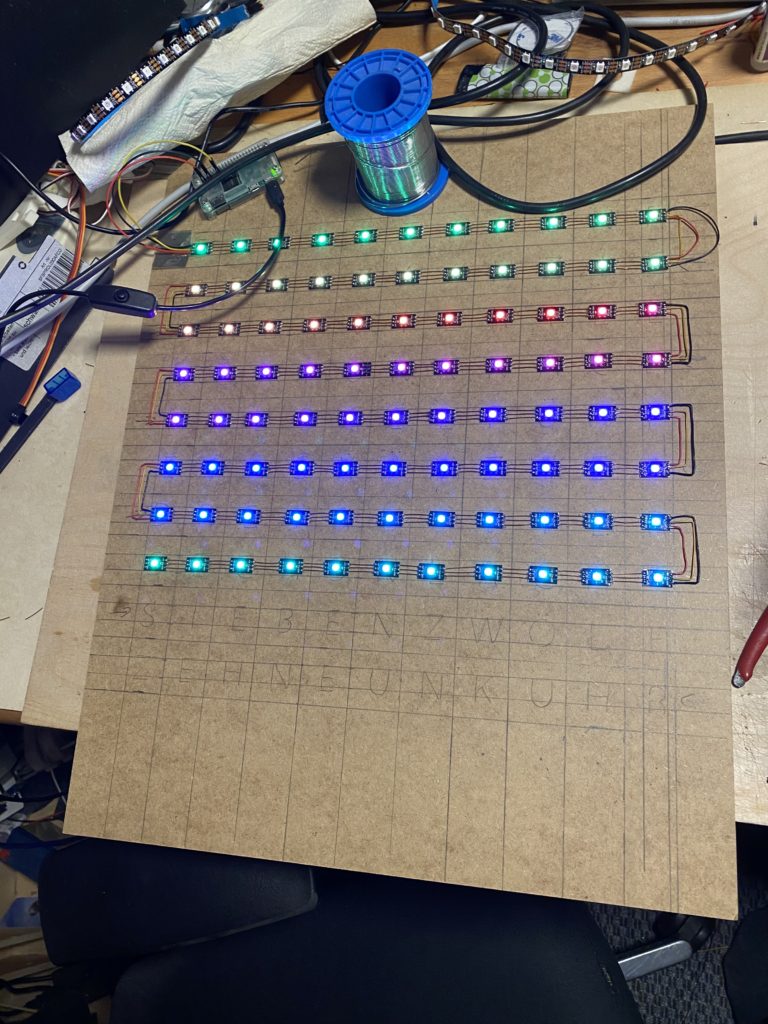

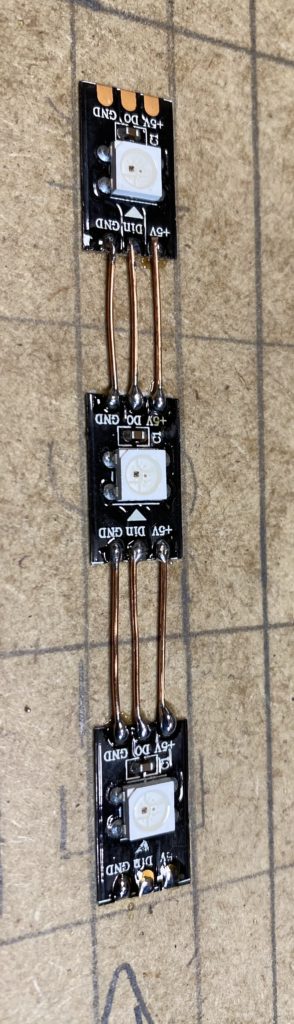

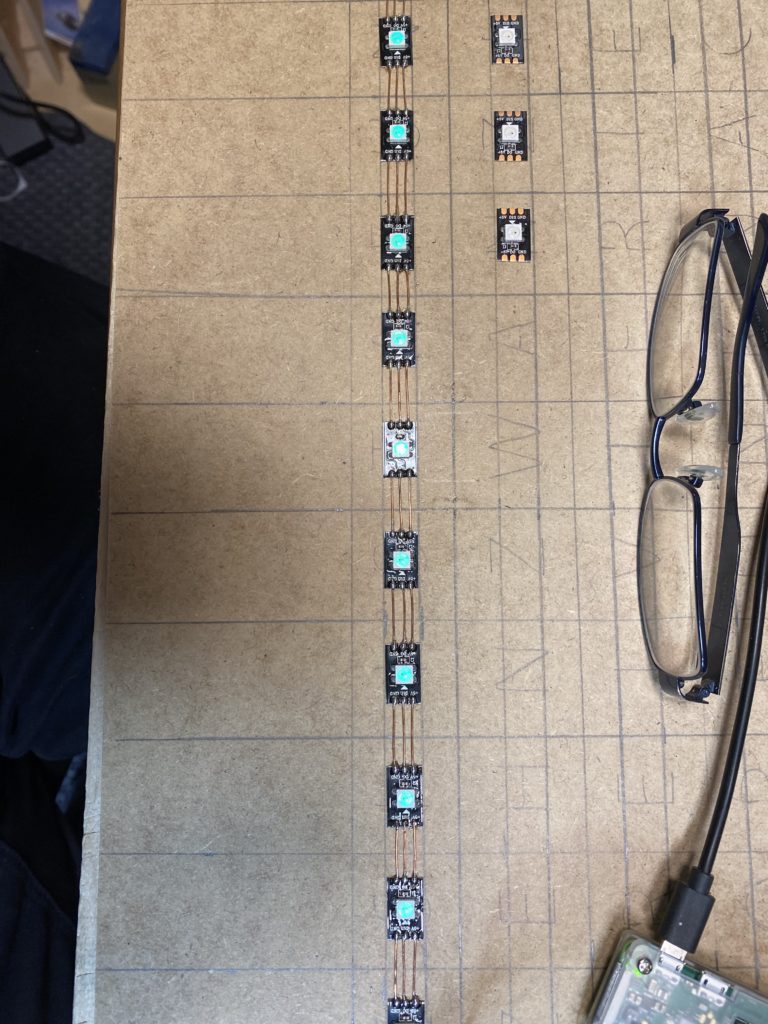

Das ganze endet dann ab dem 27.02.2023 – 10.03.2023 in einem Spiegel Schrank, dann folgen weitere Beiträge 😉

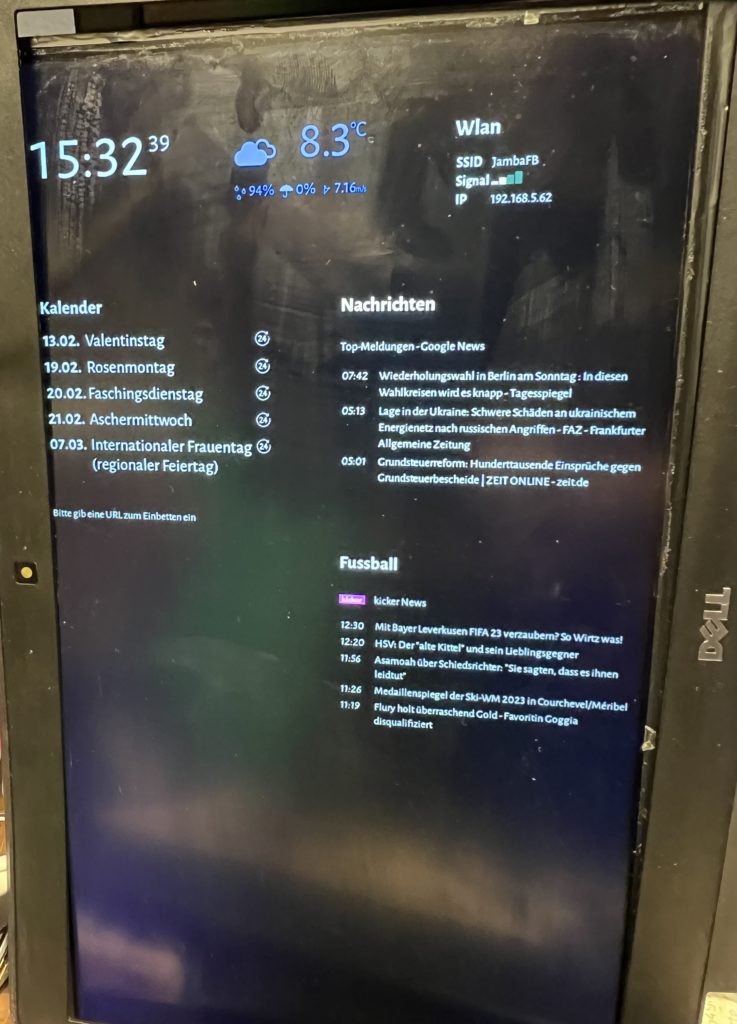

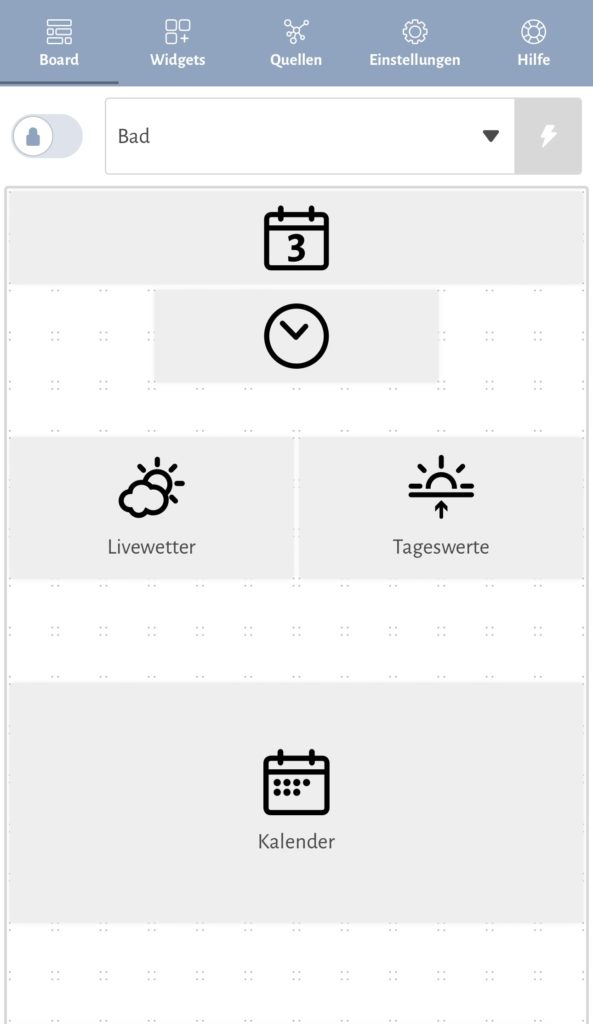

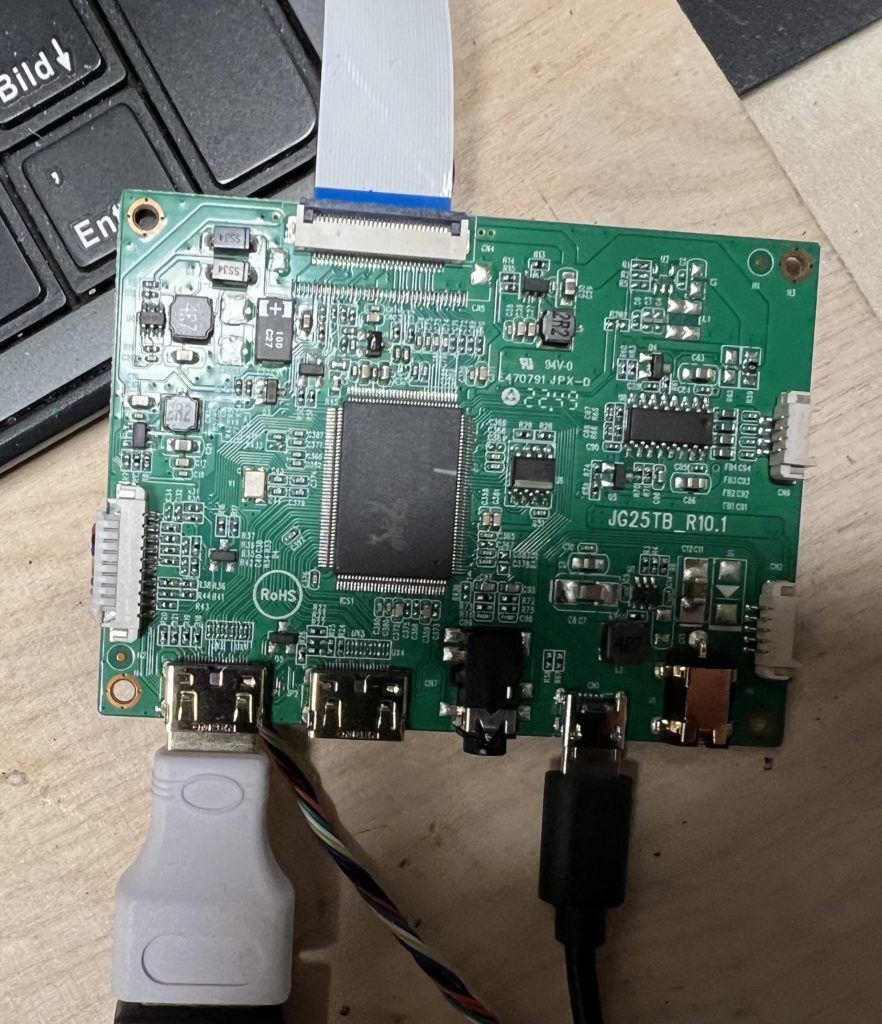

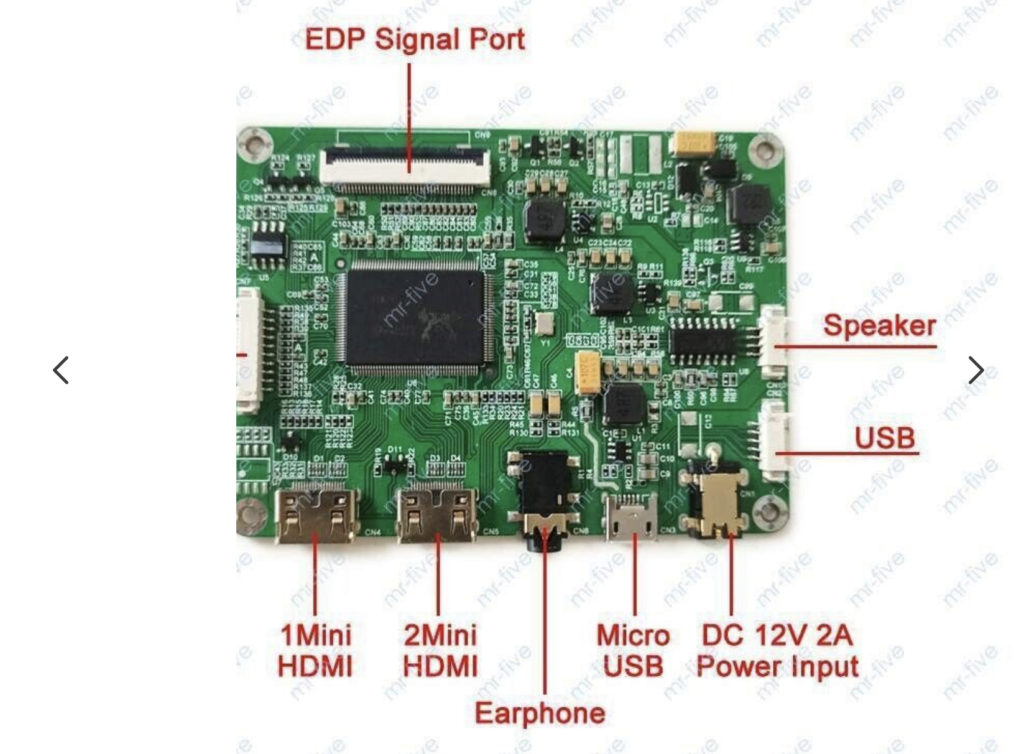

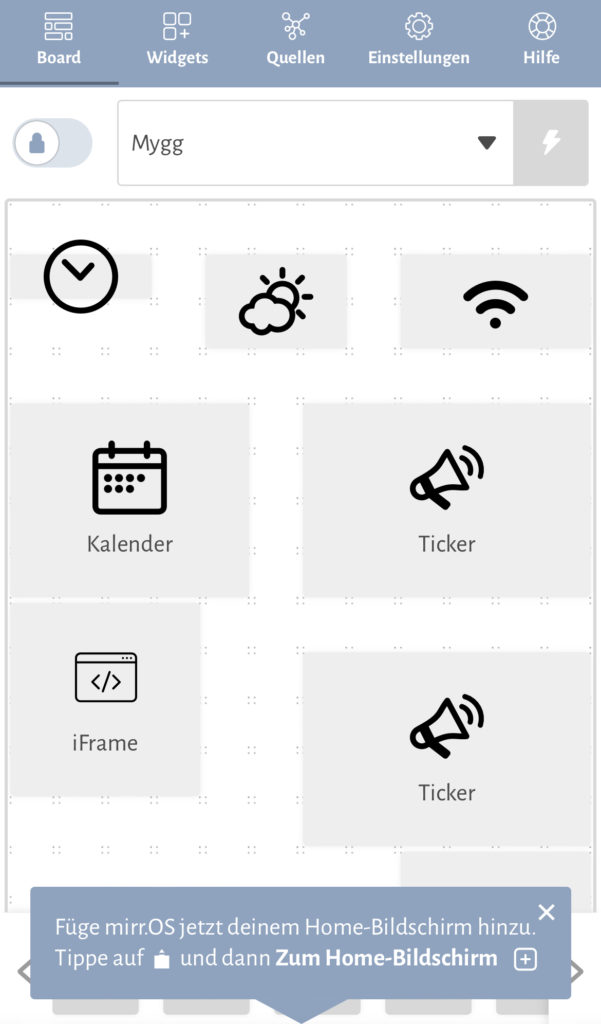

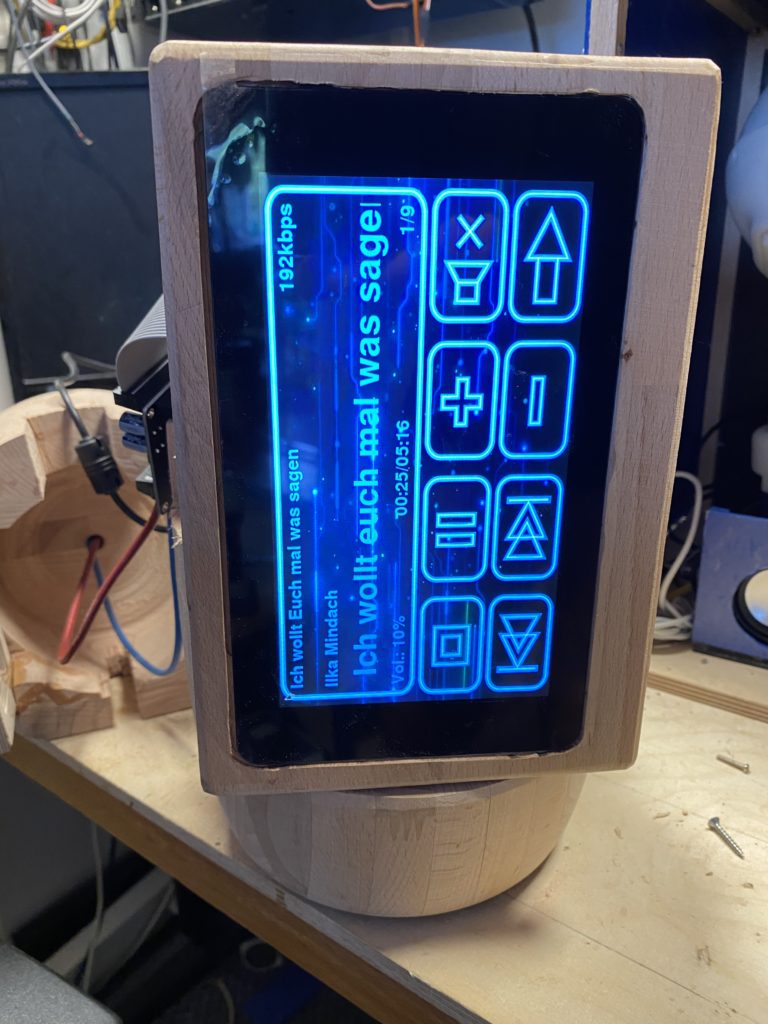

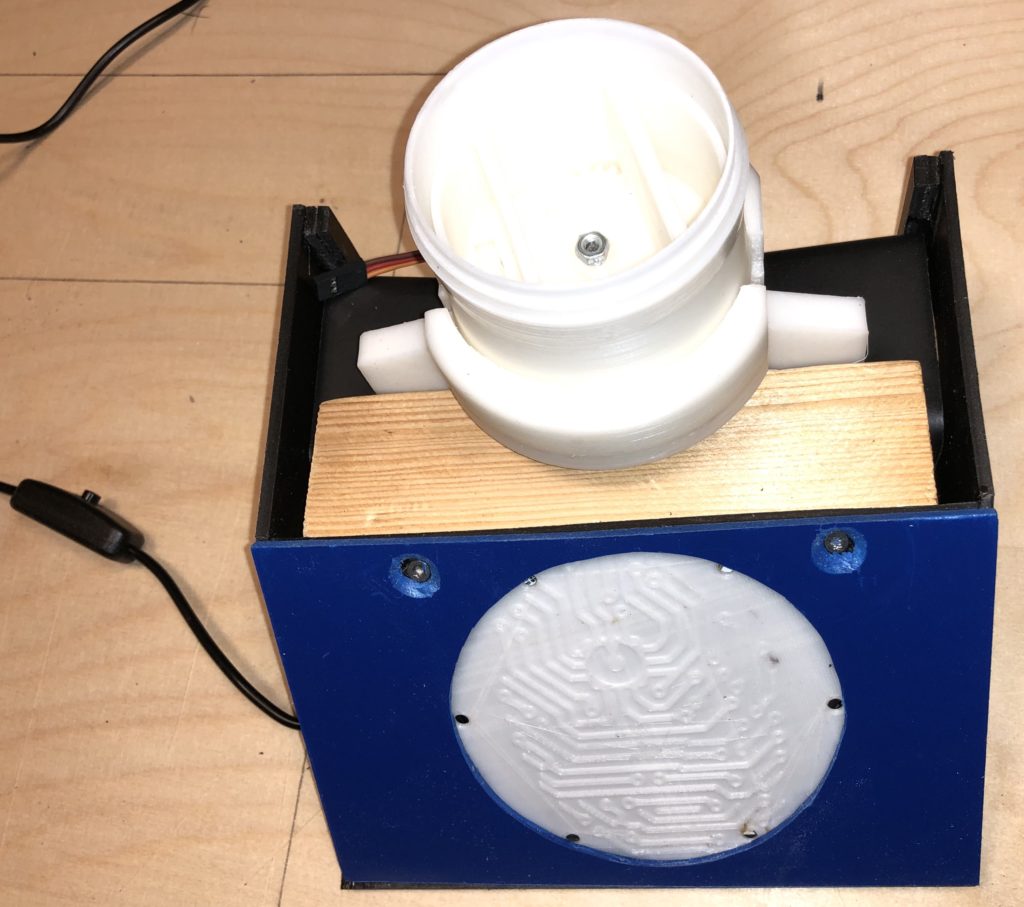

Das ganze wurde unter zu Hilfenahme der Software mirr.os für den Raspberry Pi gemacht.

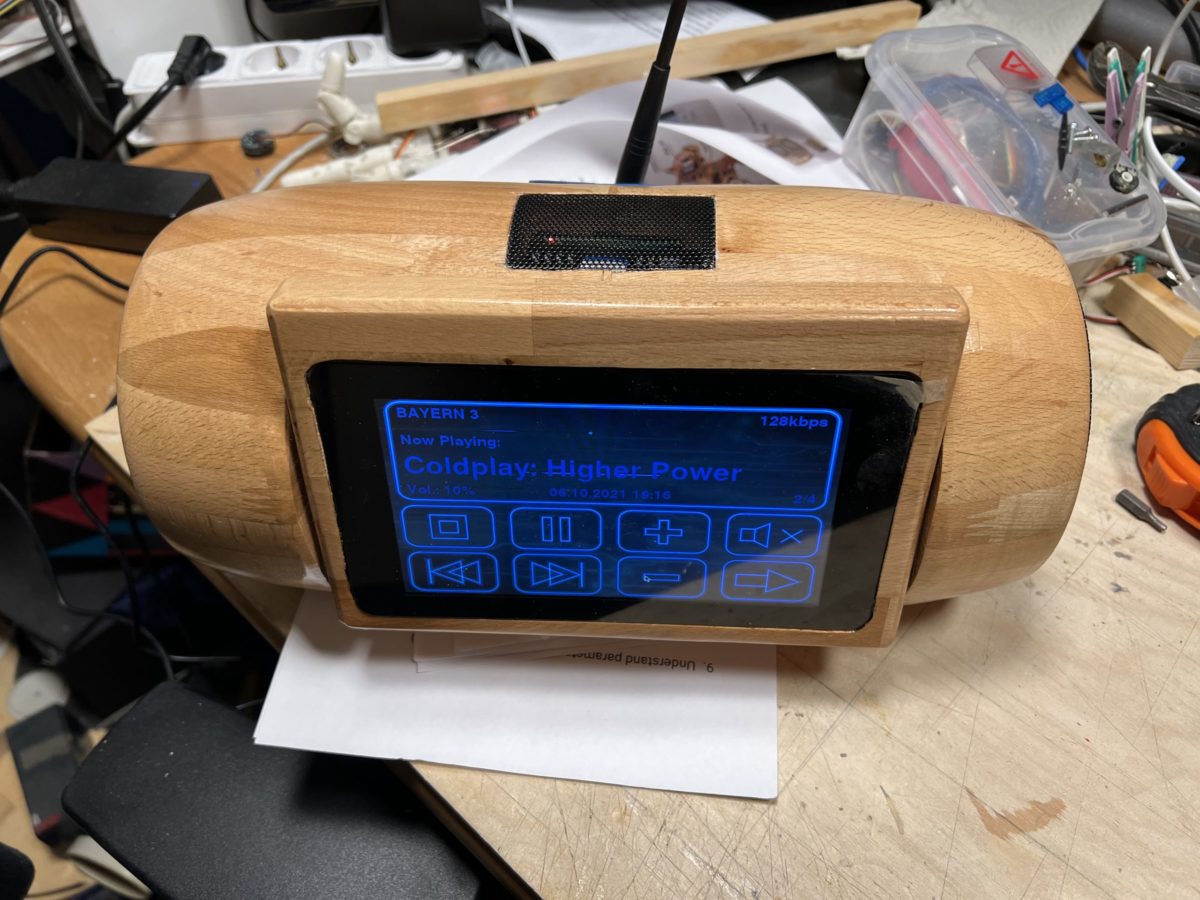

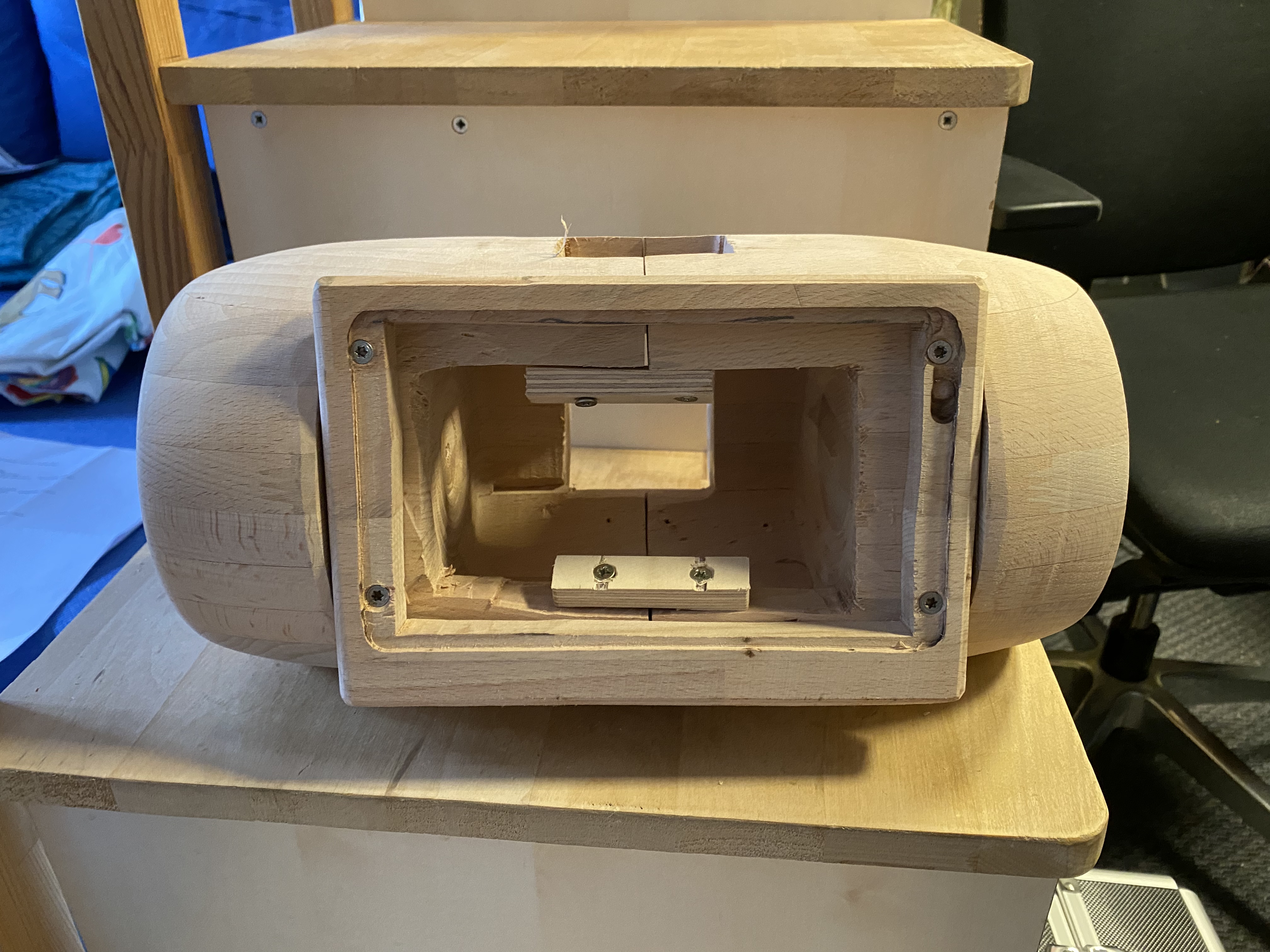

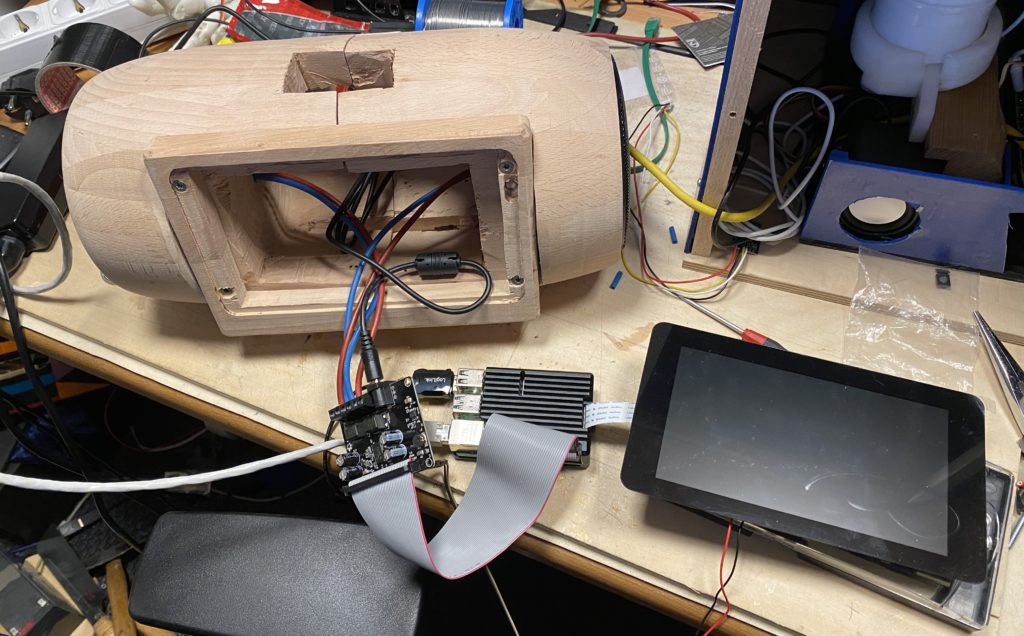

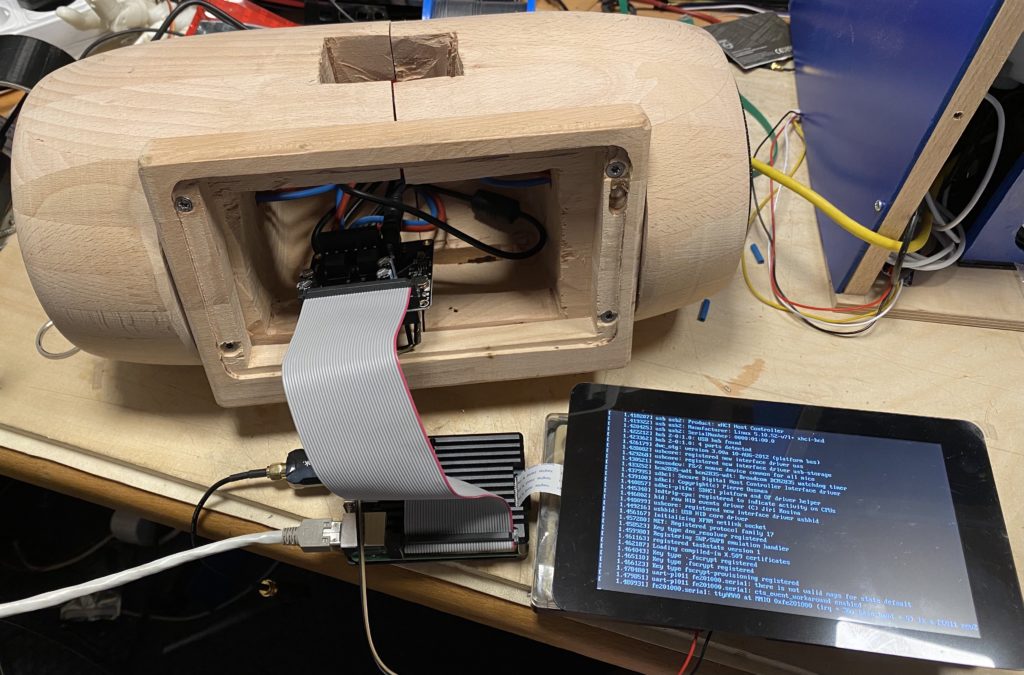

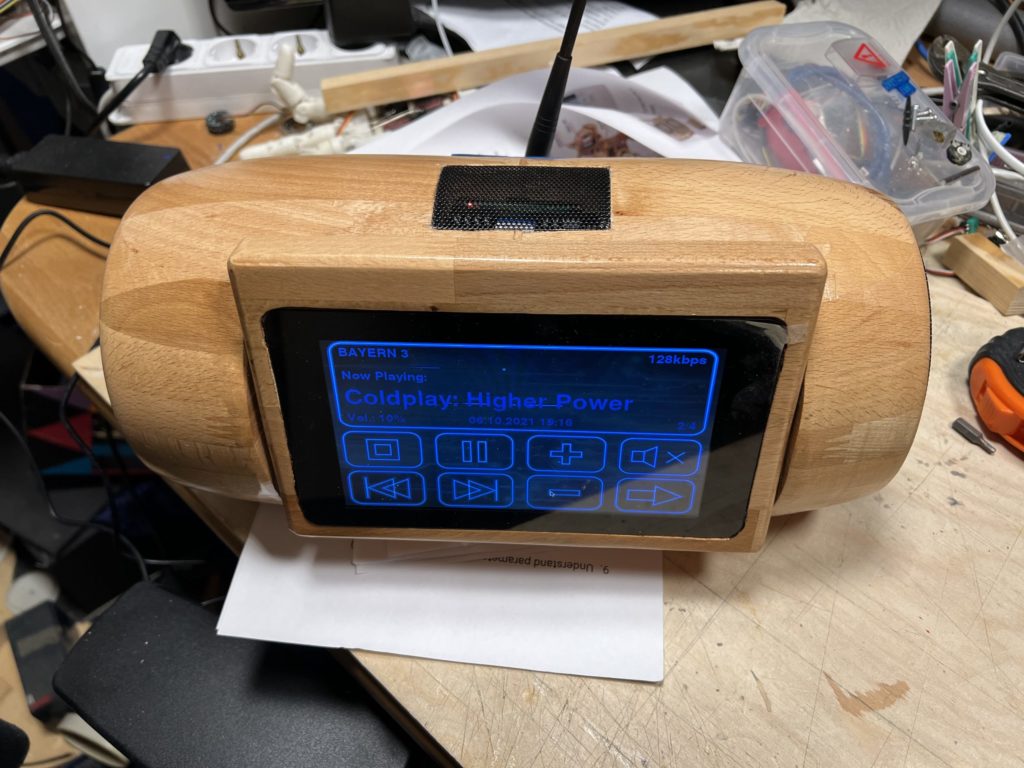

Das kann man sich auch auf meiner Holzseite anschauen https://holz.mindach.net/index.php/2021/09/12/holz-und-technik-gemischt/

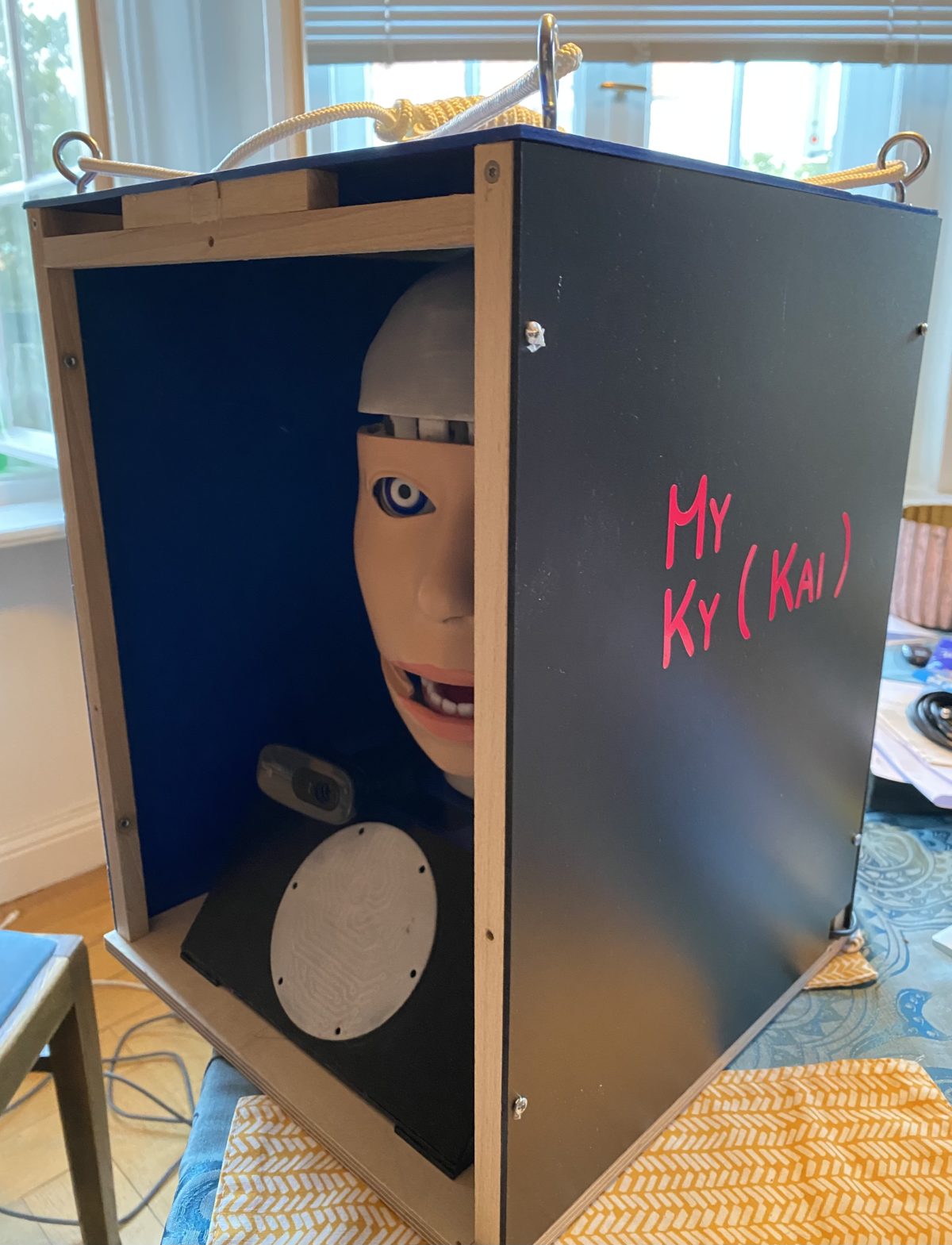

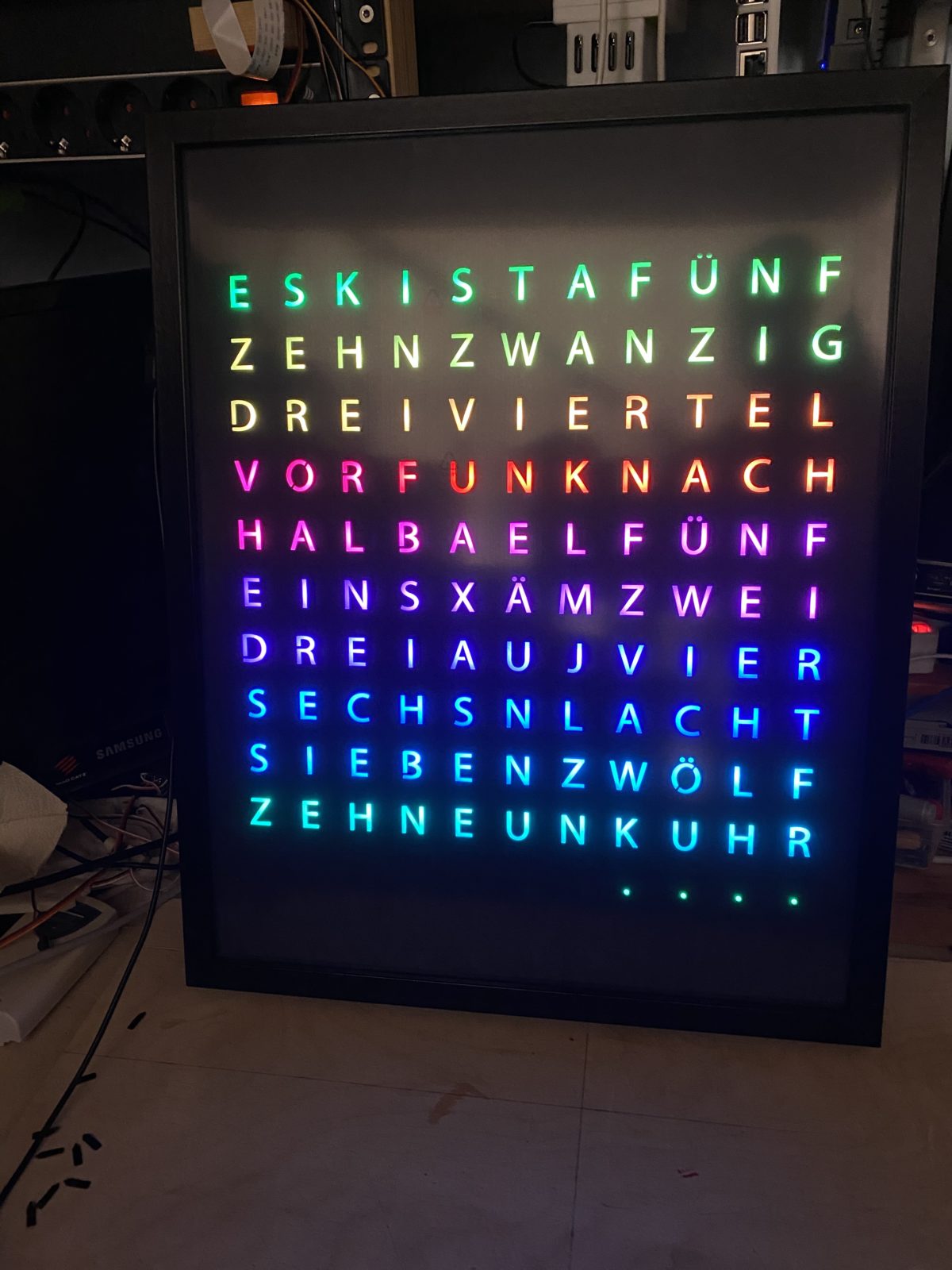

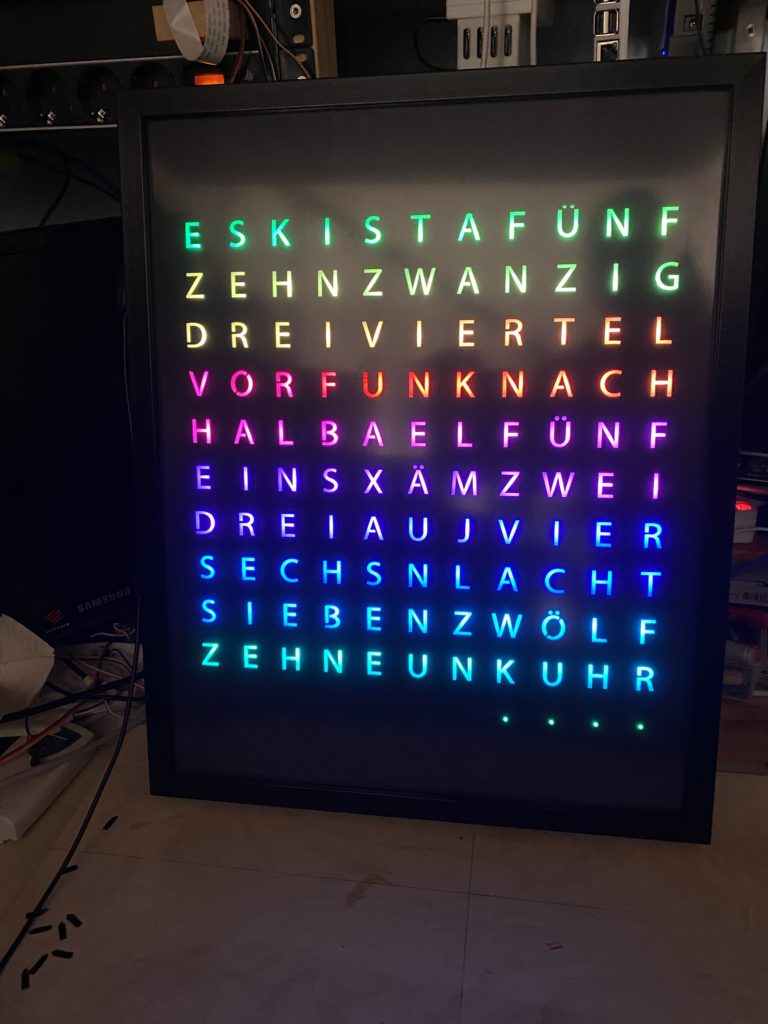

Die Punkte unten rechts sind die Minuten bis Vier an der Zahl und müssen entsprechend addiert werden um die genaue Zeit zu erhalten

Demnächst Bilder mit der funktionierenden Software

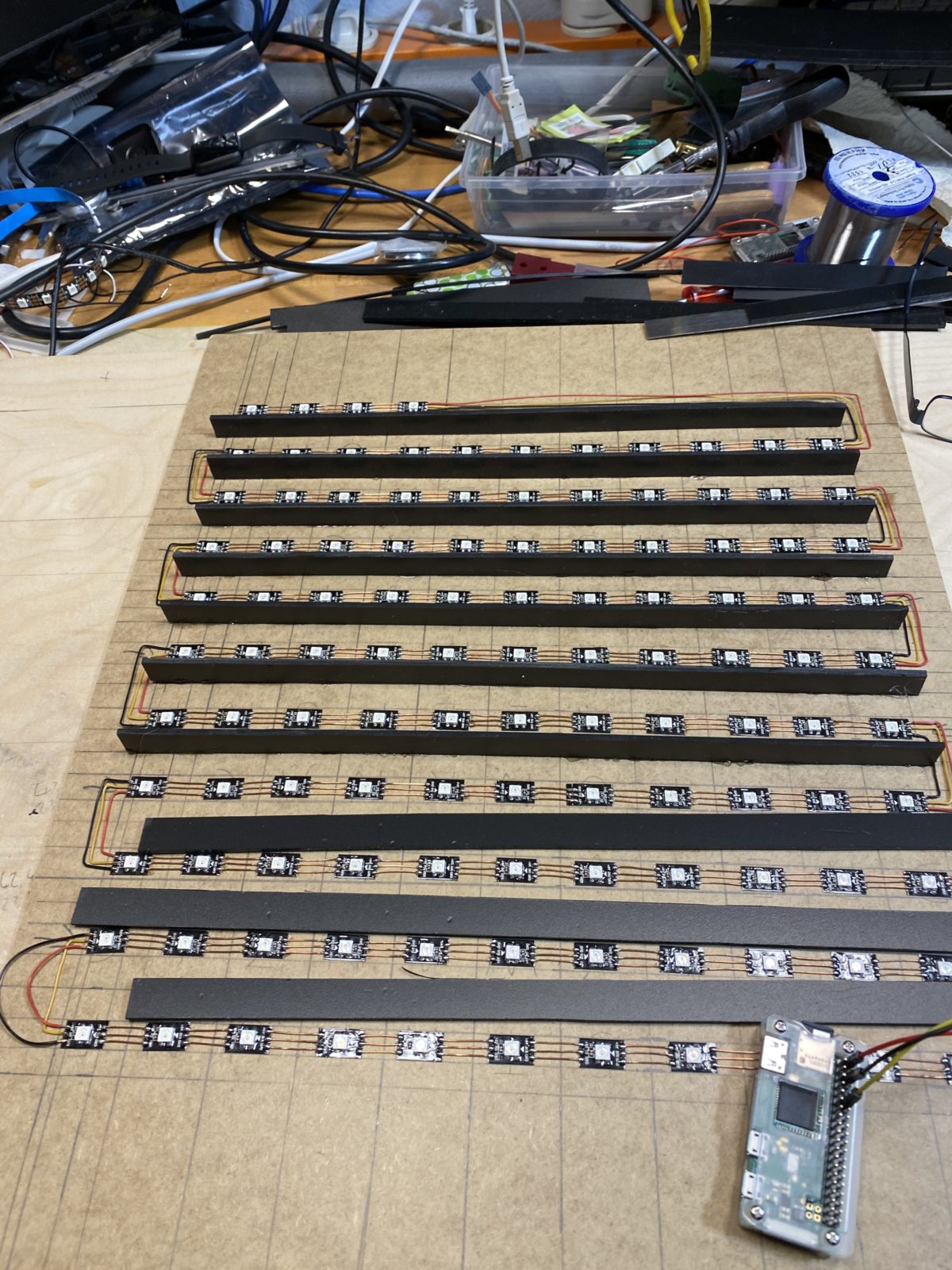

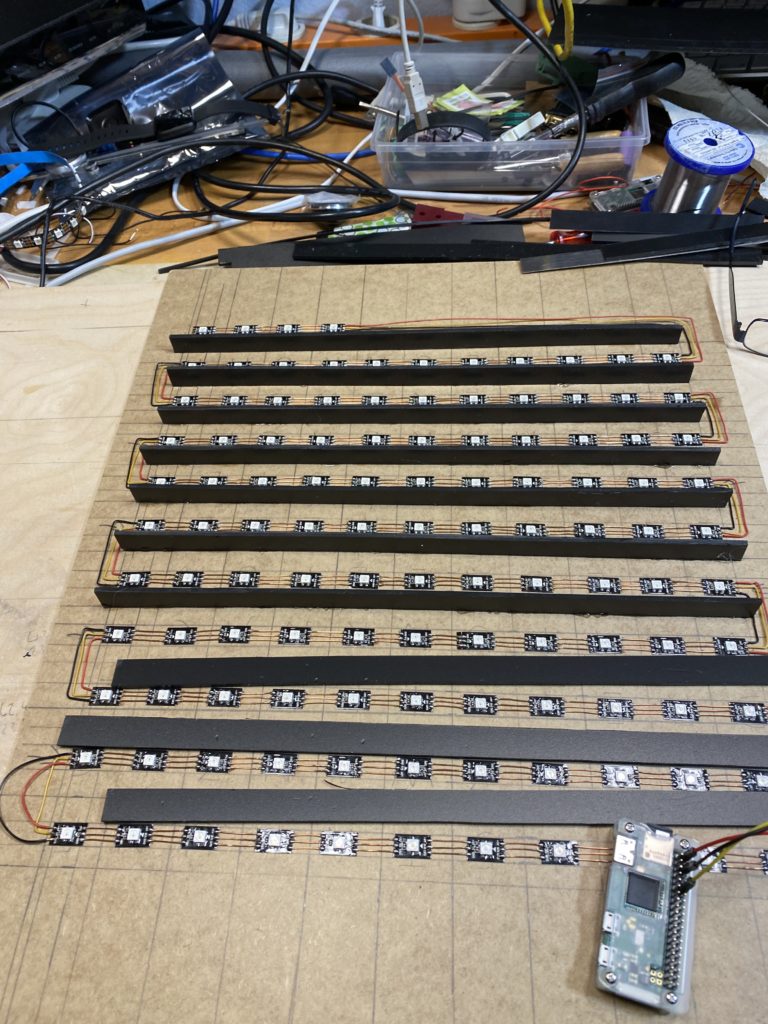

Achtung Spoiler: Es wird eine Word Uhr 😉

Aber was ist das, außer das es bunt ist ?

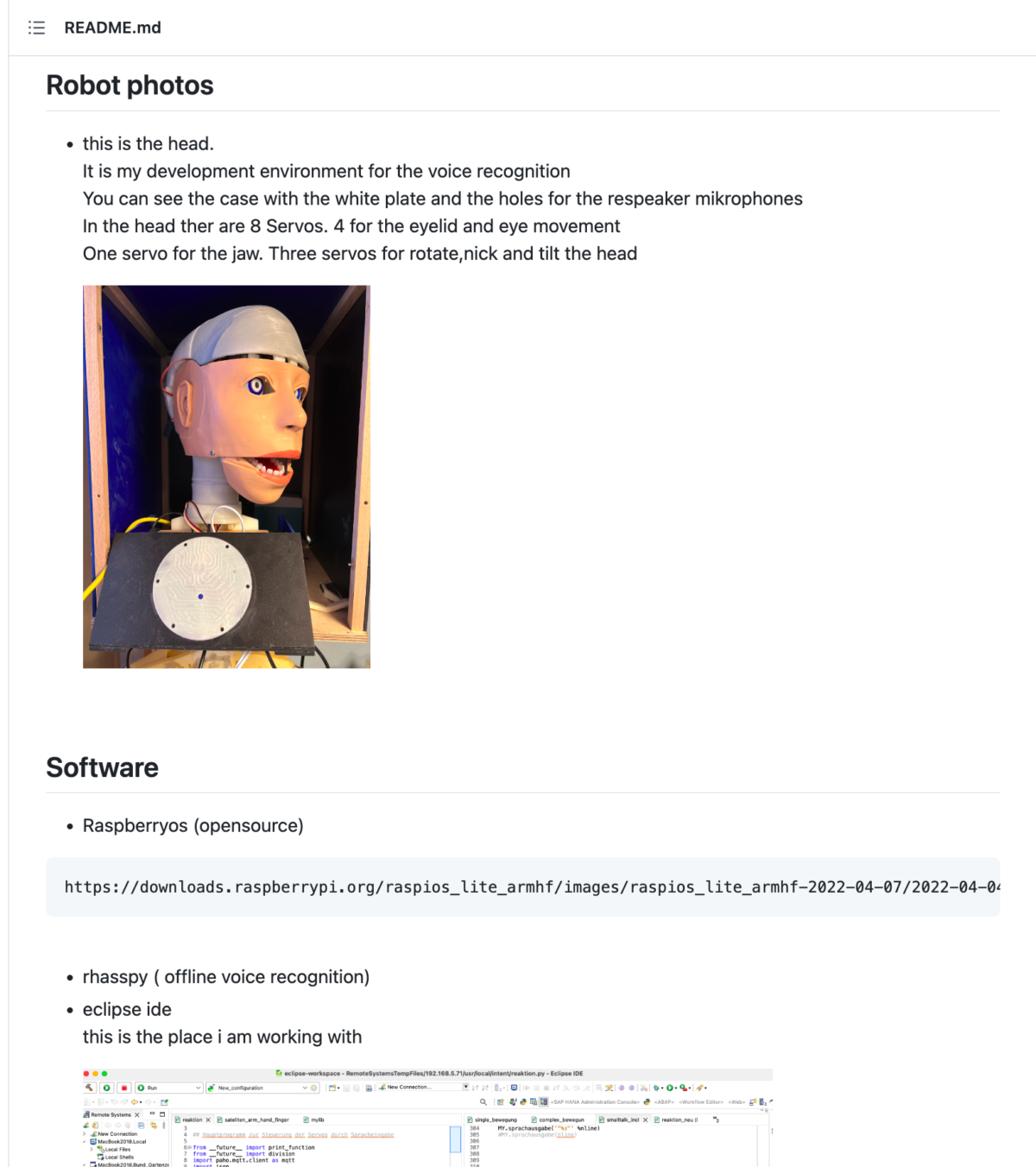

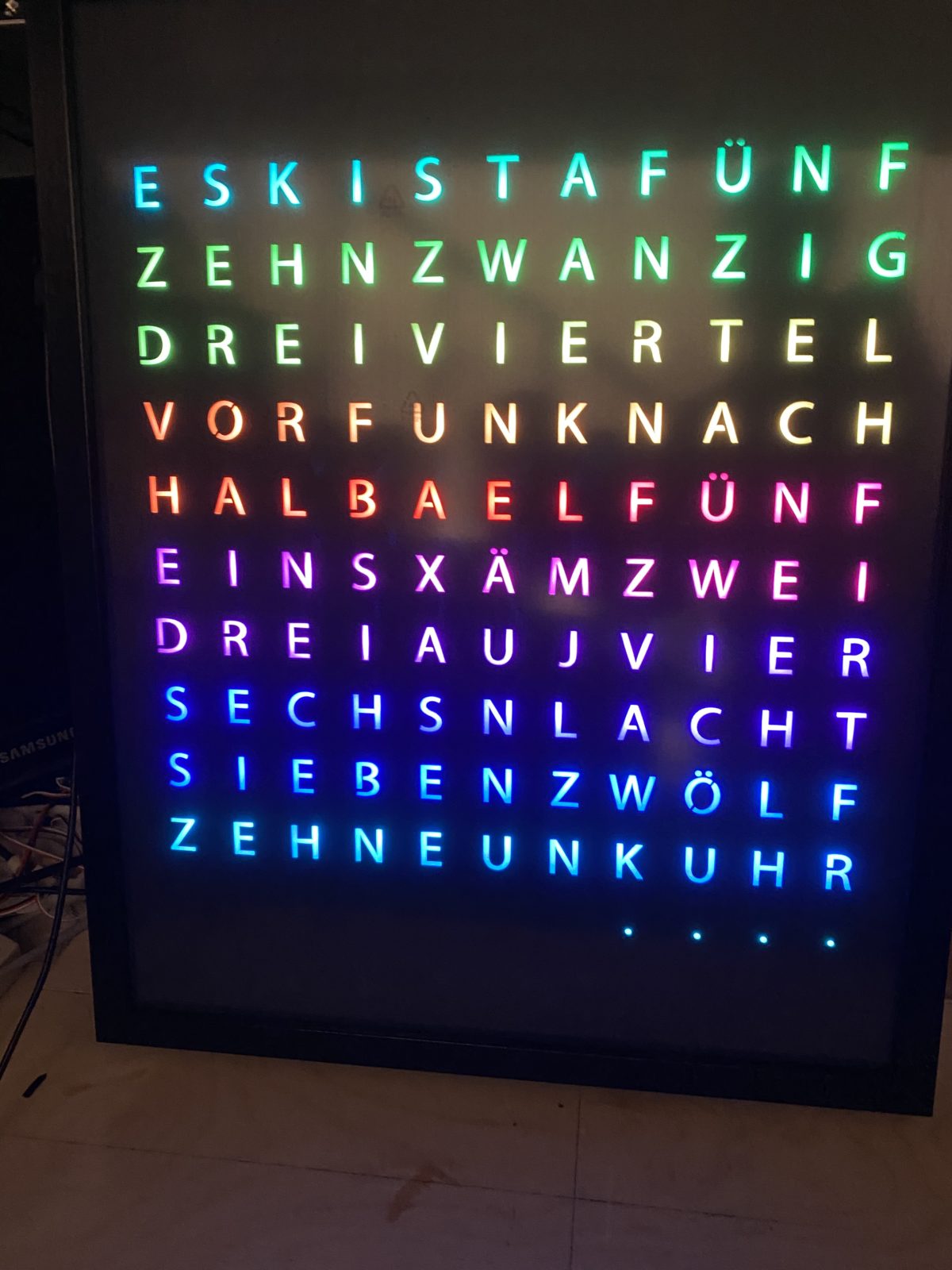

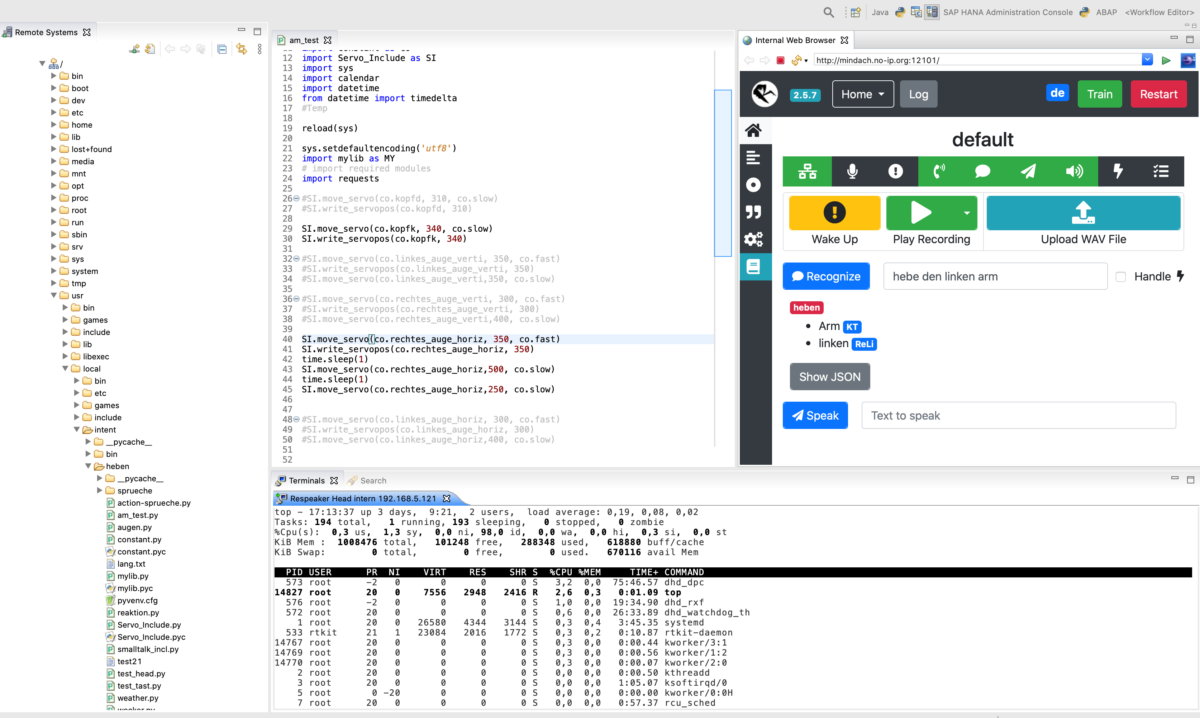

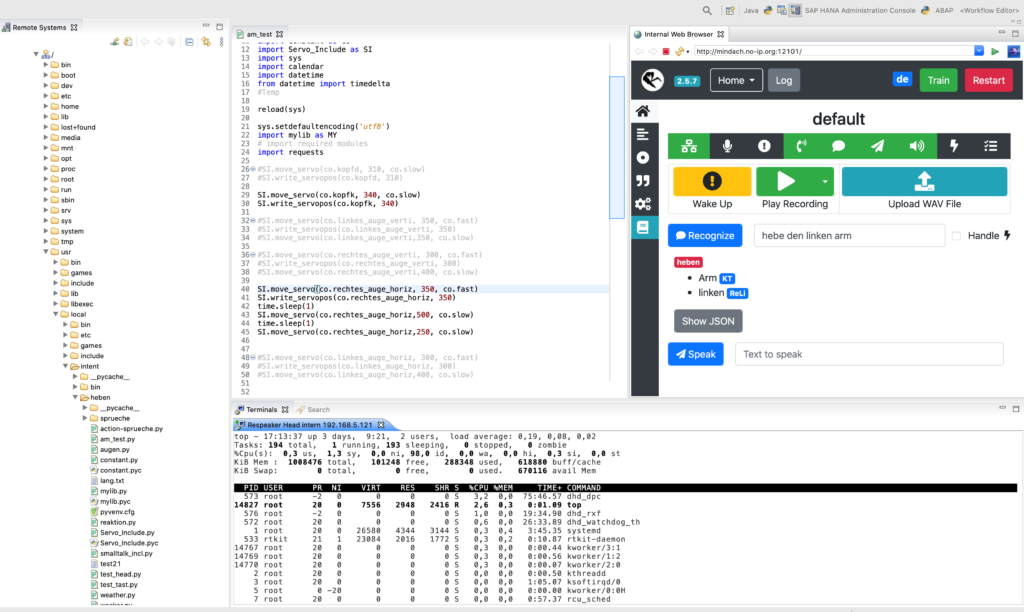

Die eclipse IDE: links der Remote explorer mit dem Zugriff auf den Respeaker Core v2.

In der Mitte die Python Datei zum Testen. Rechts die Weboberfläche für Rhasspy.

Unten der ssh Zugriff auf den Respeaker Core v2 mit einem Debian OS und der Ausgabe von Top.

Auf dem Respeaker läuft ein Docker Image mit Rhasspy 2.5.7 .

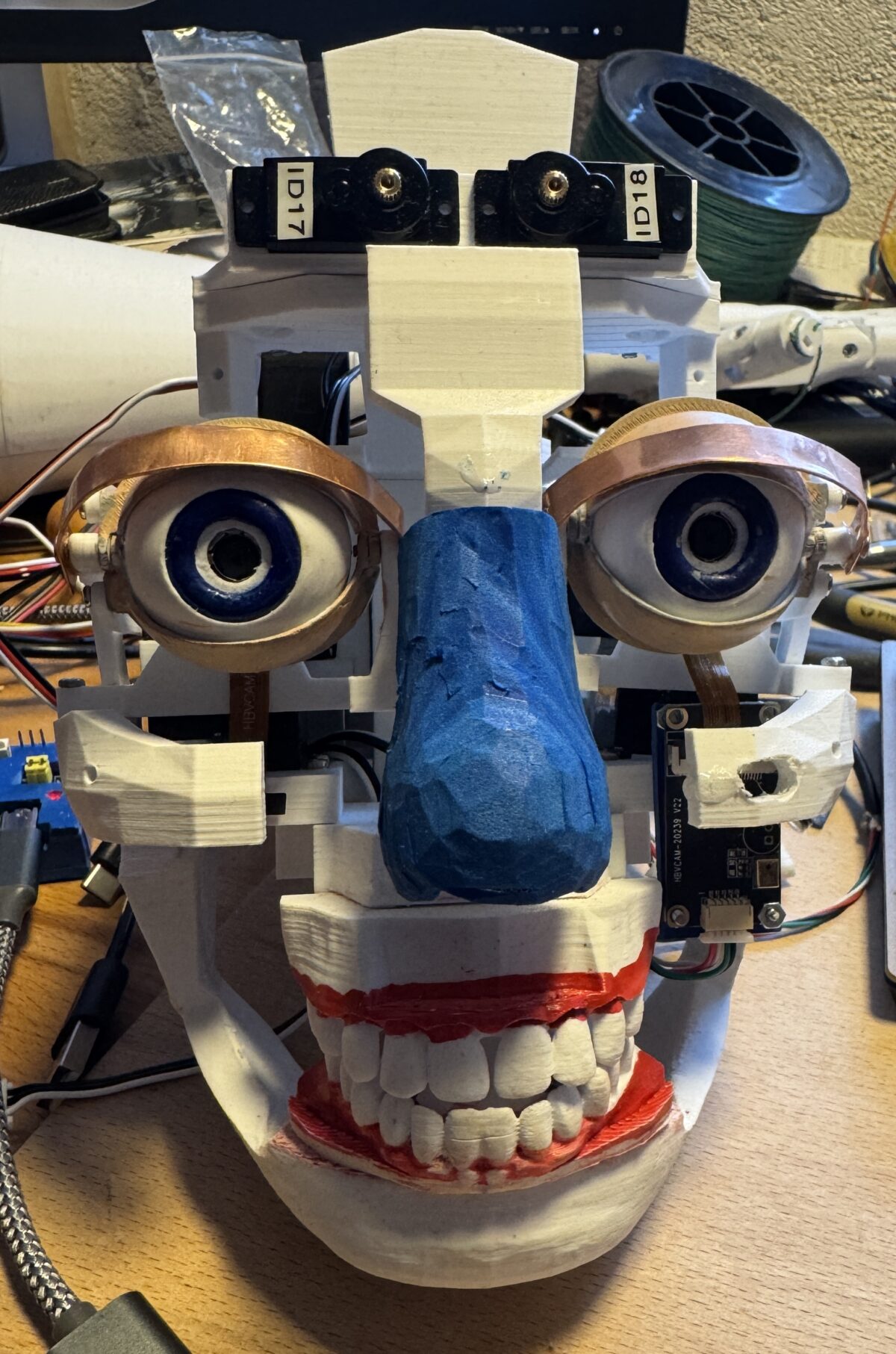

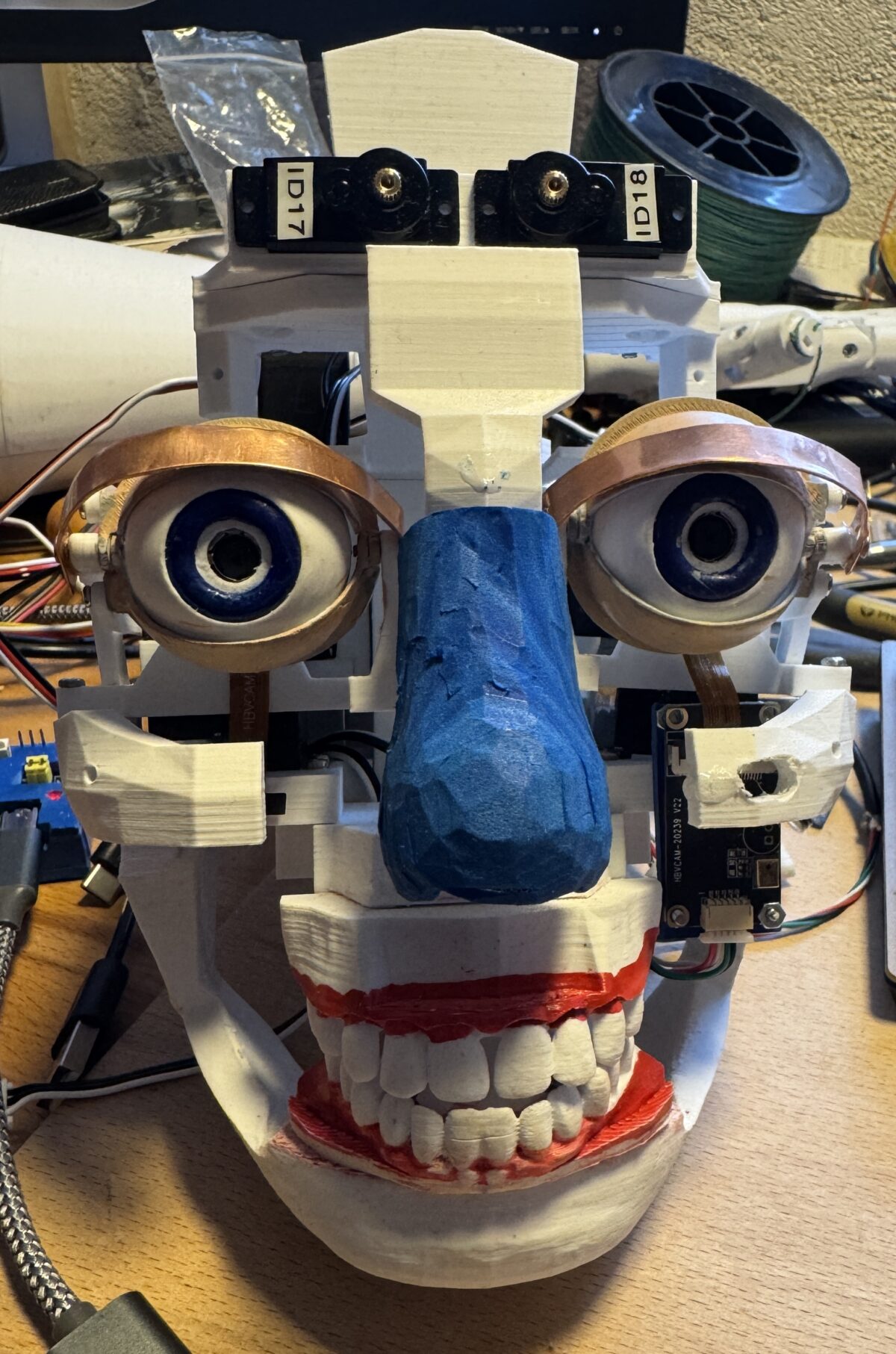

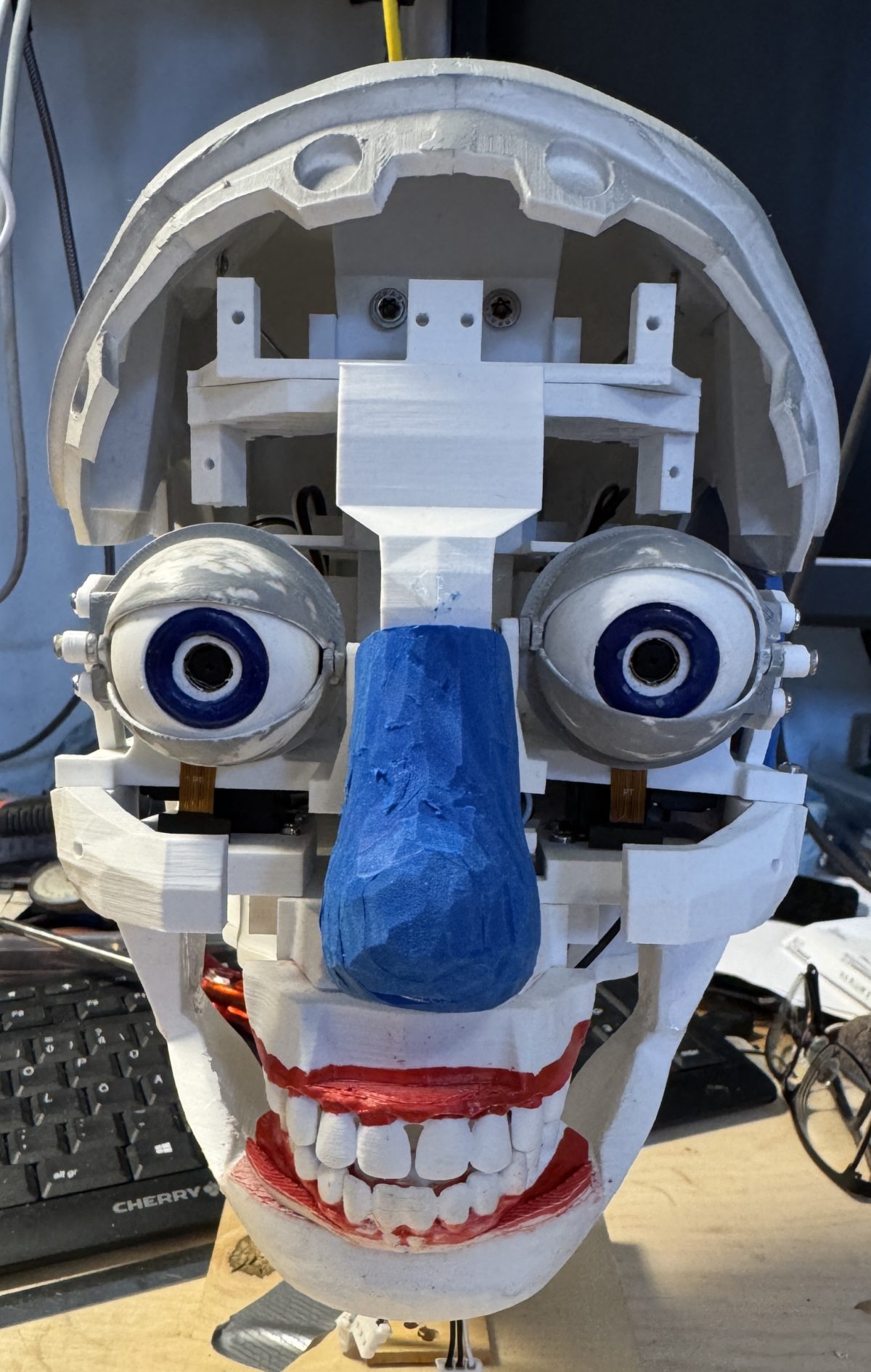

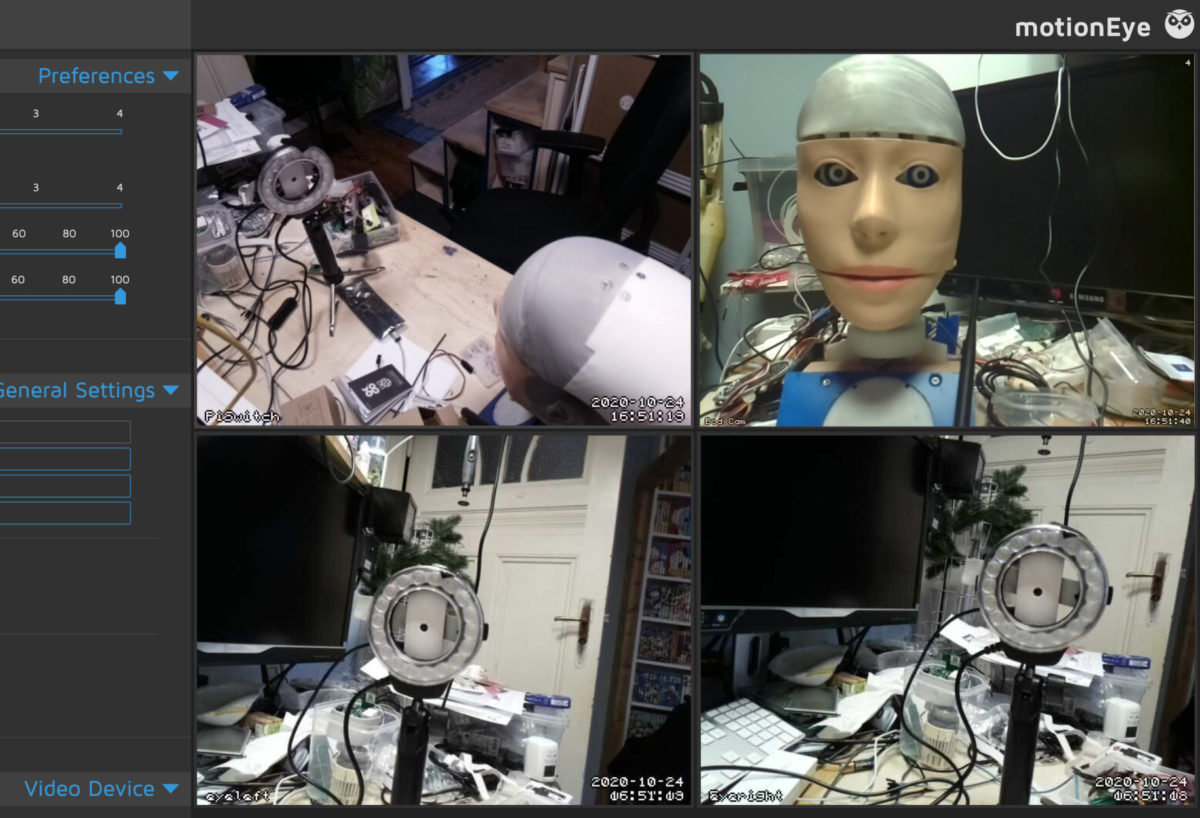

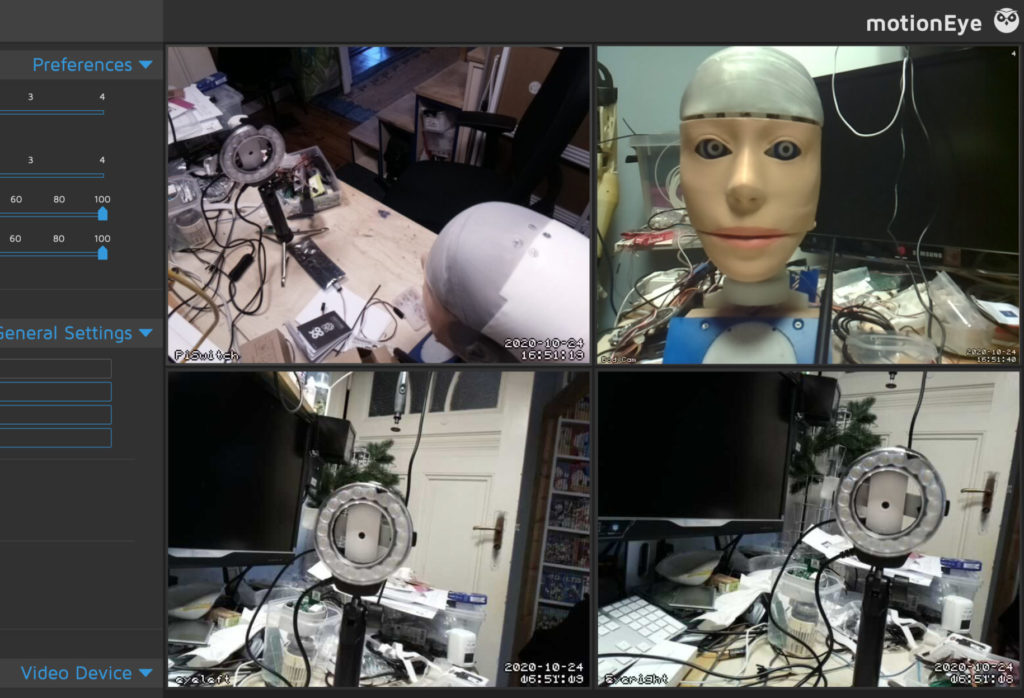

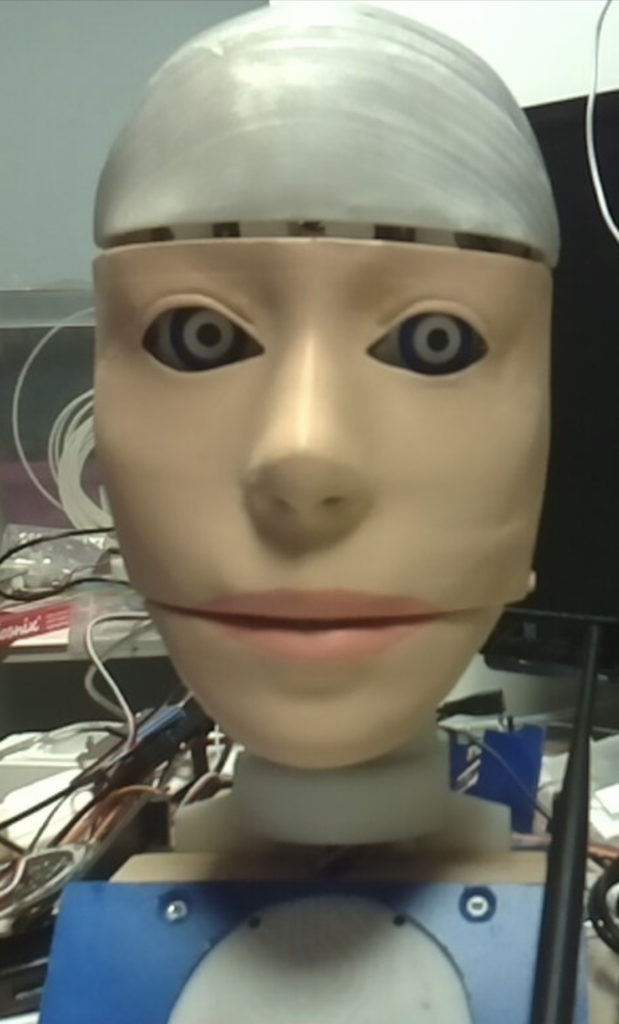

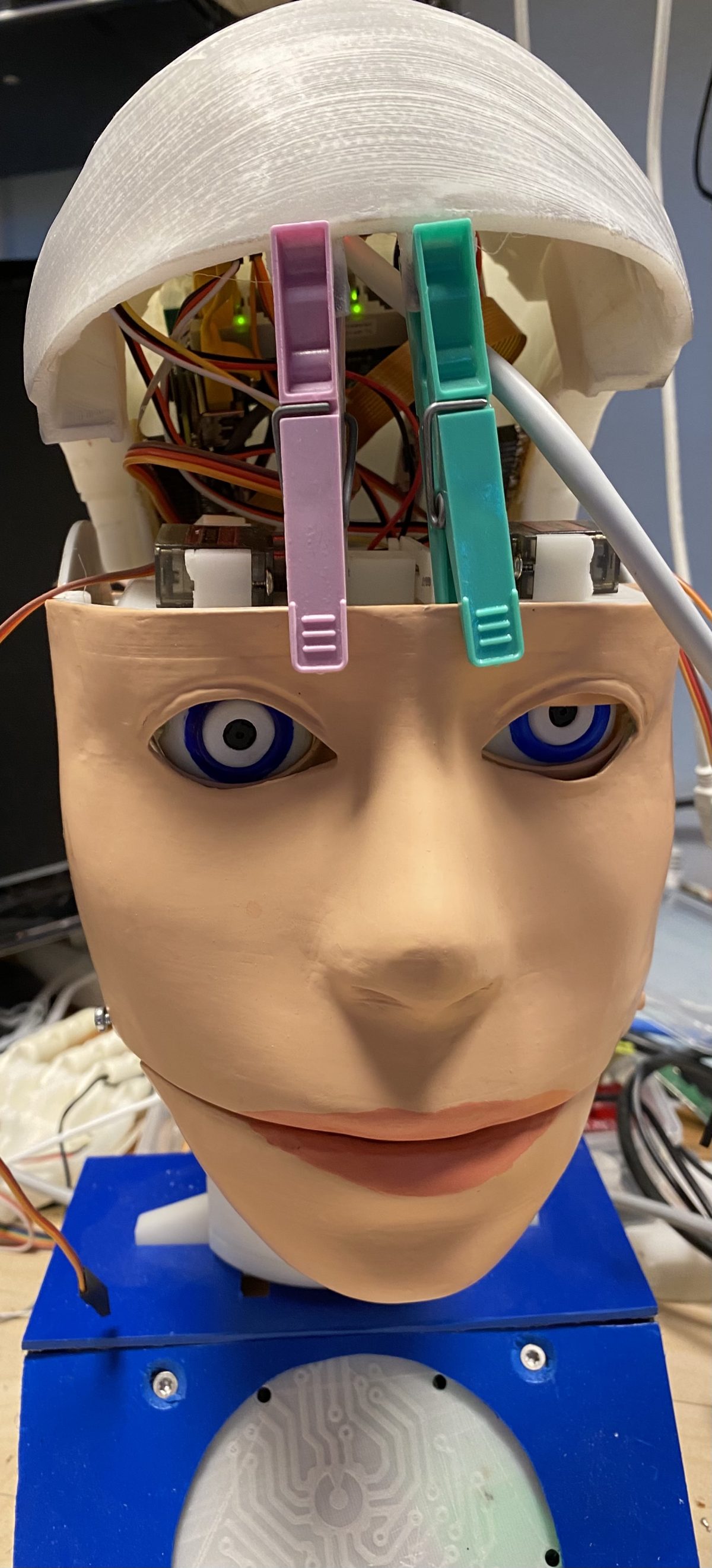

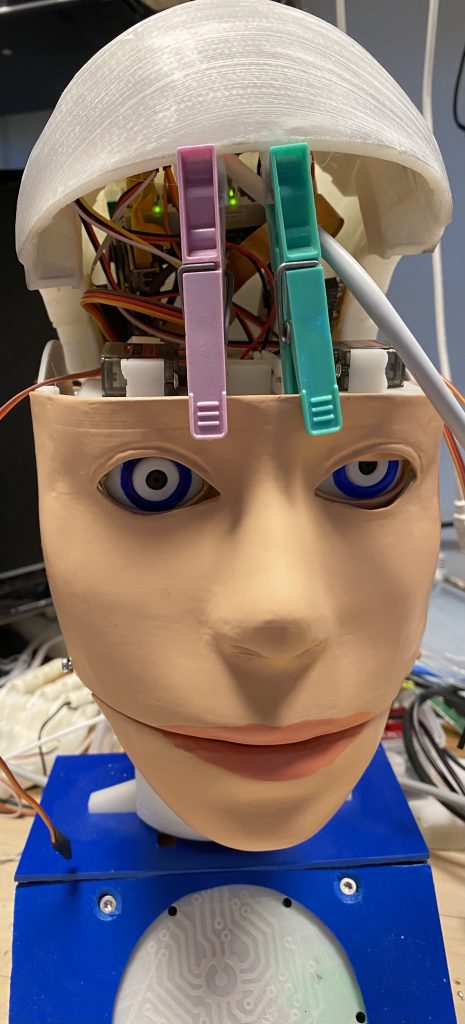

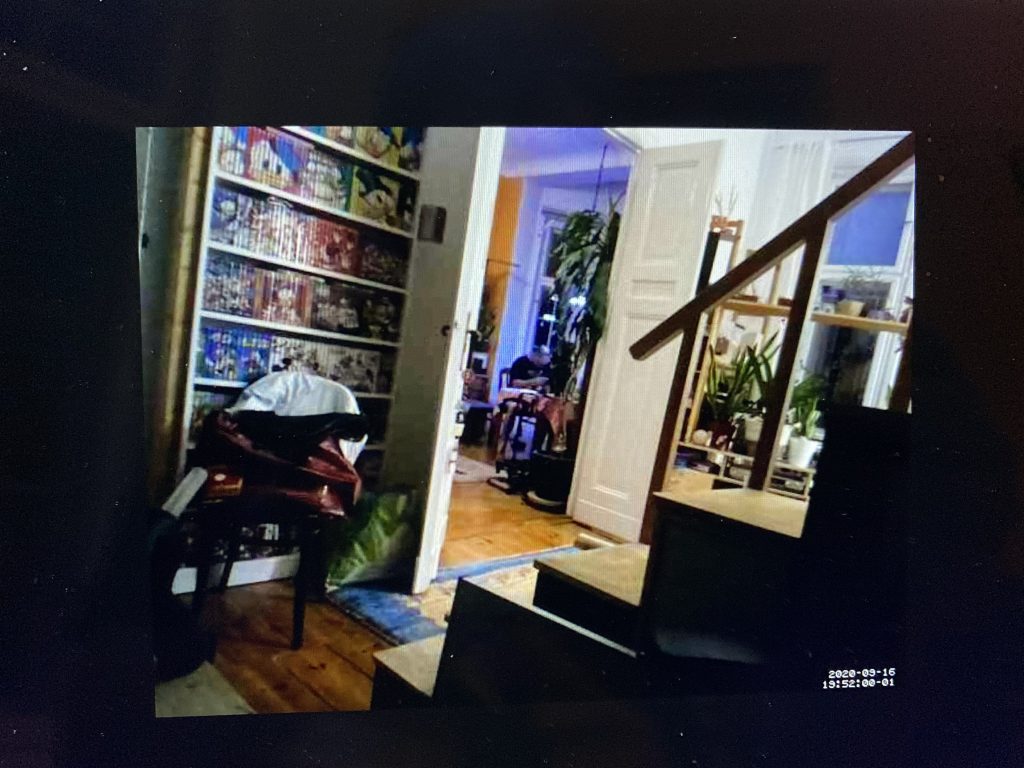

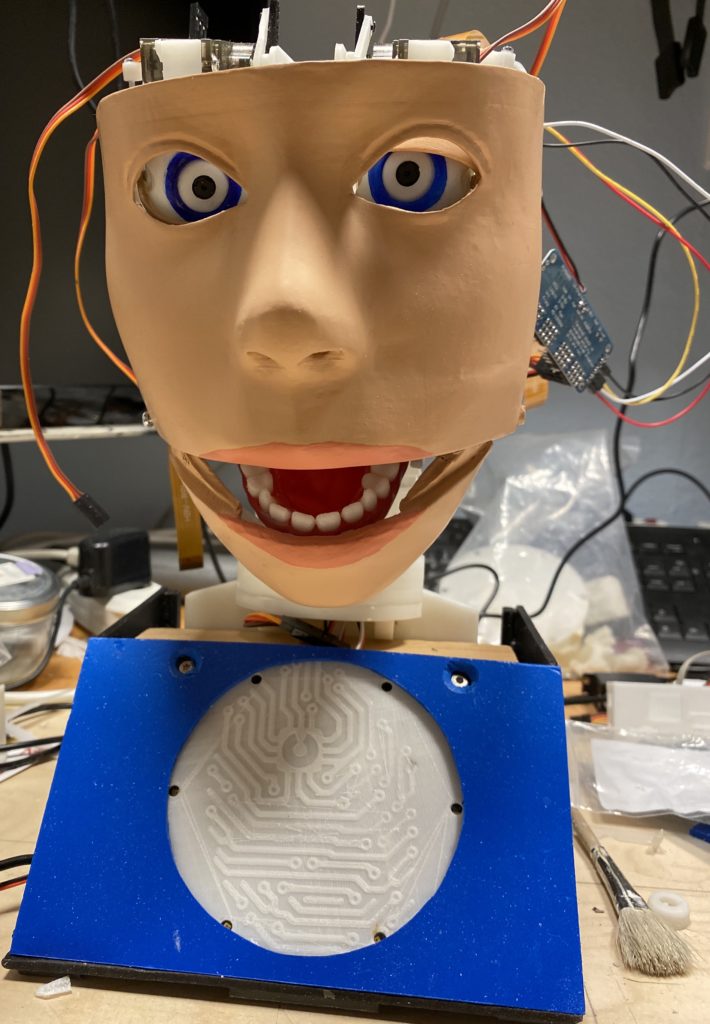

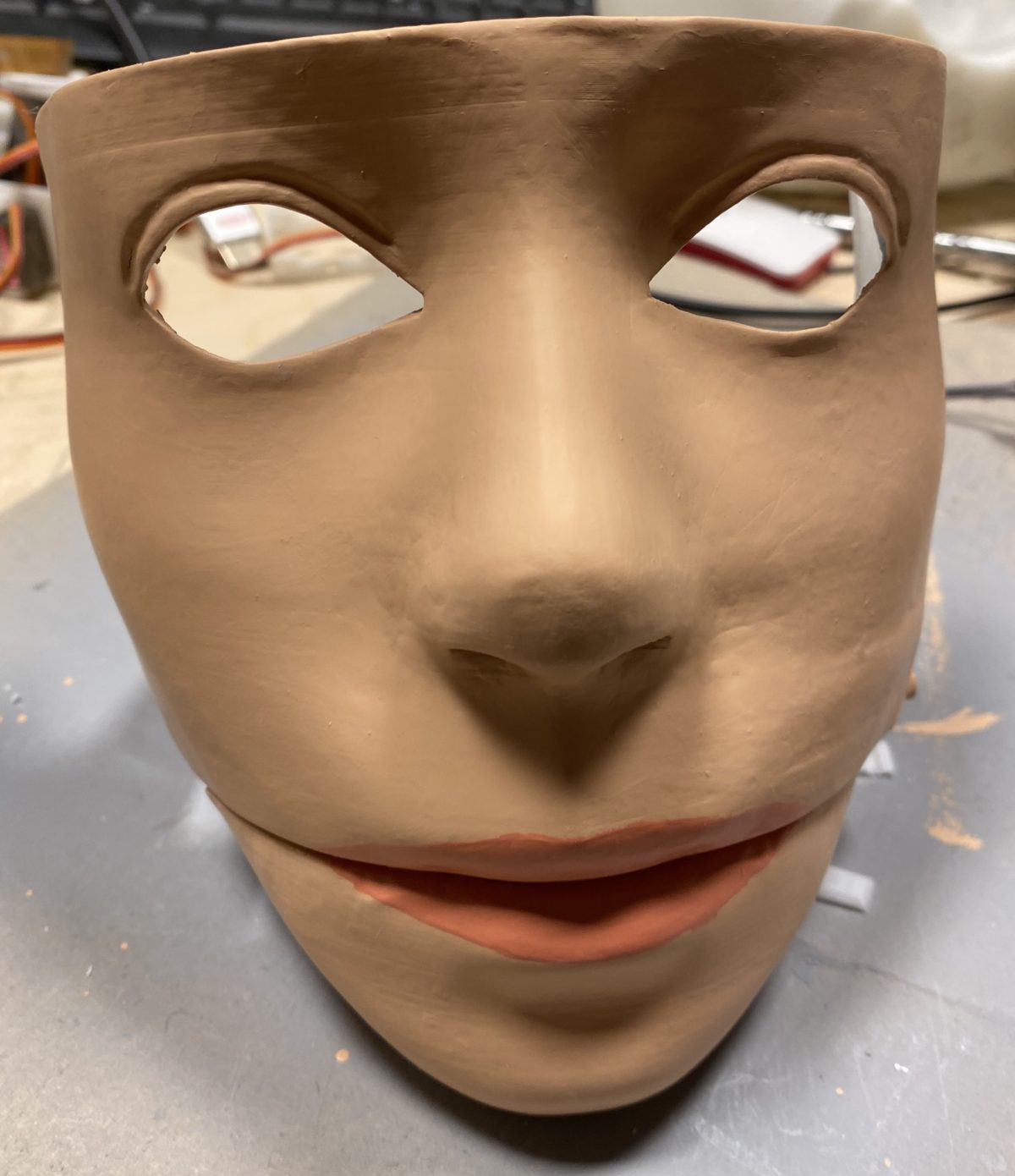

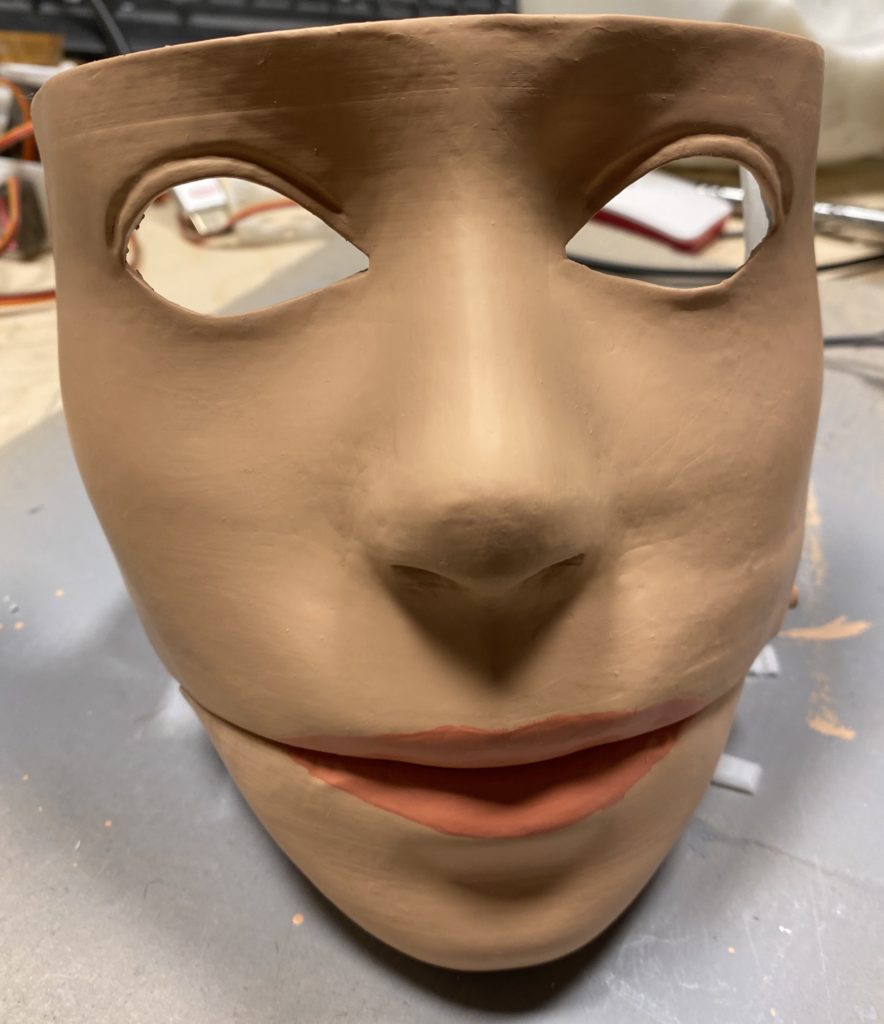

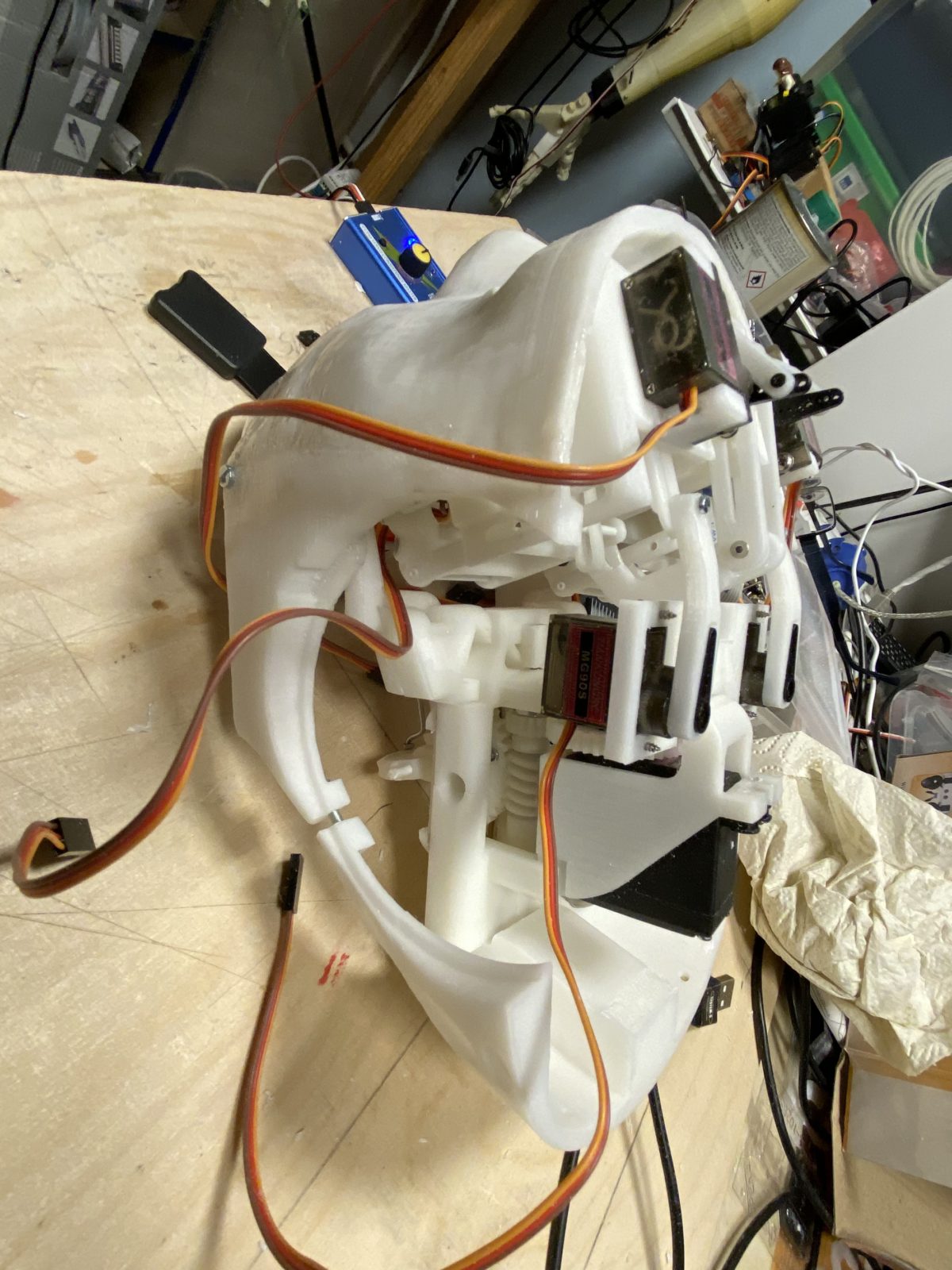

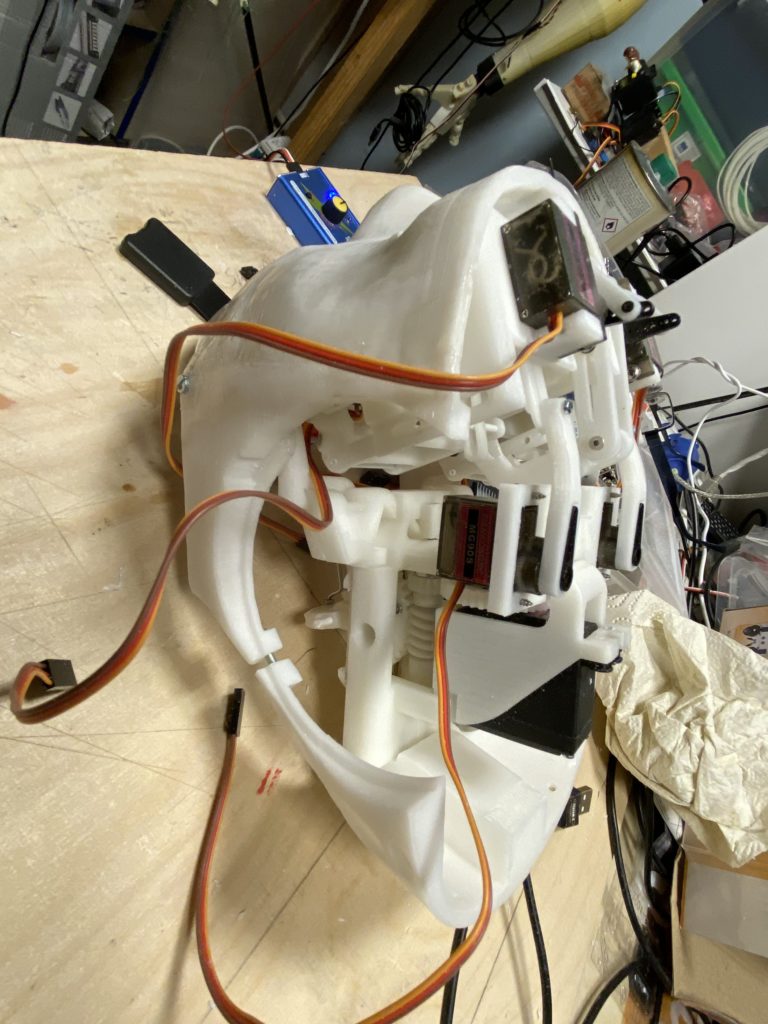

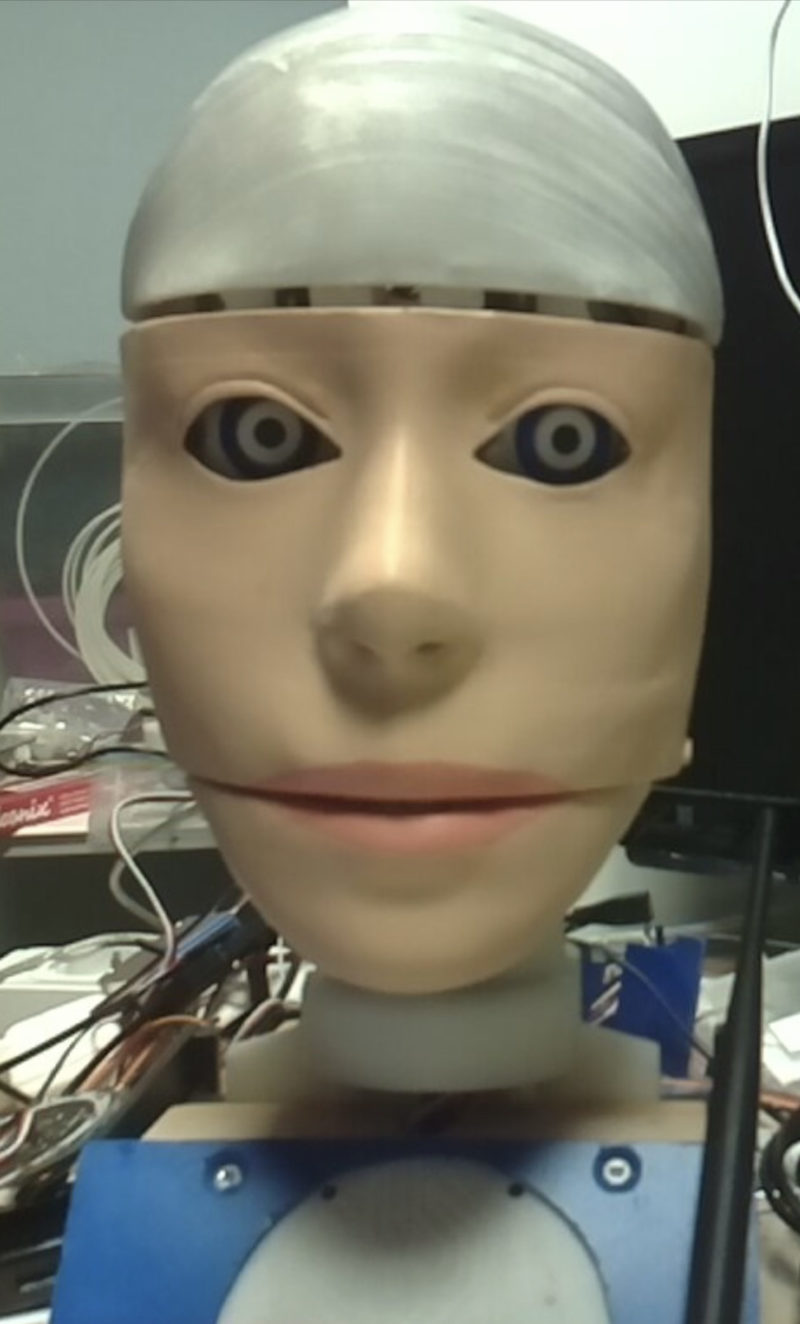

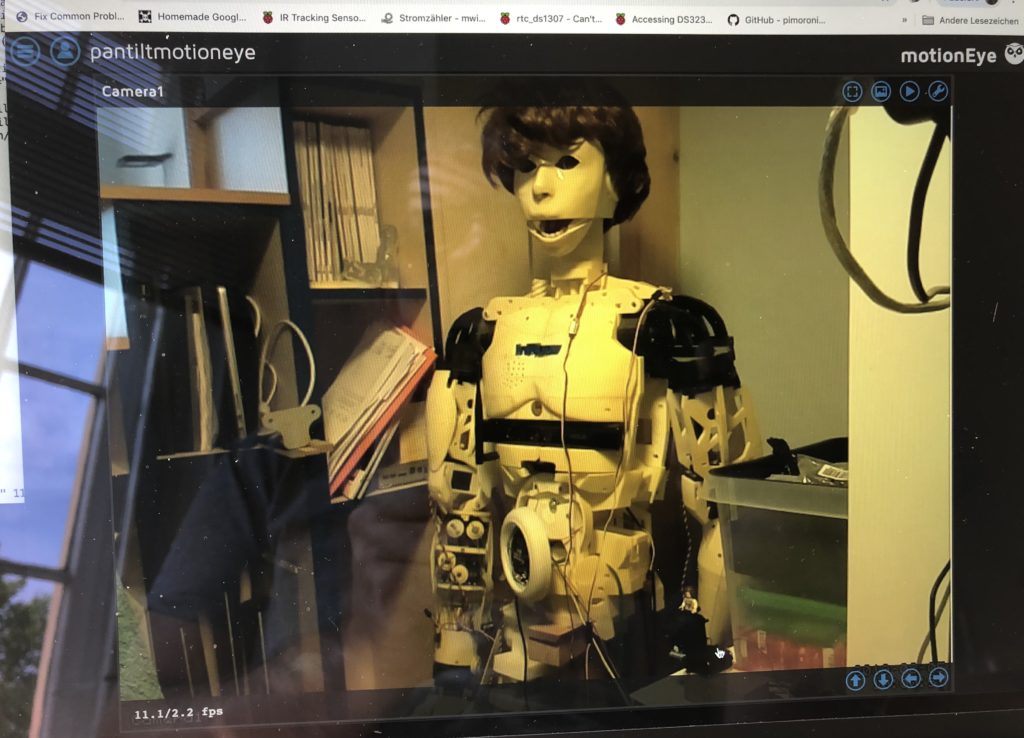

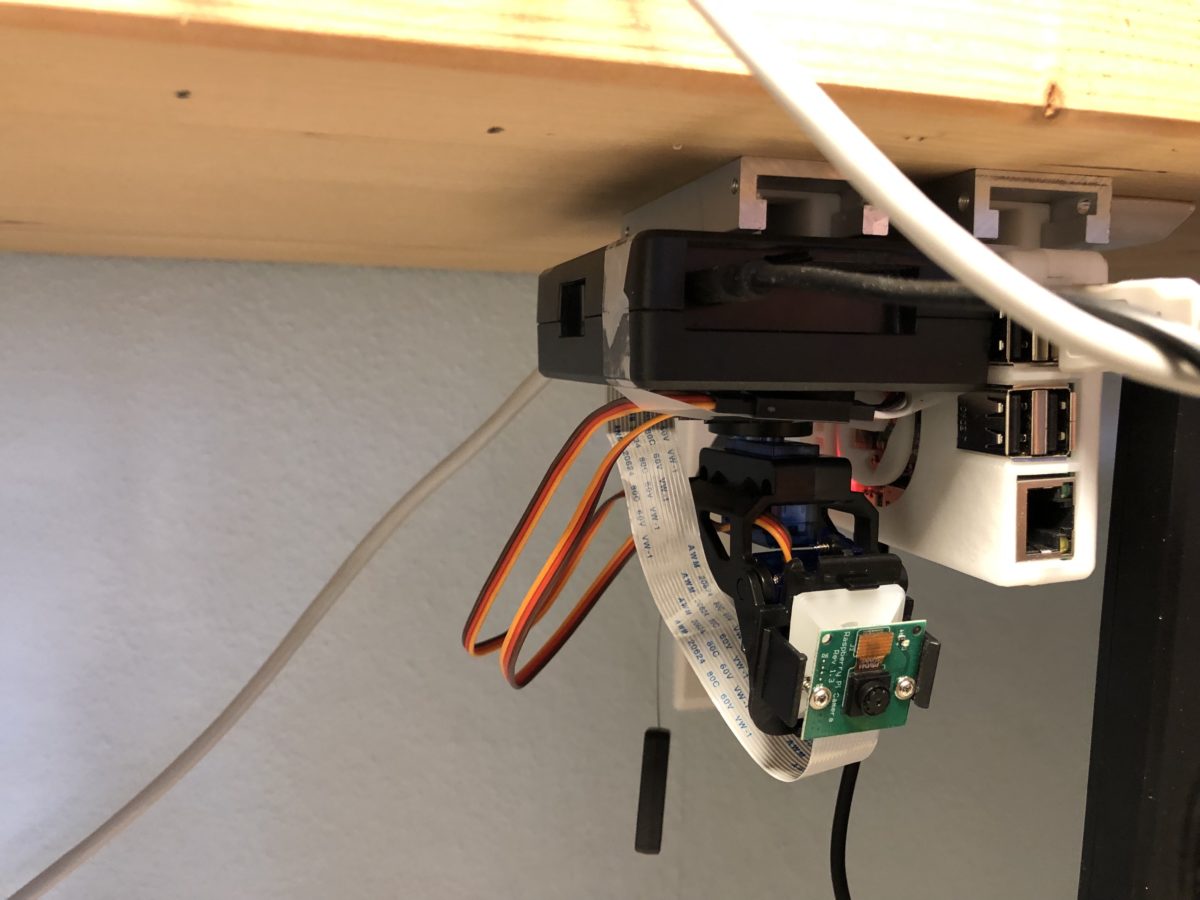

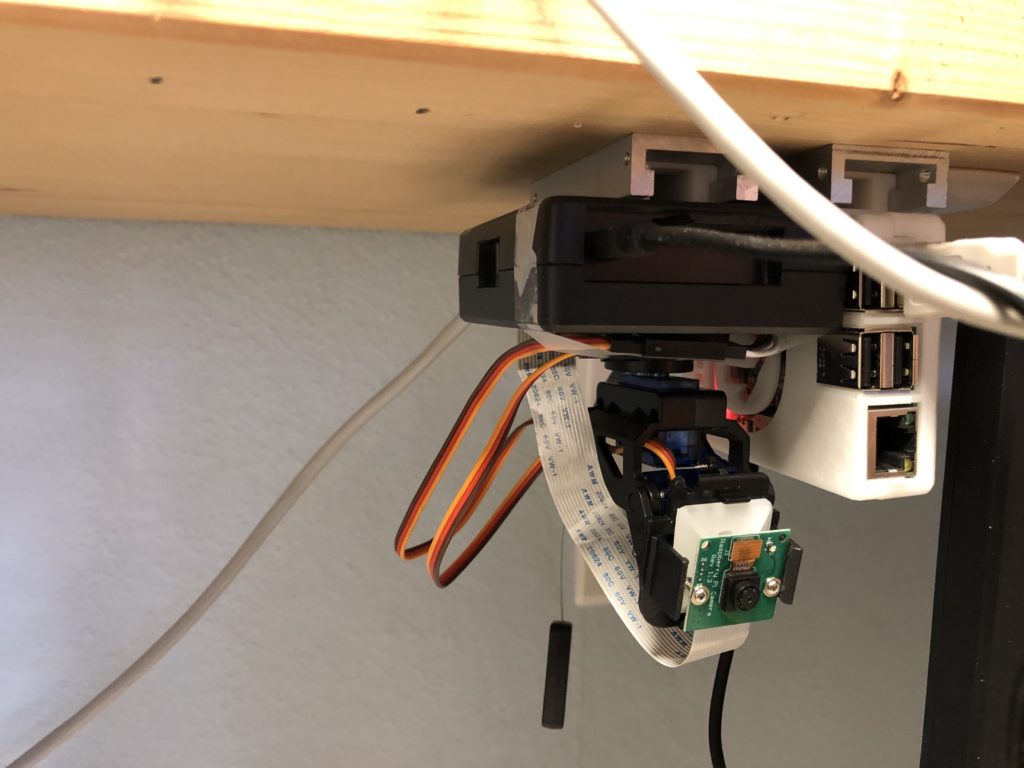

Die Augenkameras zeigen die Lampe die vom Server bei Dunkelheit angeschaltet werden kann

Im oberen Bild sieht man rechts oben die Werkstattkamera links oben der Blick auf den Kopf von der BodyCam.

Unten rechts ist die rechte Augenkamera unten links die linke Augenkamera

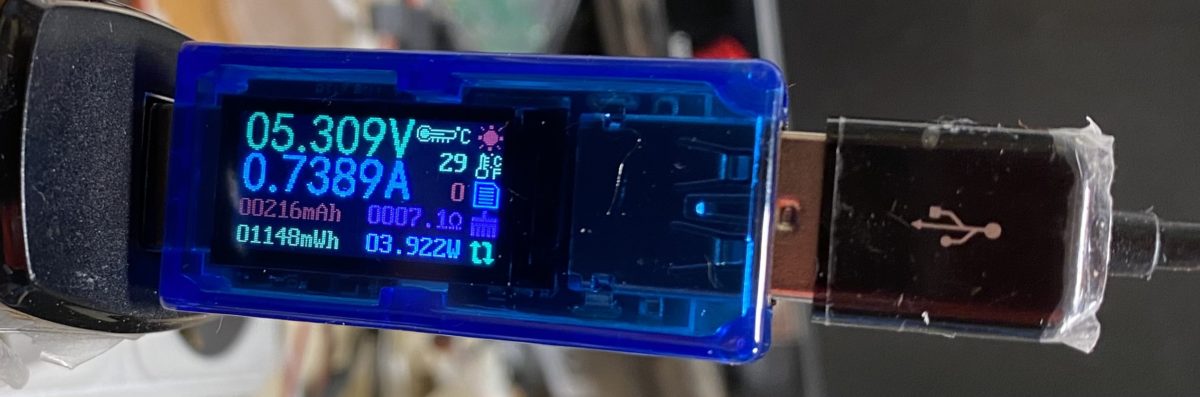

Das ganze mit einem USB-Stick Multimeter gemessen und zeigt den Stromverbrauch des Kopfes

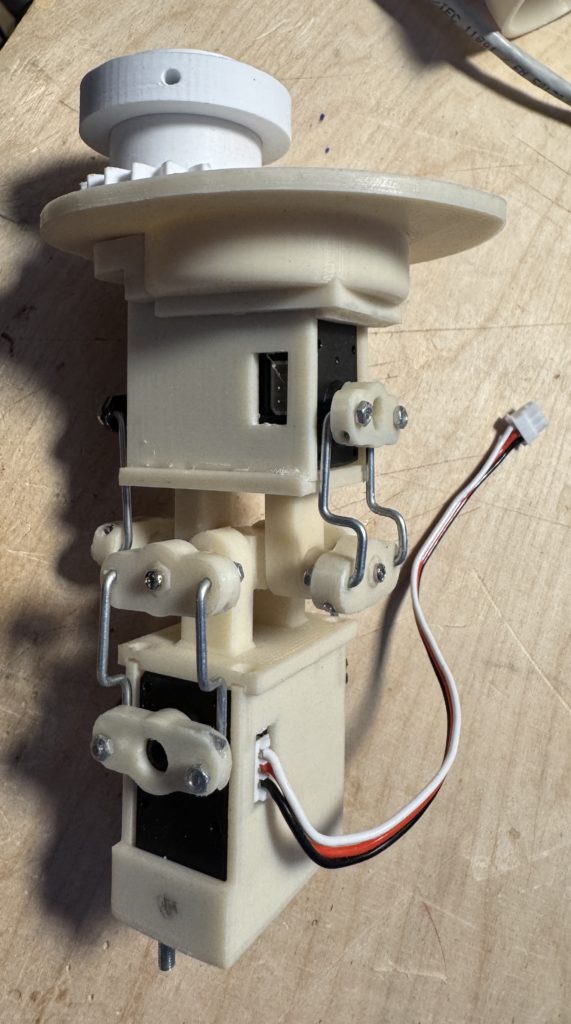

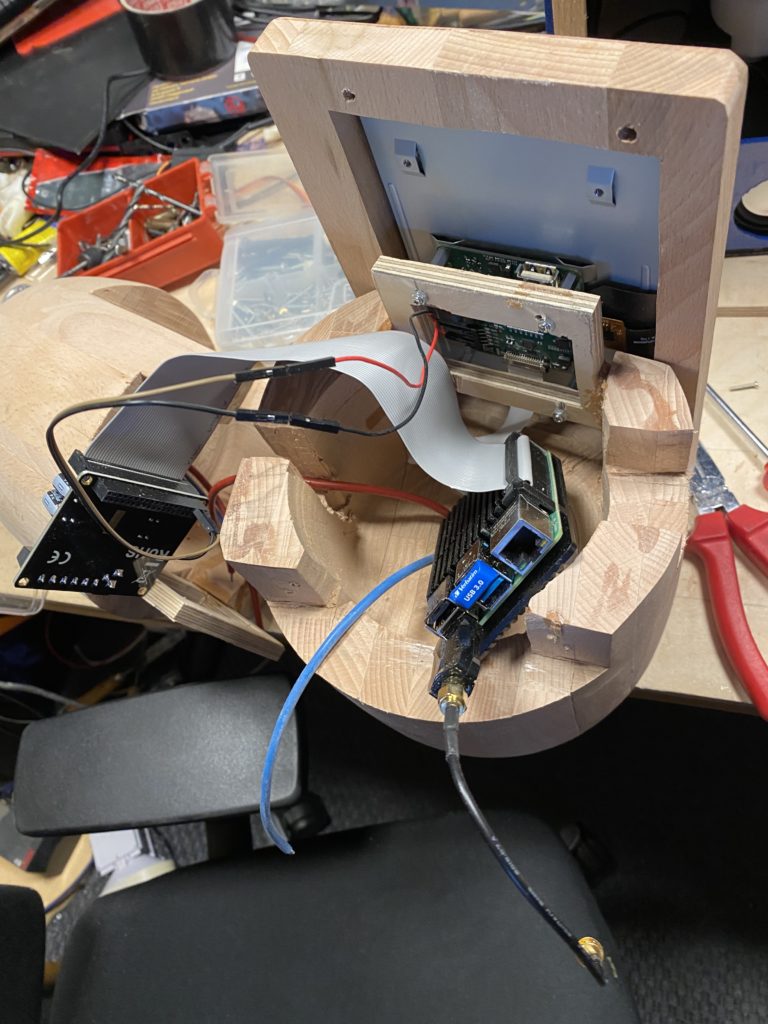

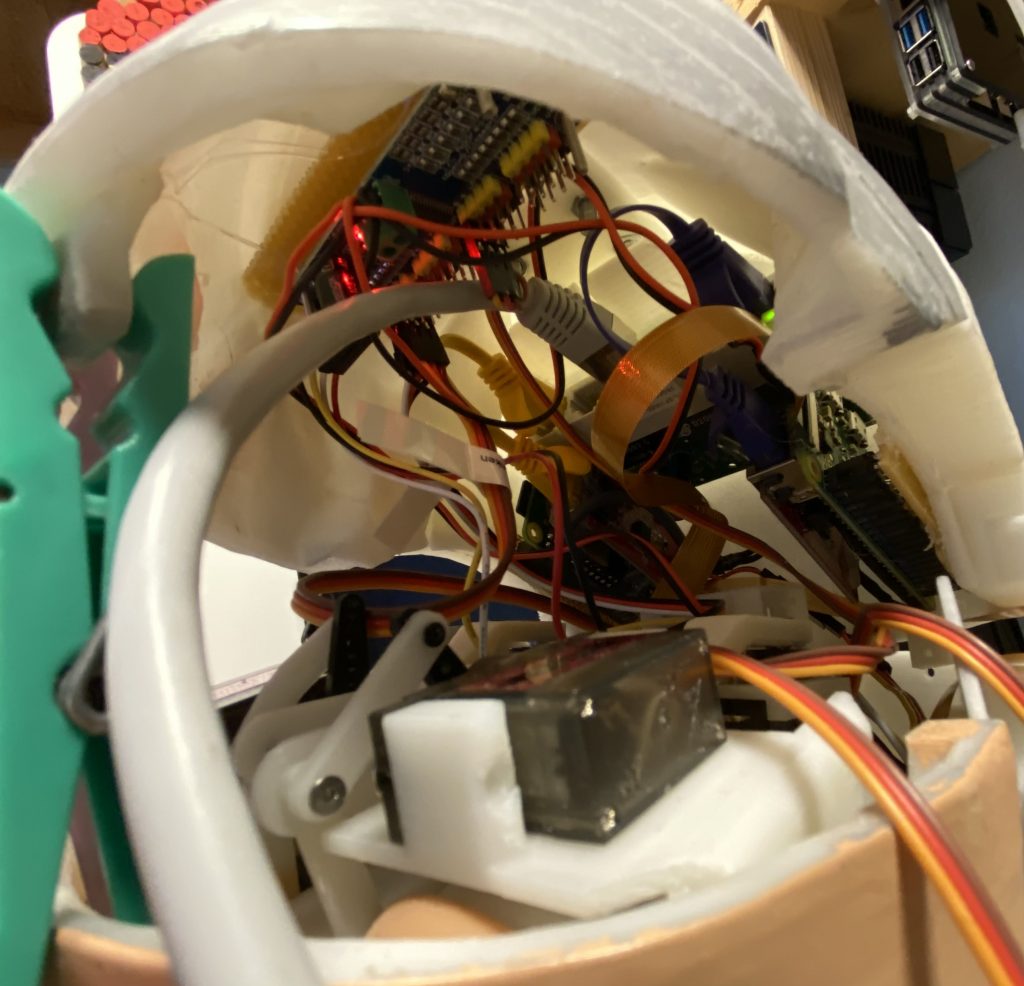

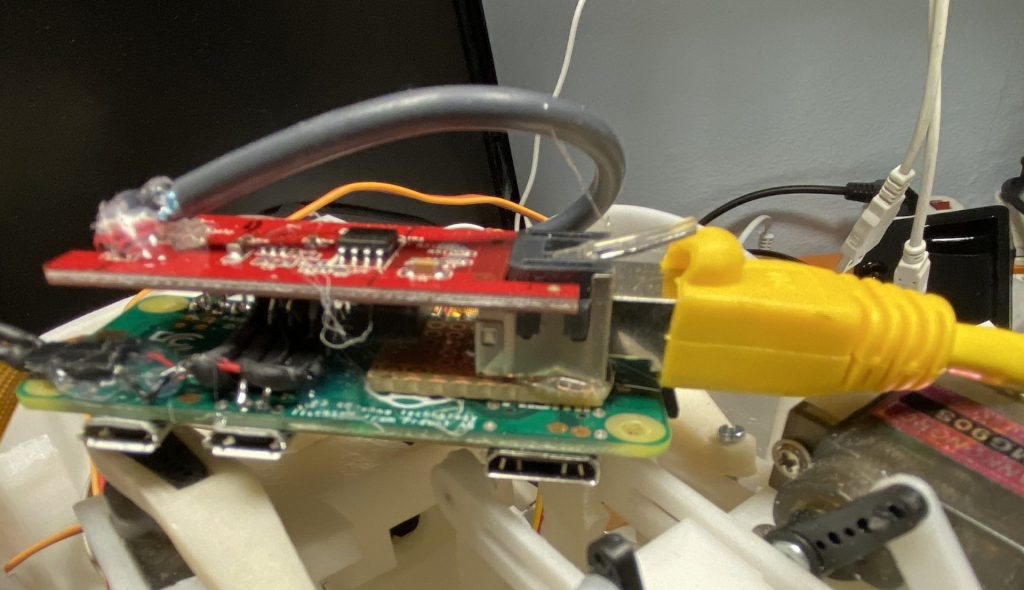

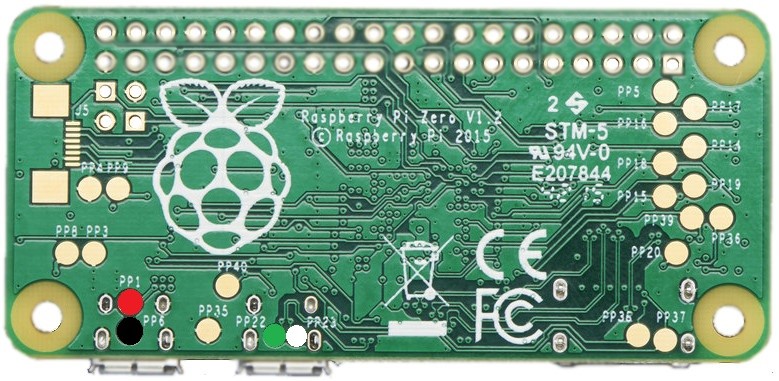

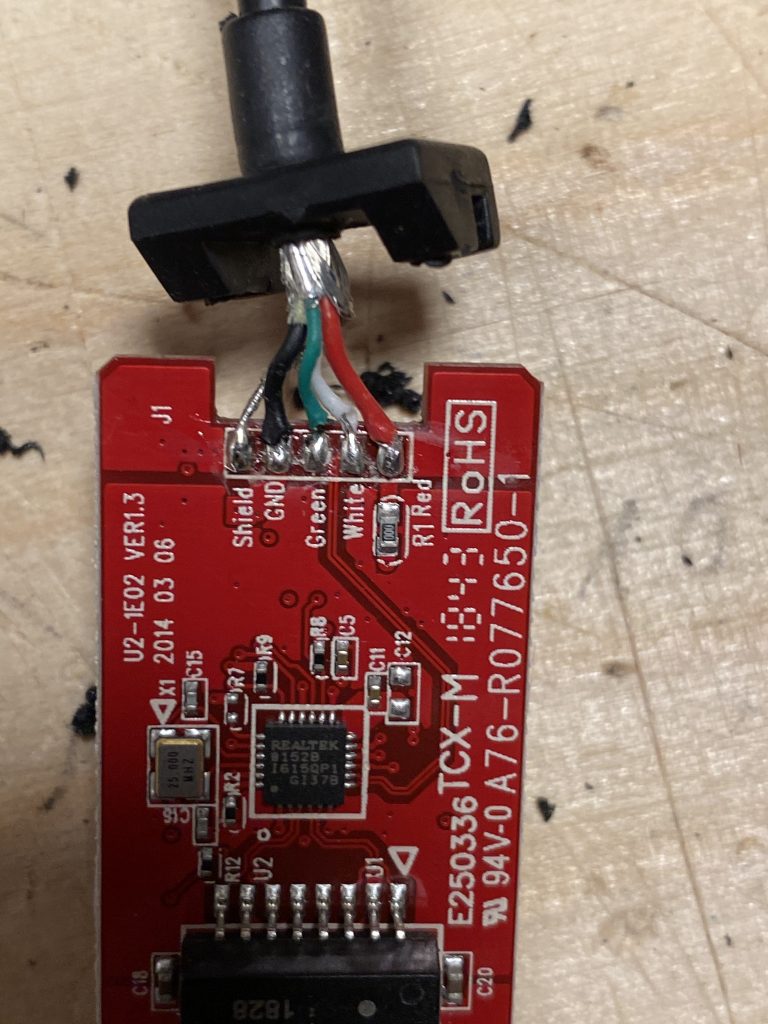

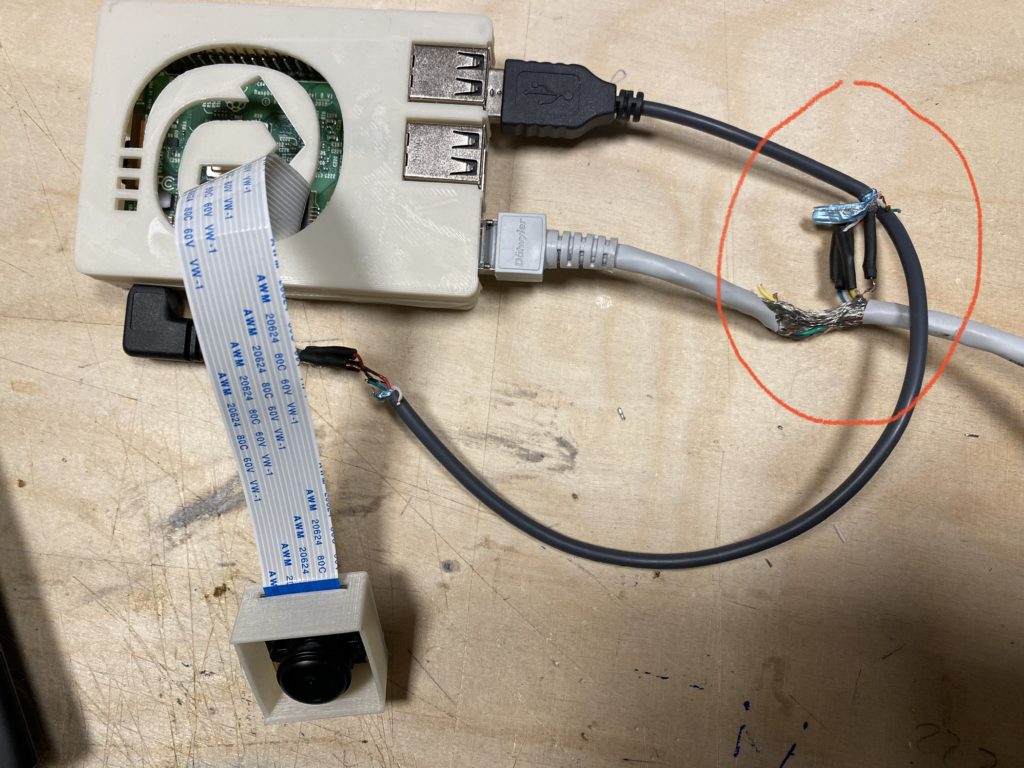

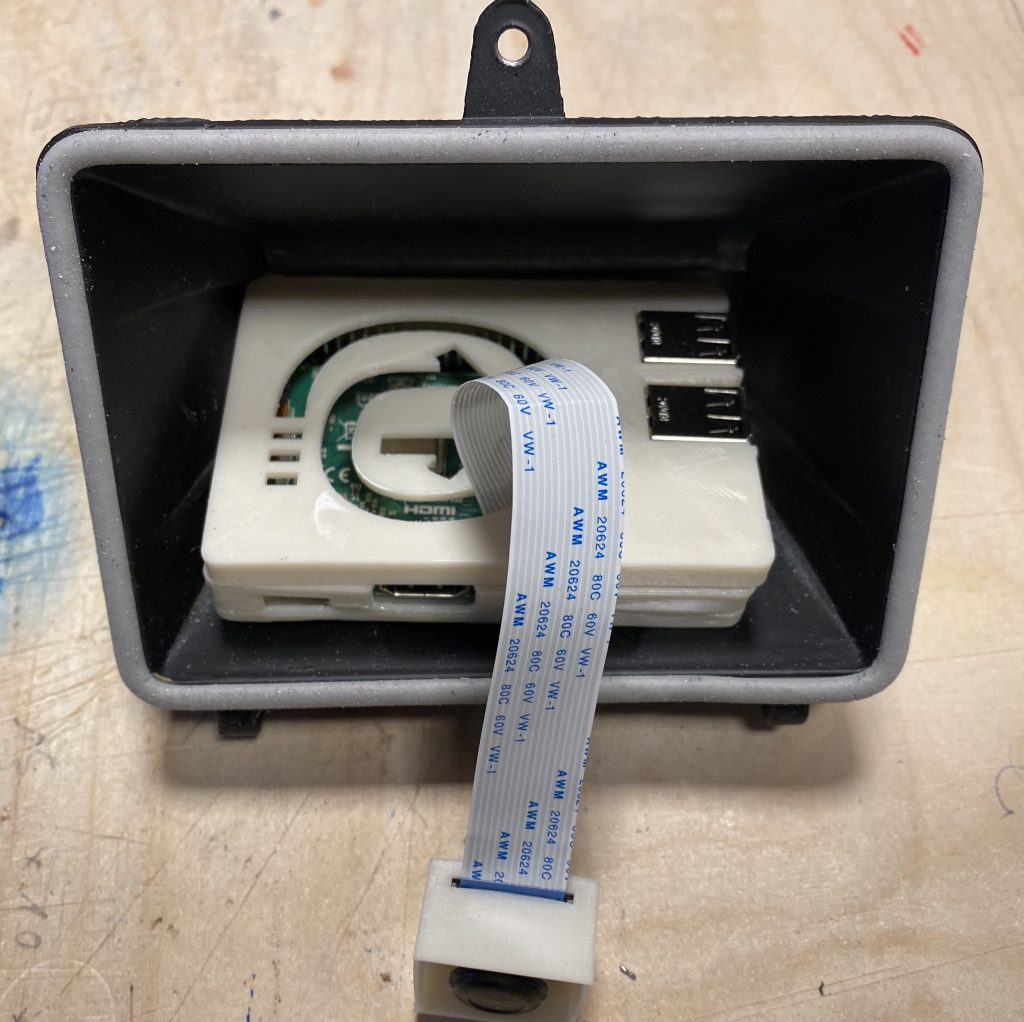

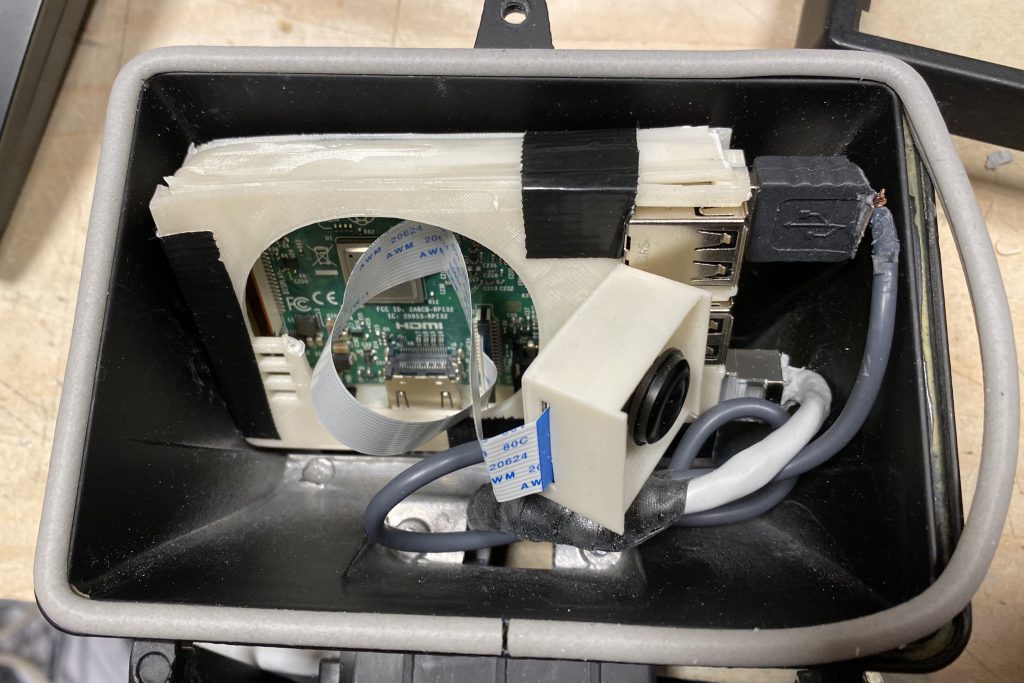

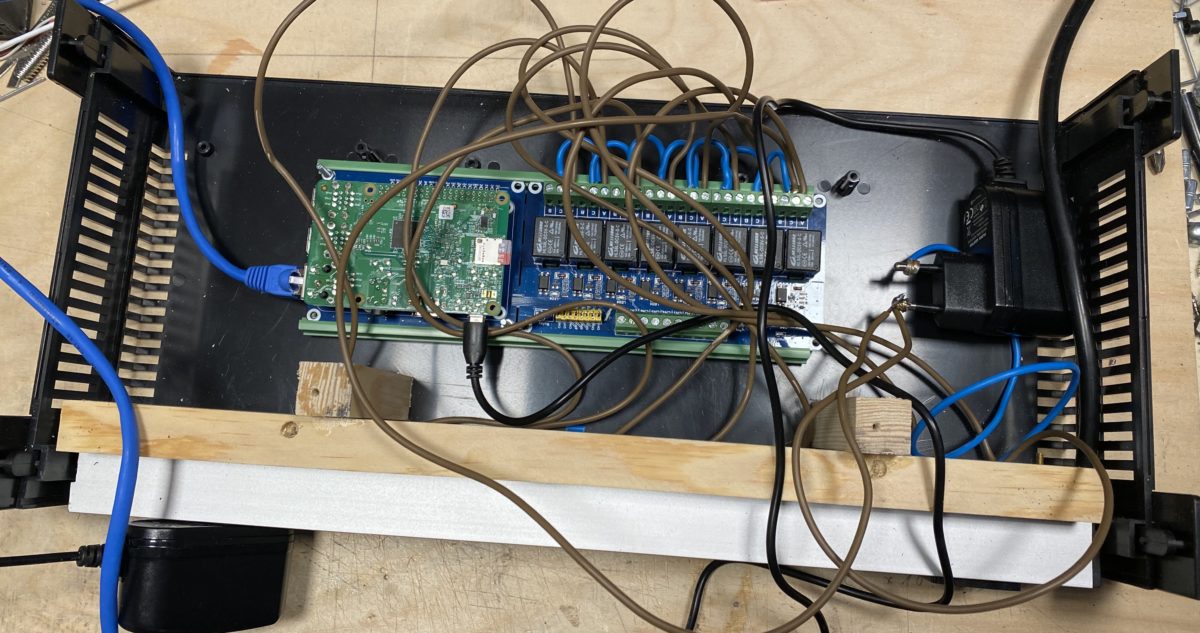

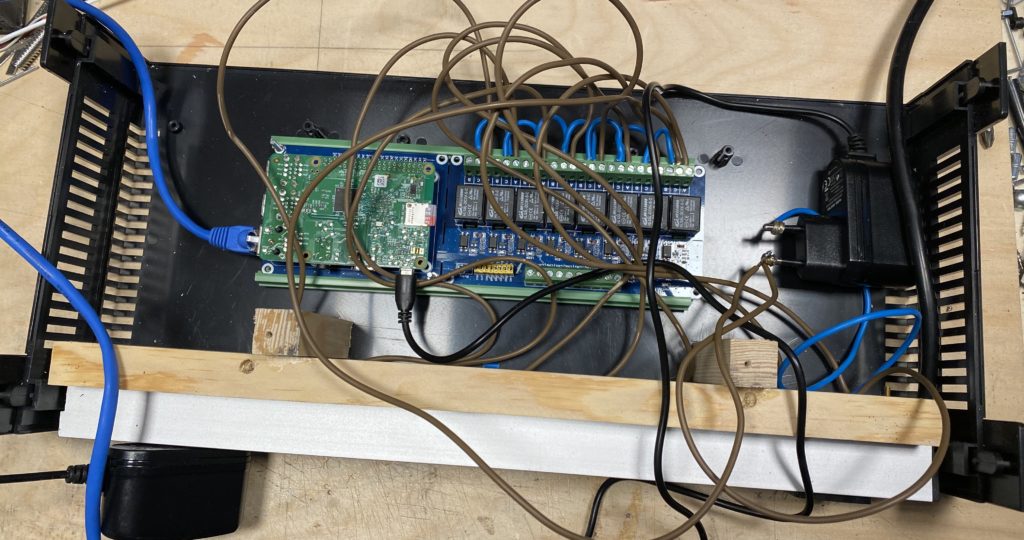

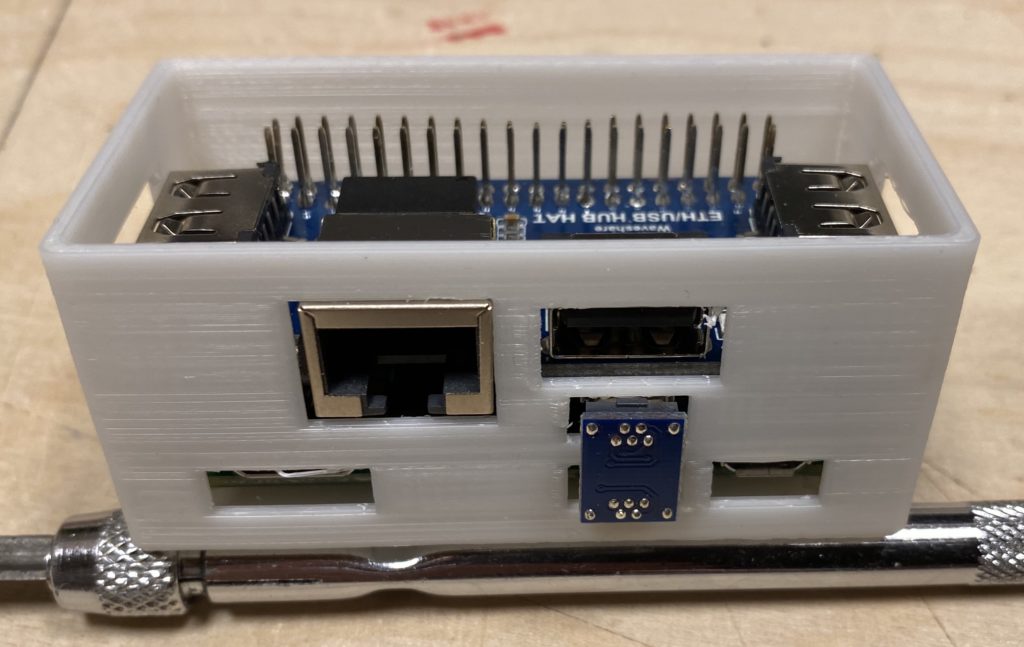

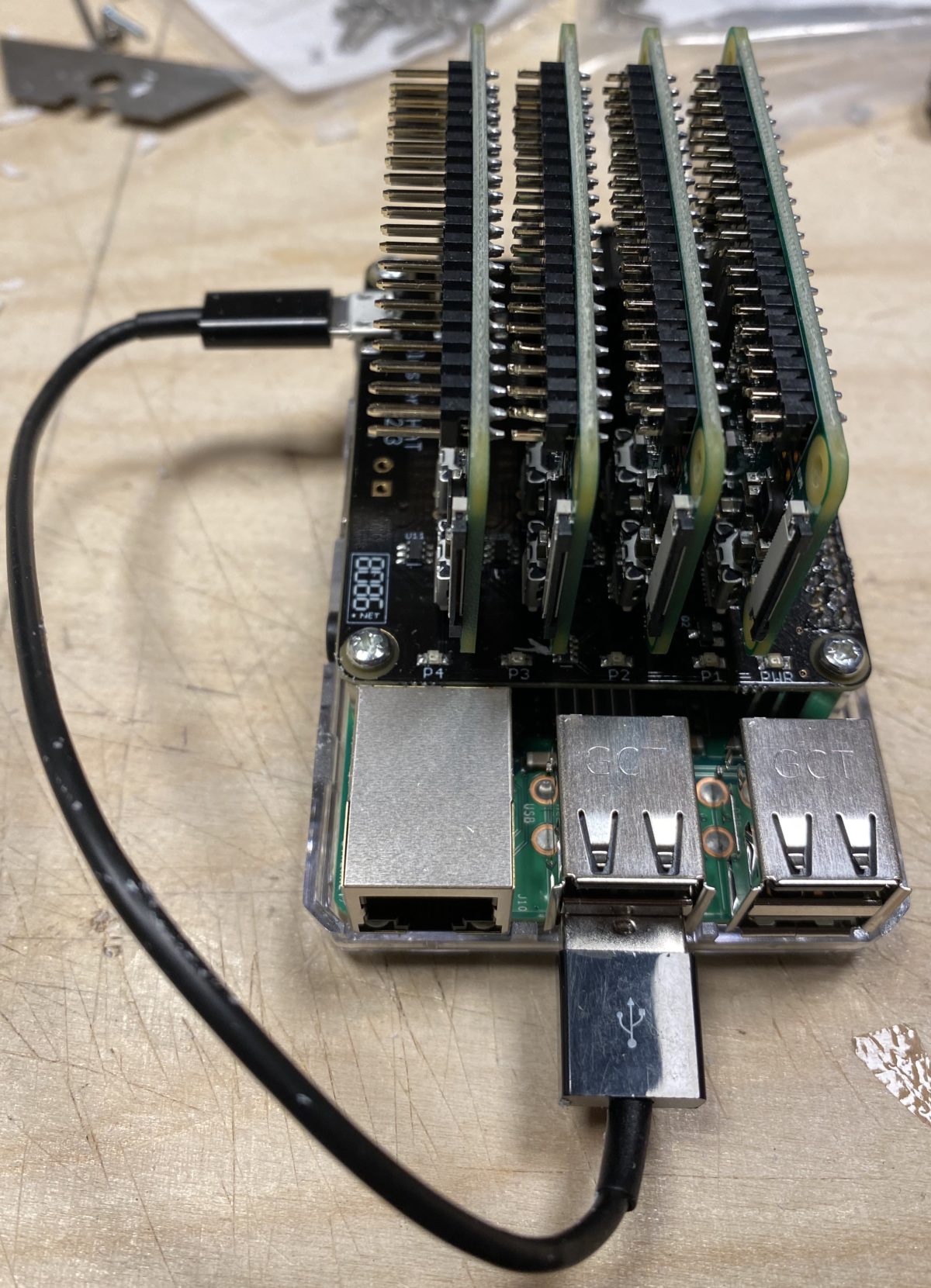

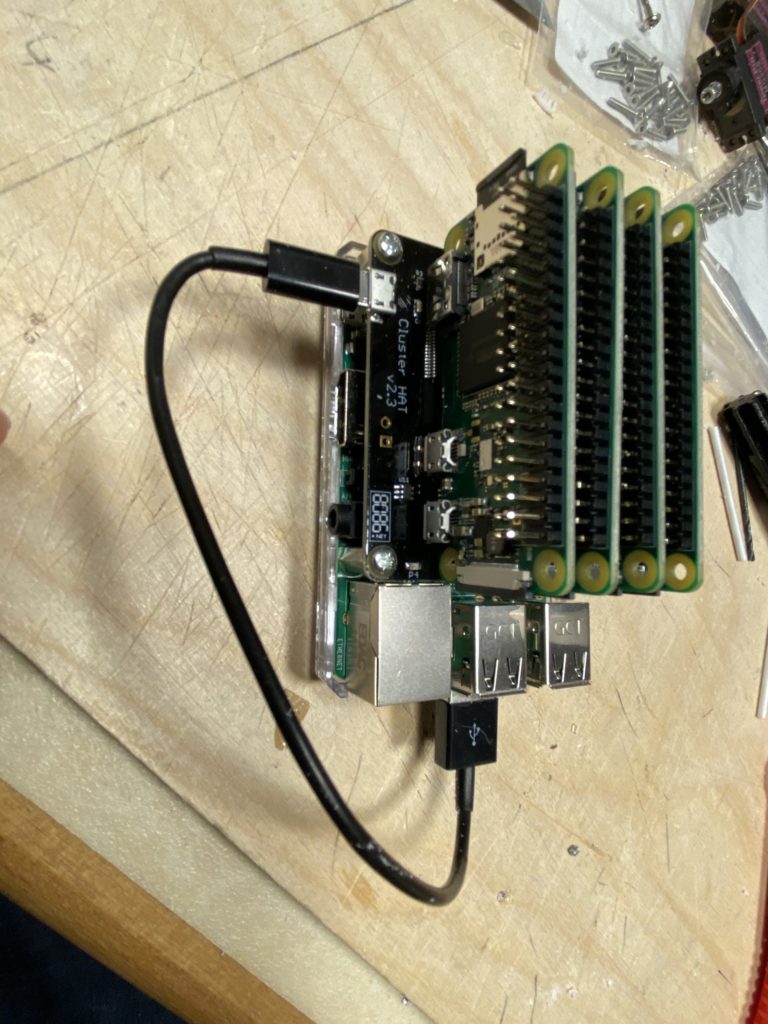

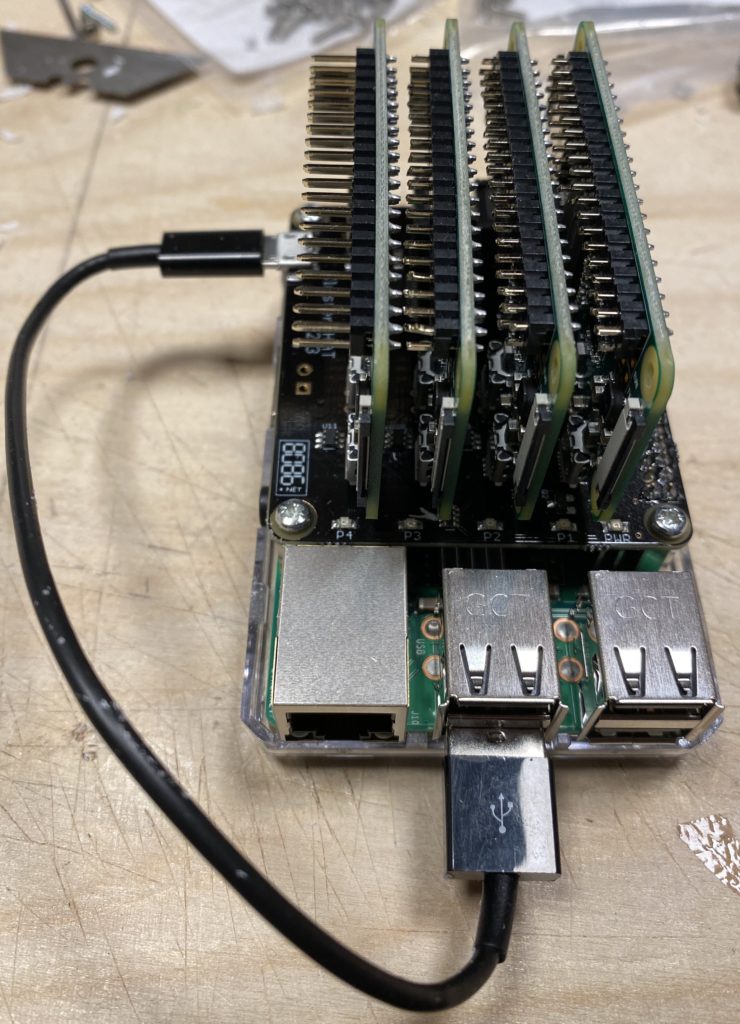

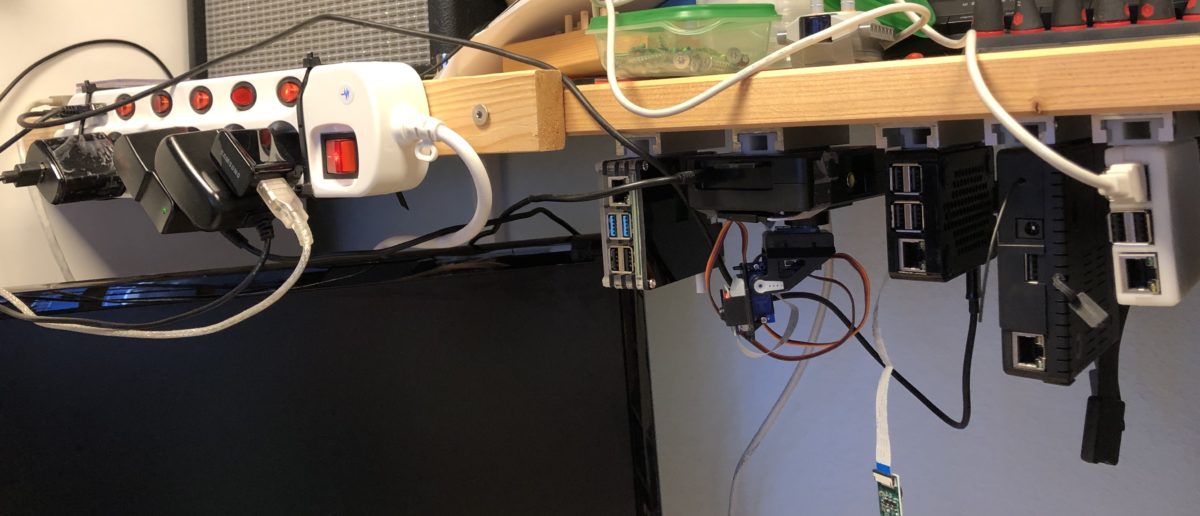

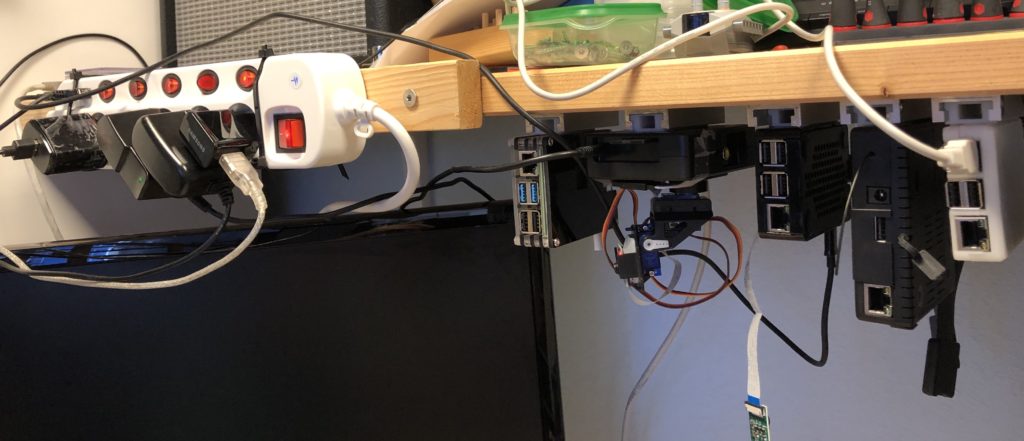

Im inneren des Kopfes werkeln 2 Raspberry Pi zero + USB to Ethernet adapter + 5-Fach Switch. Auf den RpI’s läuft motion um die Augenkameras als Stream zur Verfügung zu stellen.

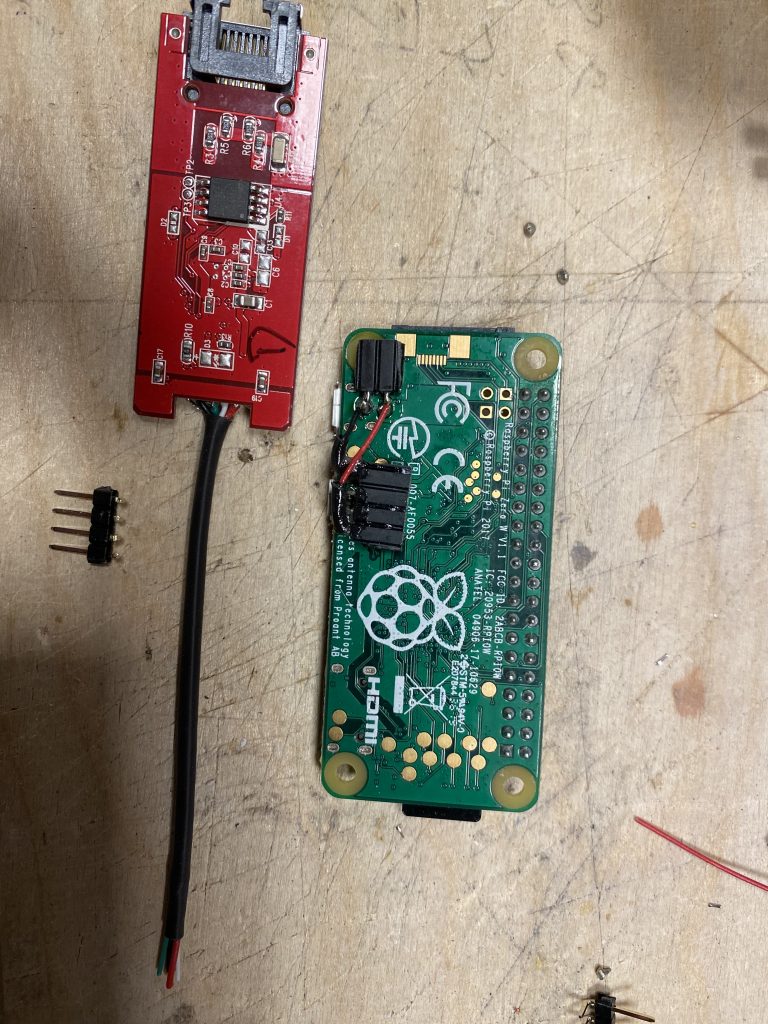

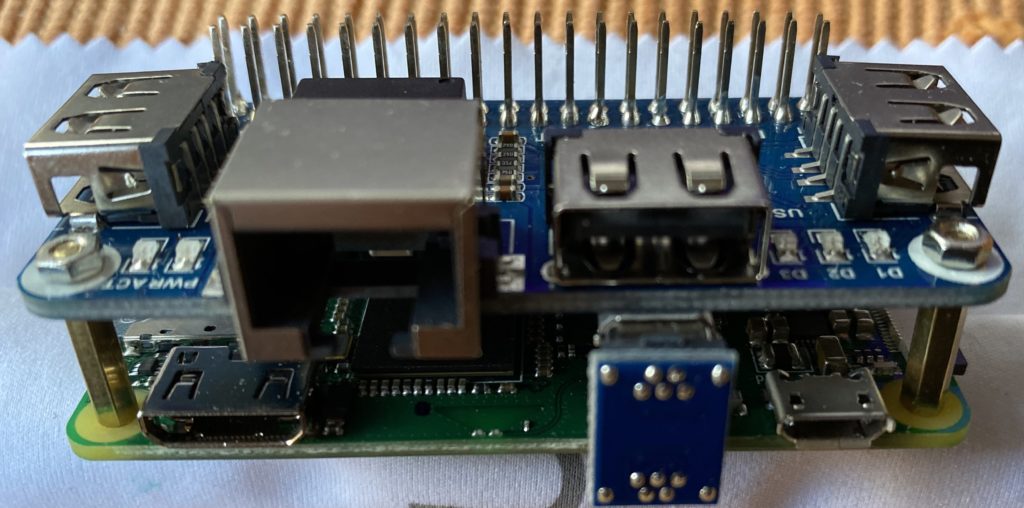

Ich habe einen USB zu Ethernet Adapter aufgesägt und die Platine auf den Raspberry Pi zero geklebt. Die USB Anschlüsse habe ich direkt auf die Platine gelötet, da die Stecker an der Seite zuviel Platz wegnehmen.

Auf dem Raspberry pi zero läuft Buster mit motion für die Camera

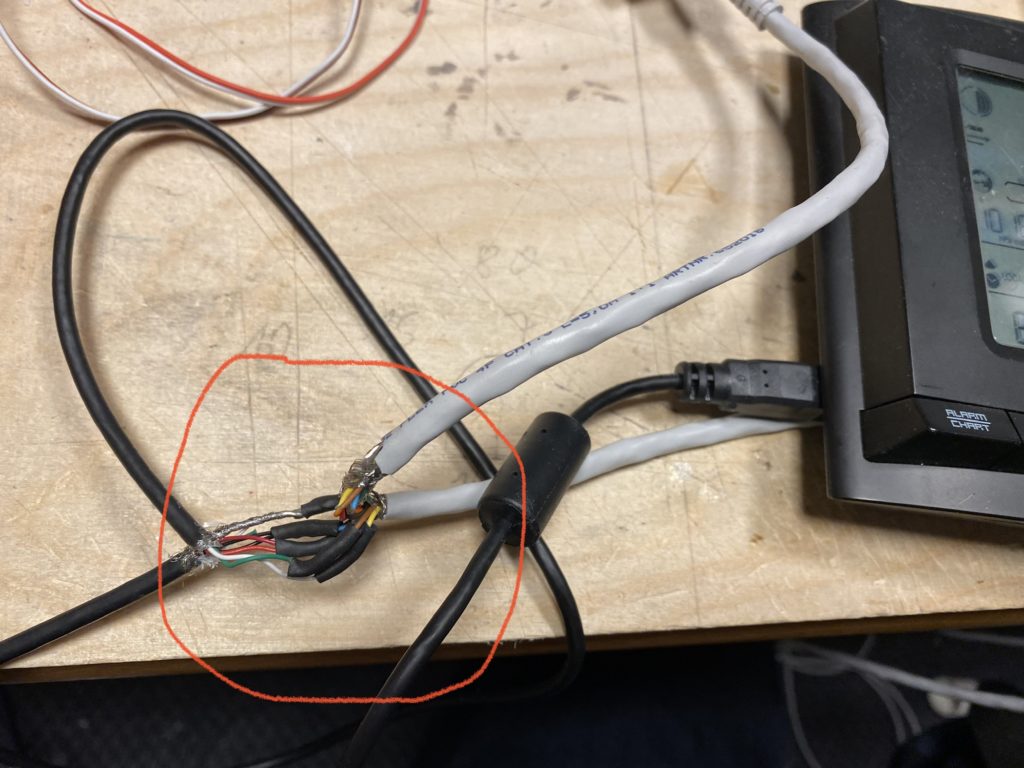

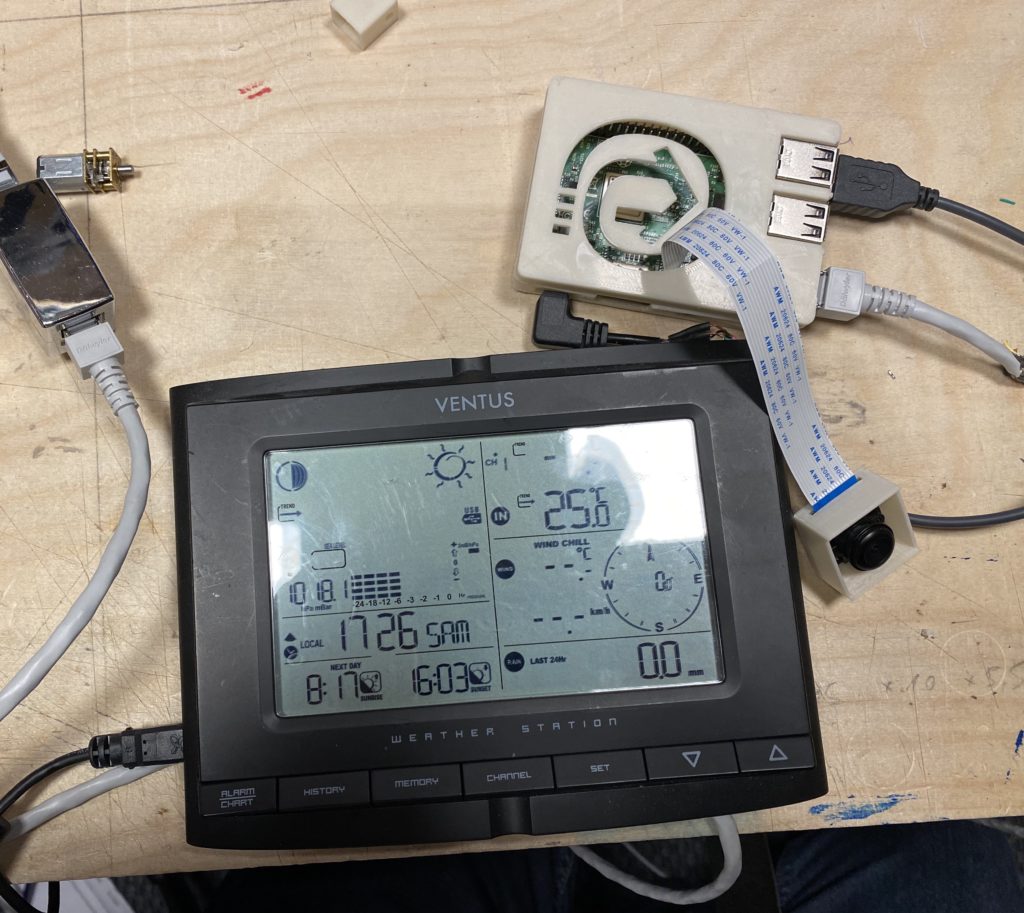

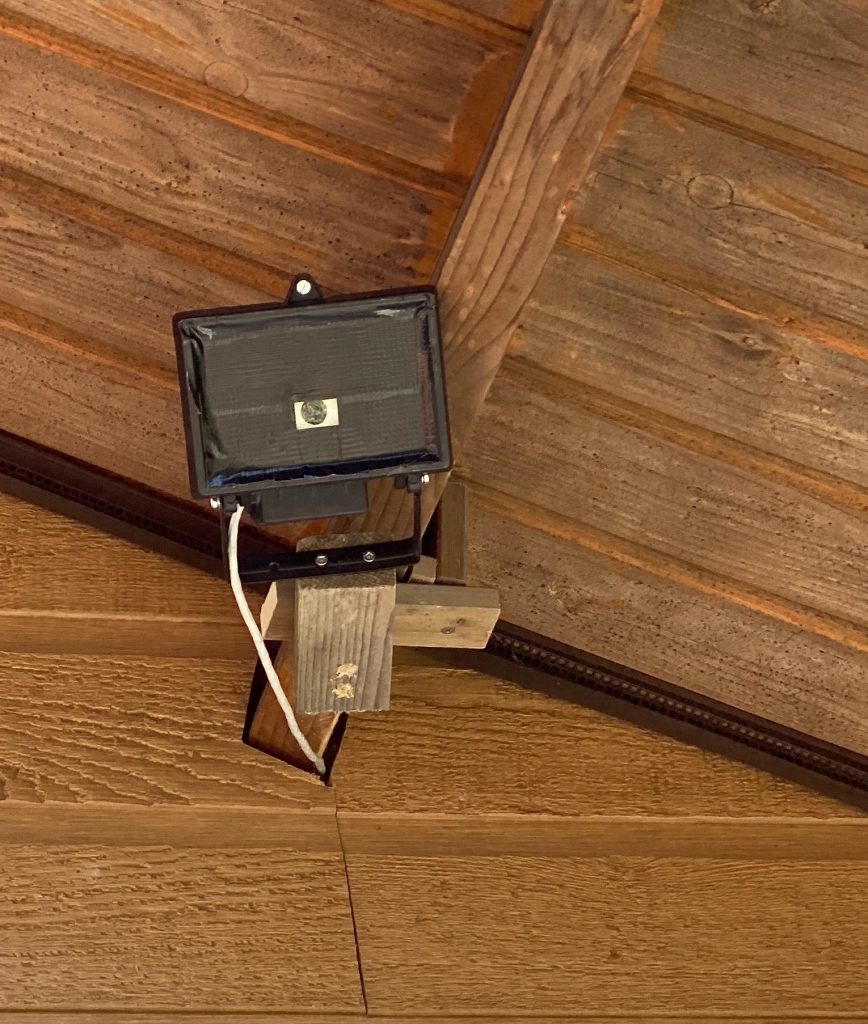

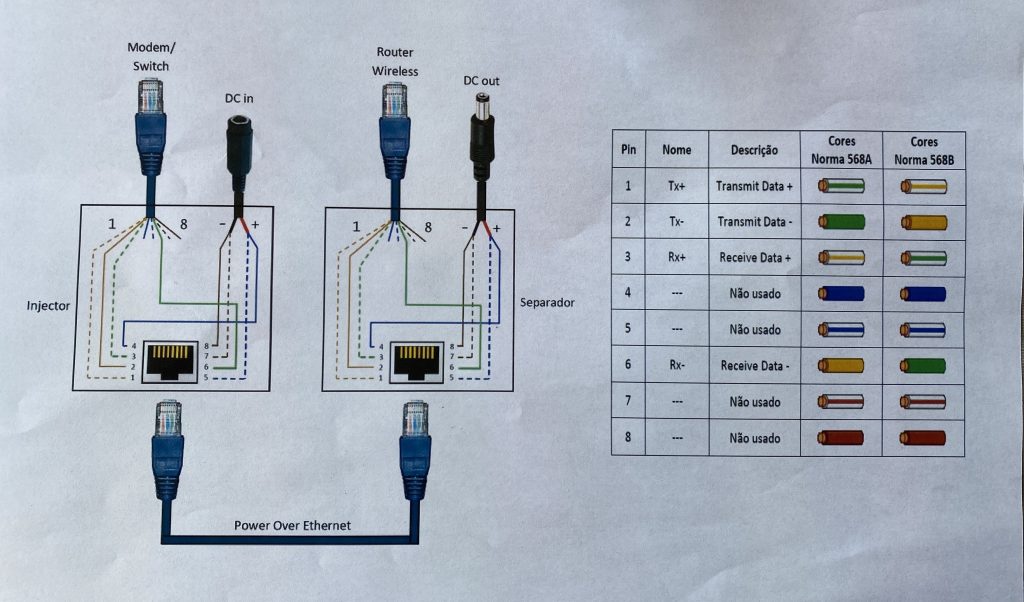

Hier soll im Garten unter dem Laubendach der Raspberry Pi 3 in einem entkernten IP65 Halogenstrahler-Gehäuse mit seiner Webcam und dem Anschluss an eine Ventus Wetterstation zyklisch die Wetterdaten auf eine mit Weewx erzeugte Webseite hochladen. Bei dem letzten Bild sieht man das die Stecker mit der Zange solange bearbeitet worden sind, bis dann der Pi in das Gehäuse gepasst hat.

2 Adern sind mit dem USB der Wetterstation verbunden weitere 2 Adern versorgen den Raspberry PI mit 5V. Das wird über ein Netzteil eingespeist.

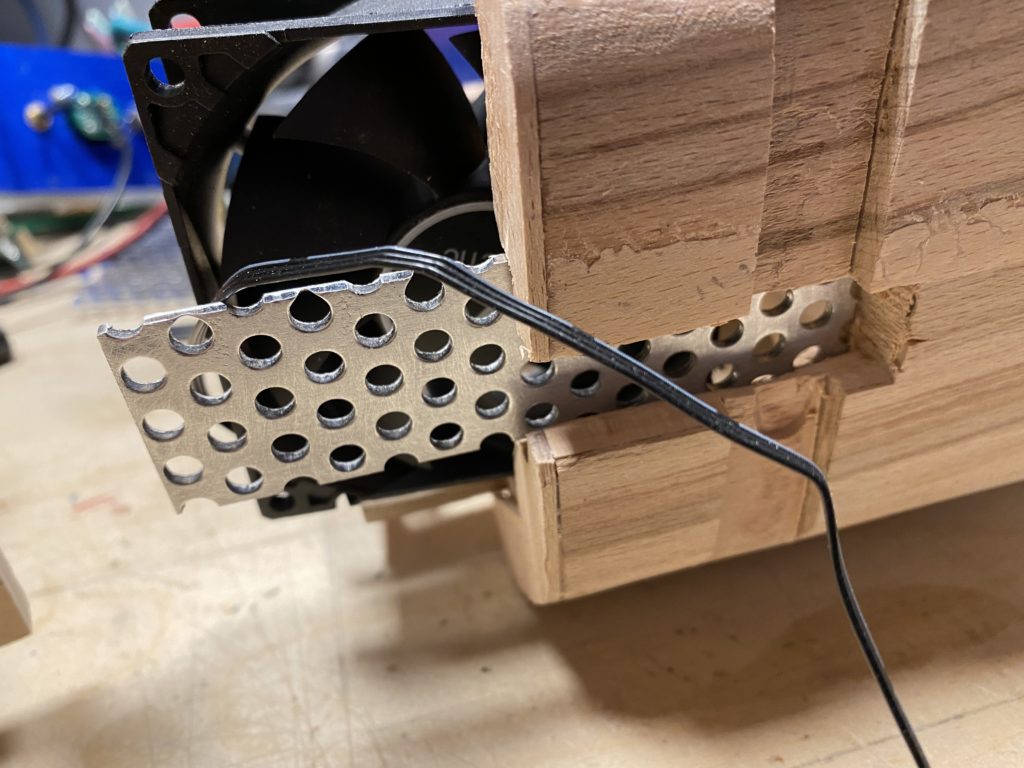

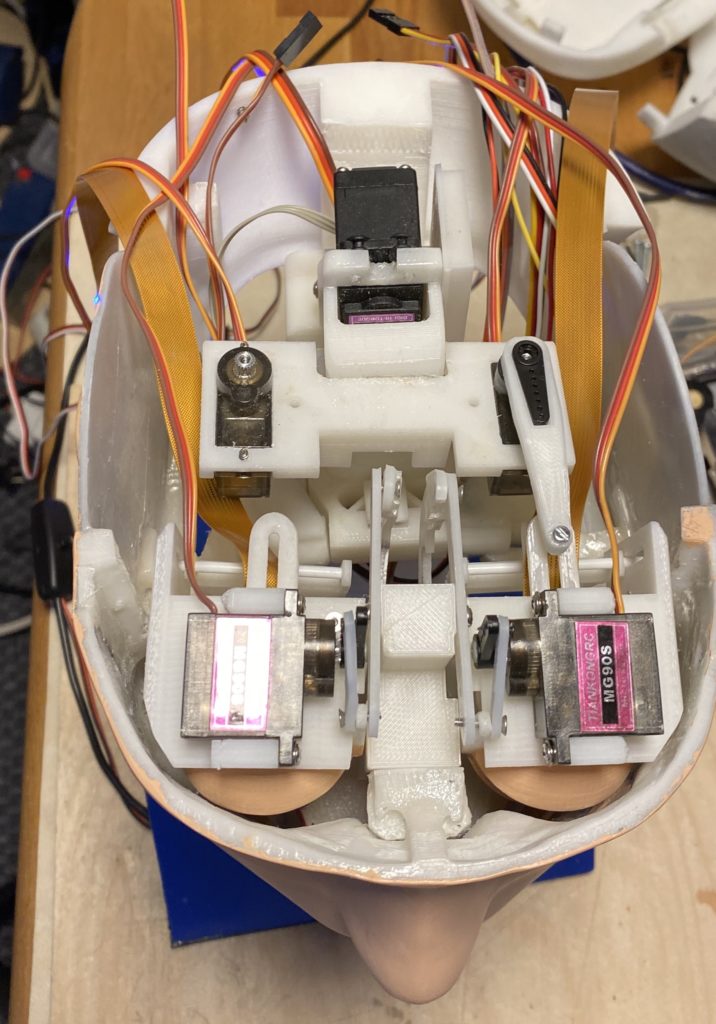

Im Innenleben ein 8-Fach Relayboard mit einem Raspberry Pi 3 als Ansteuerung

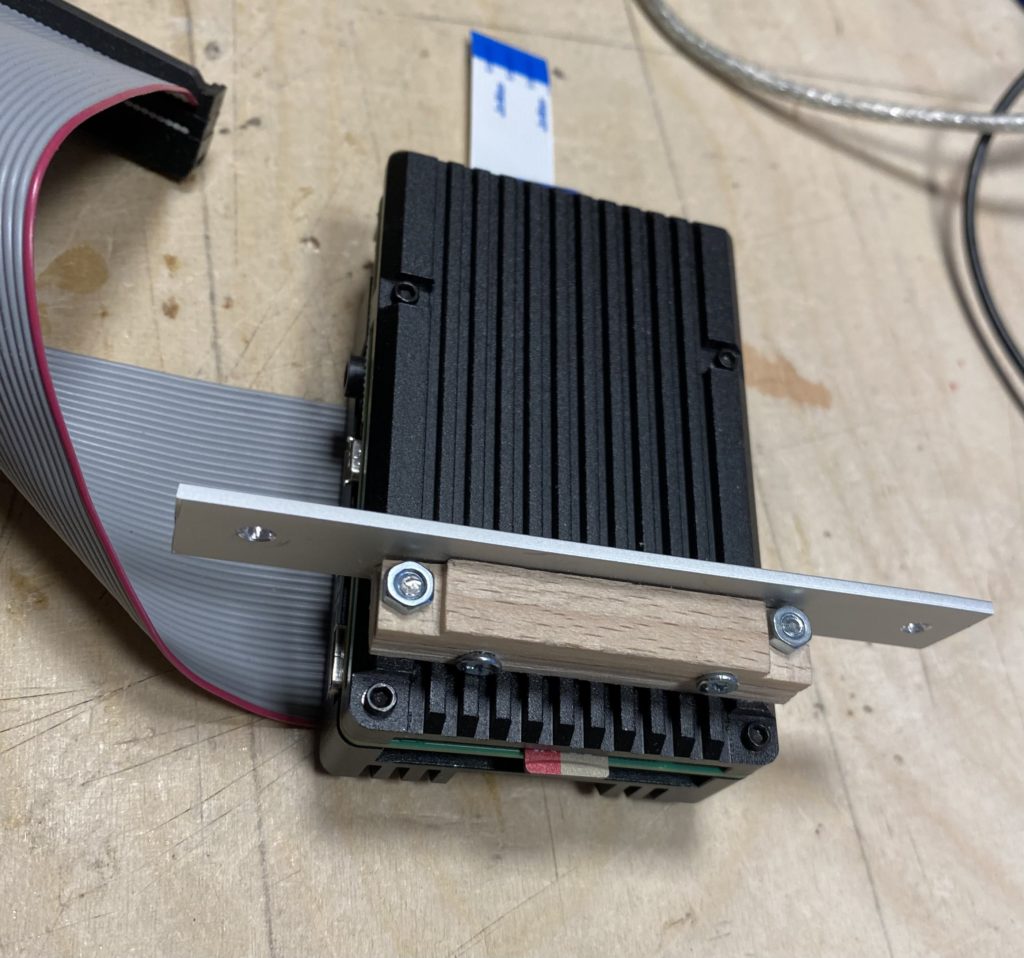

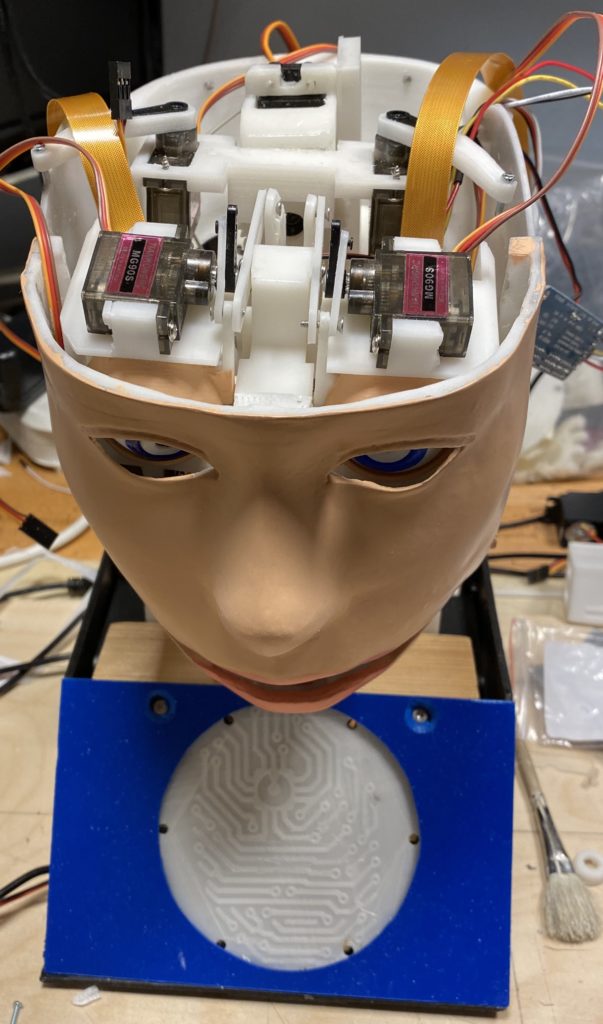

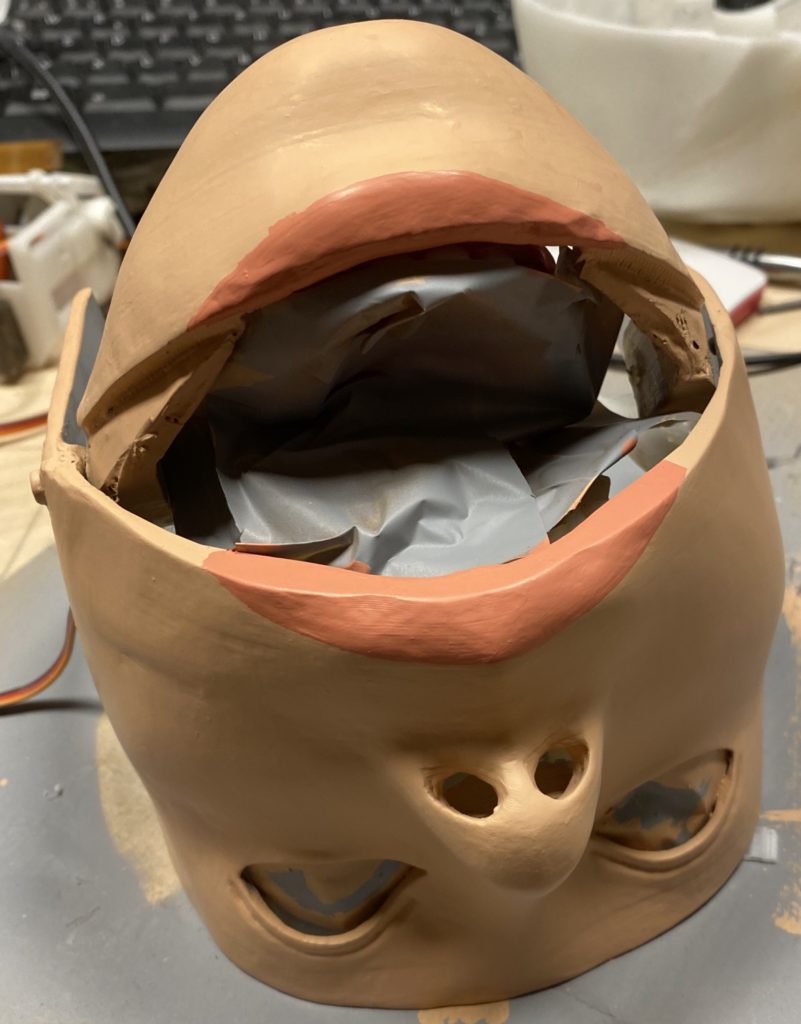

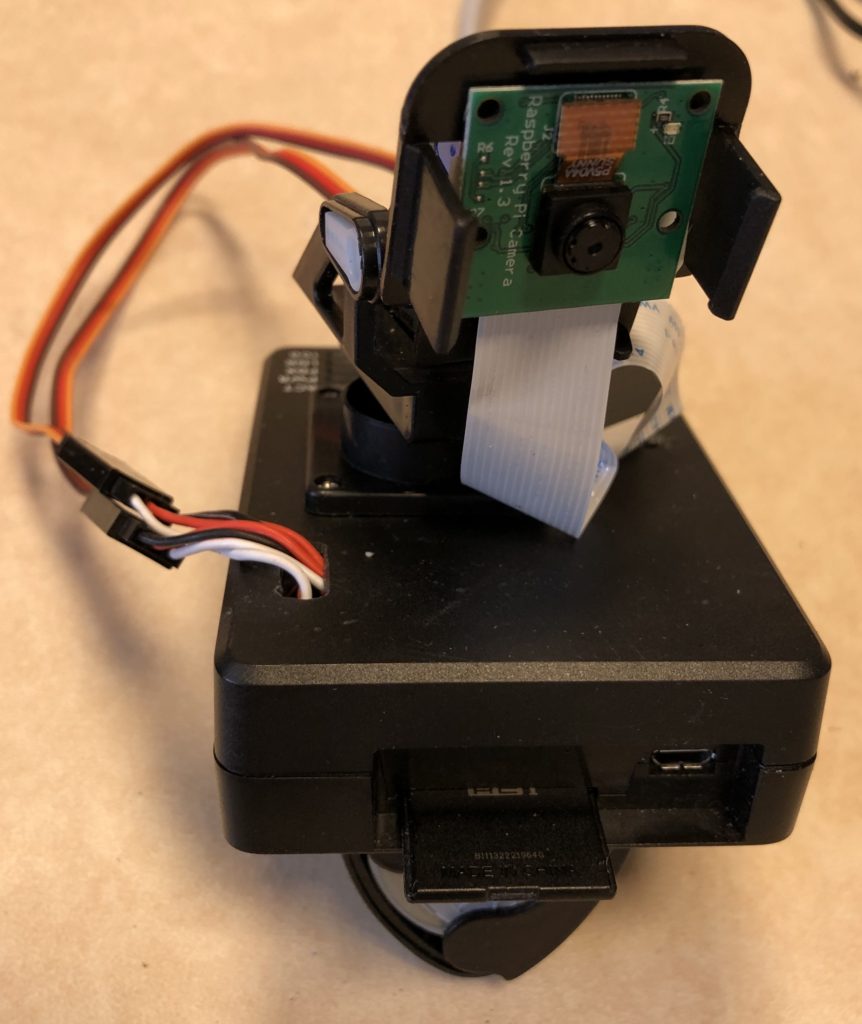

Auf dem rechten Bild sieht man die Flachbandkabel der Raspberry Pi Cam’s herausschauen

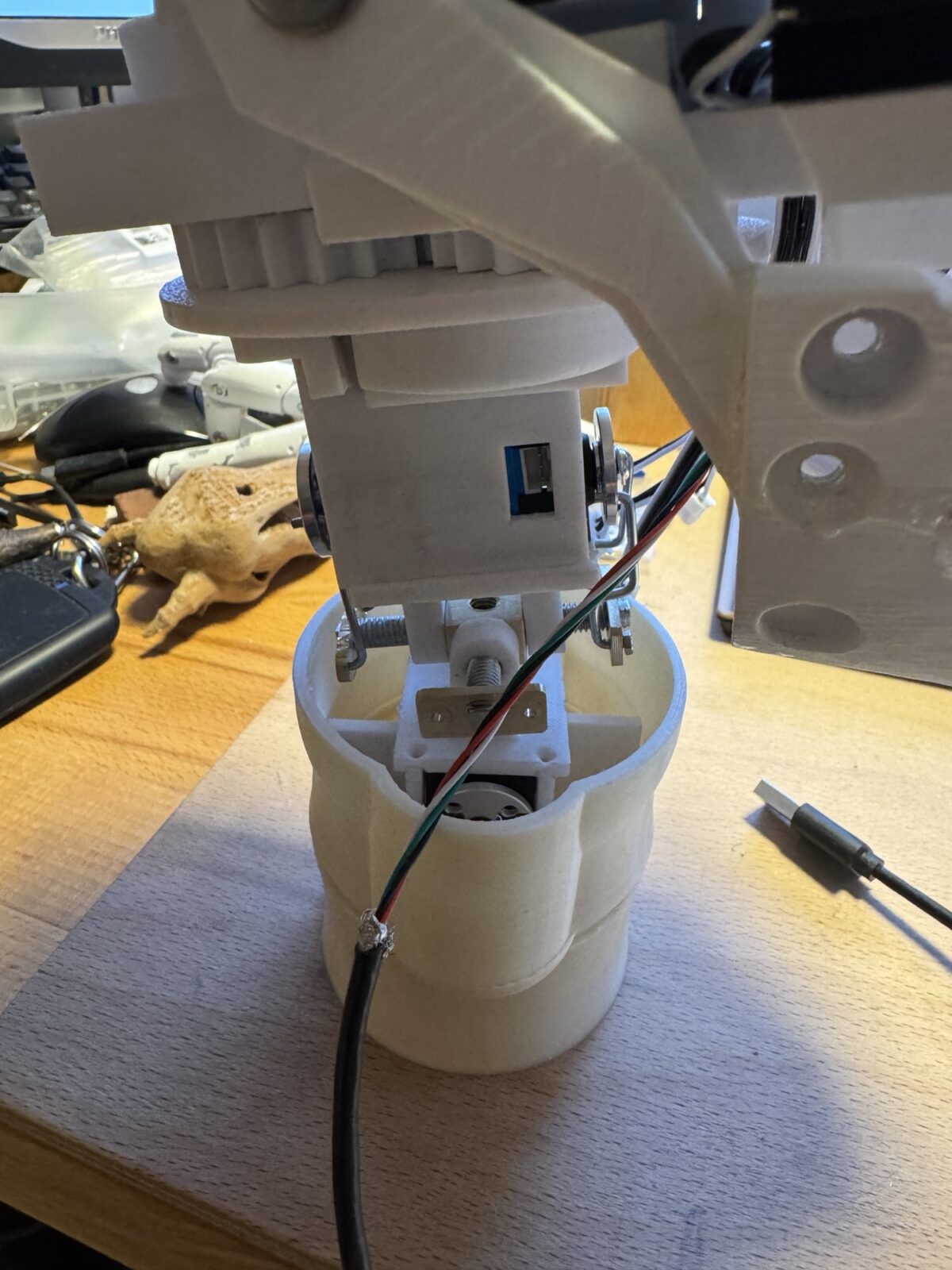

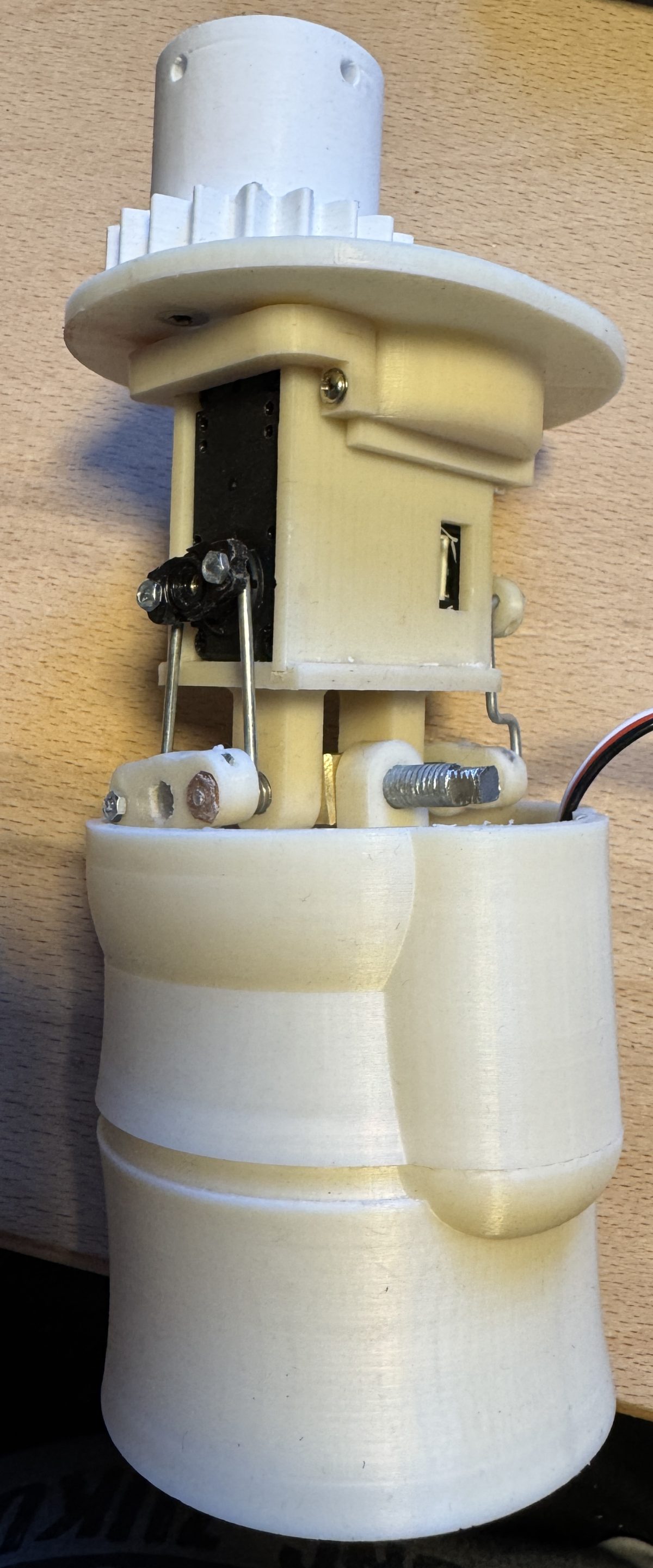

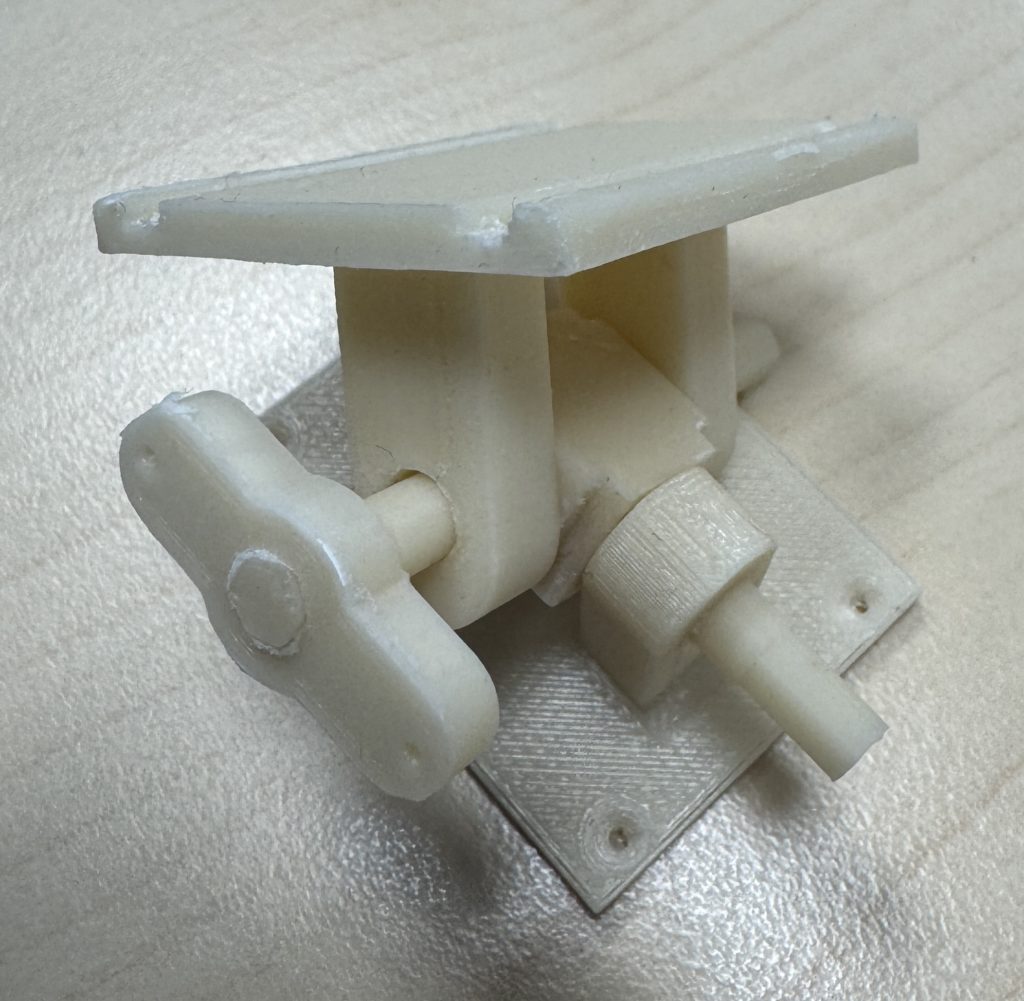

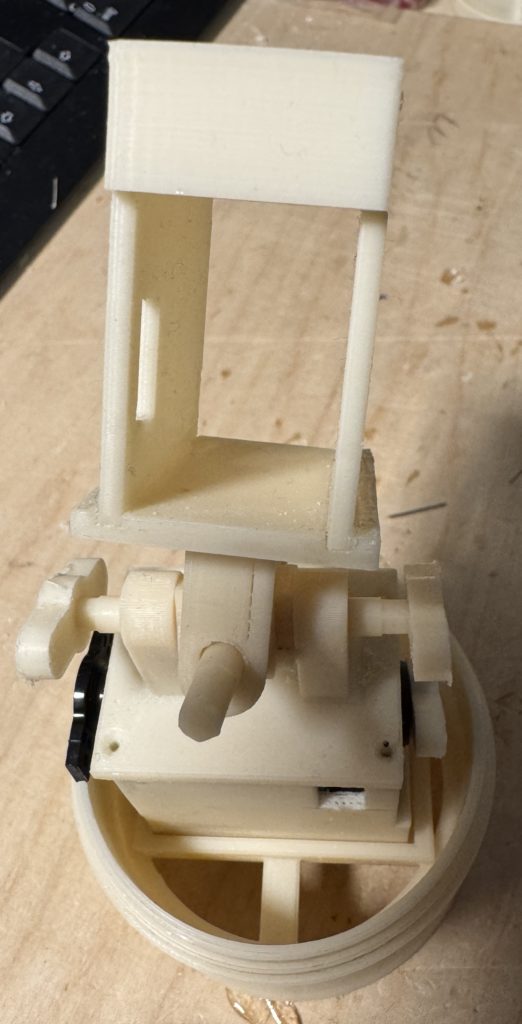

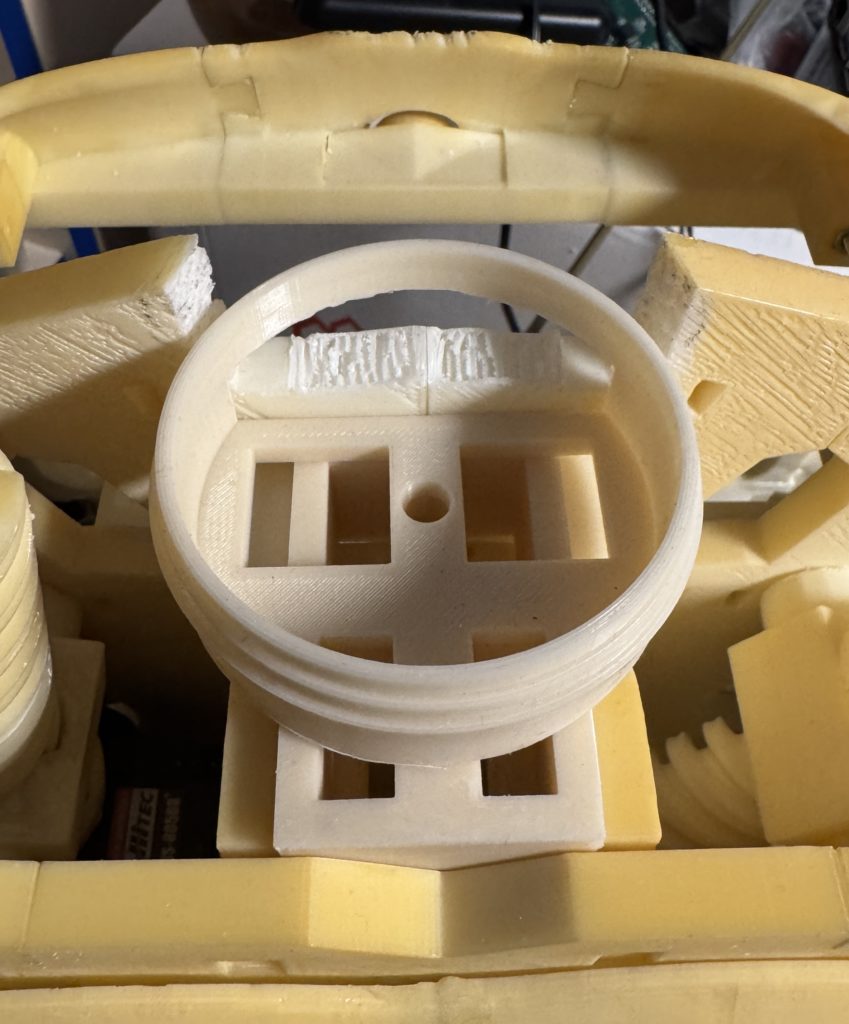

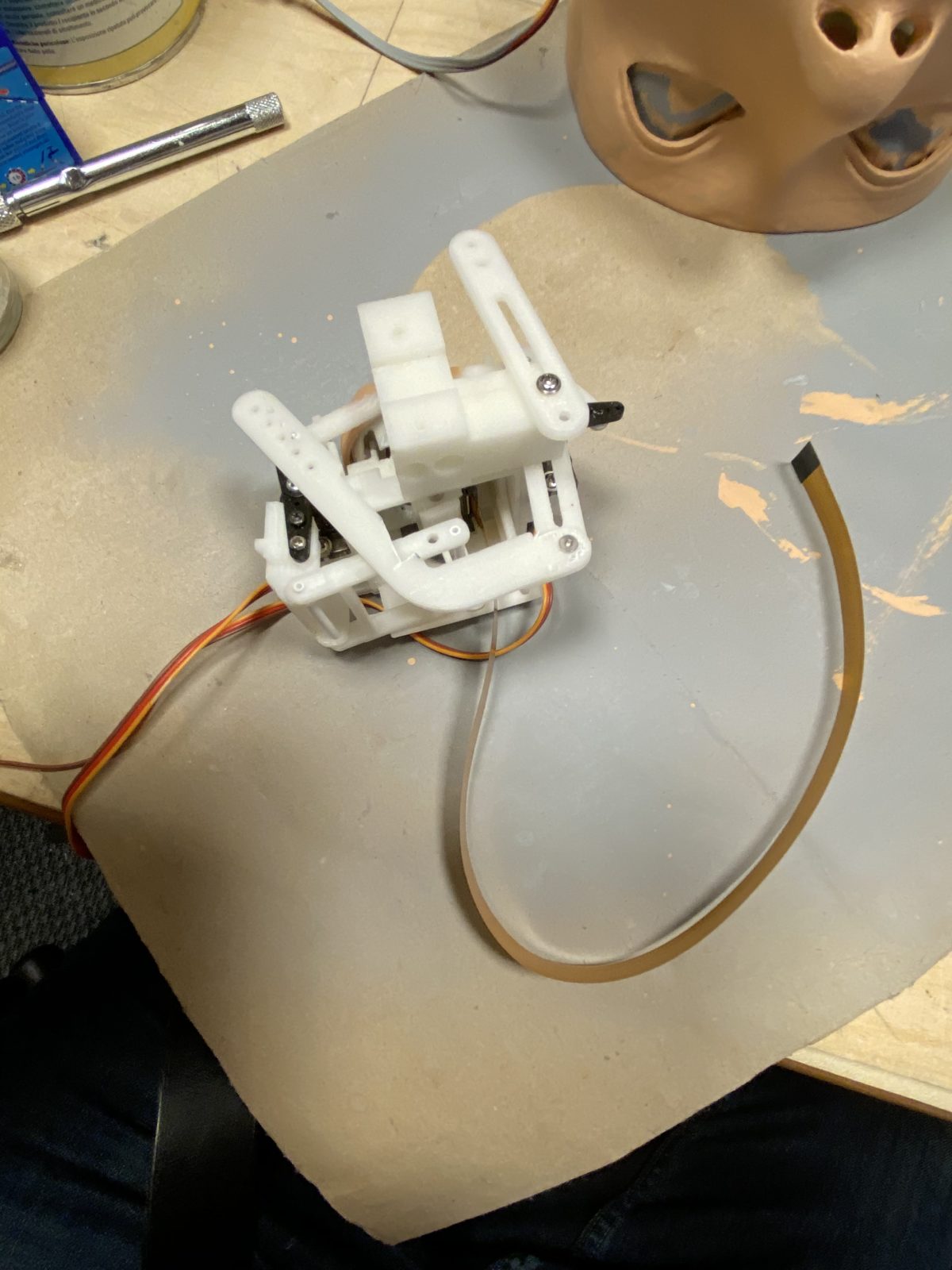

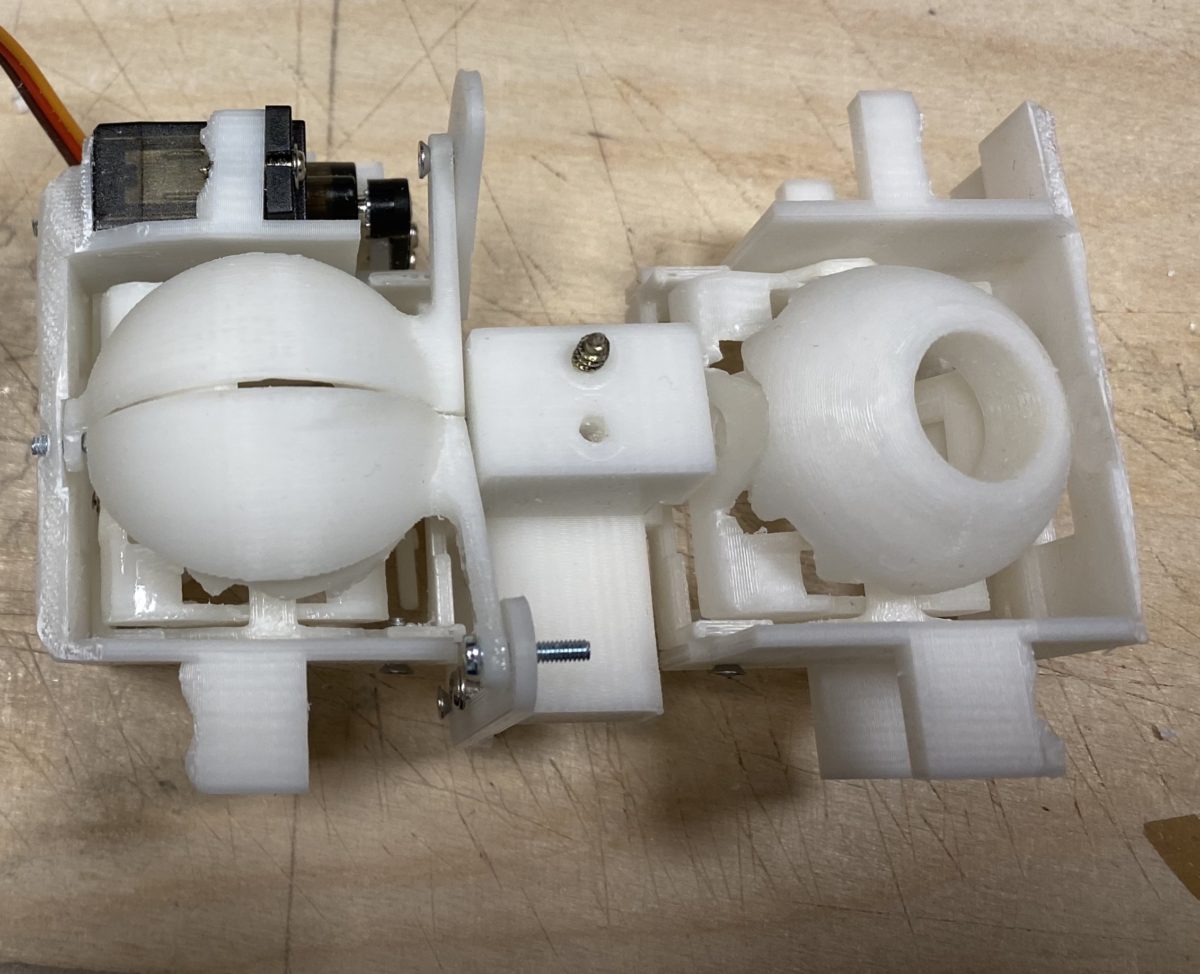

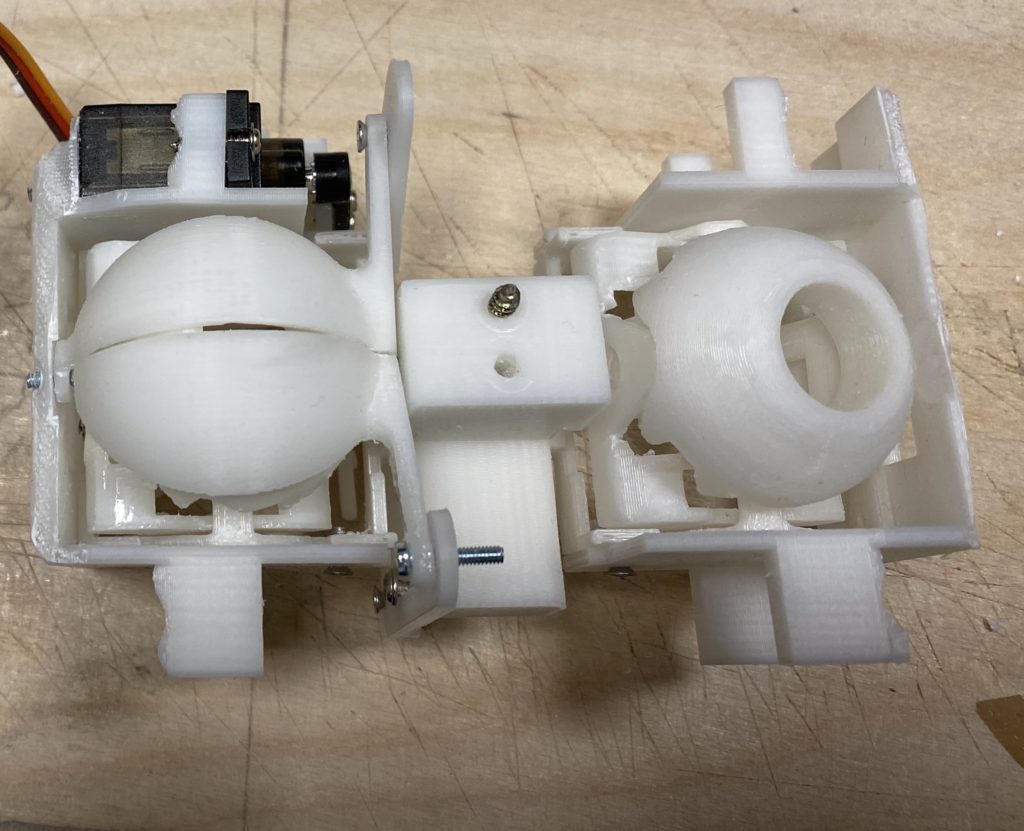

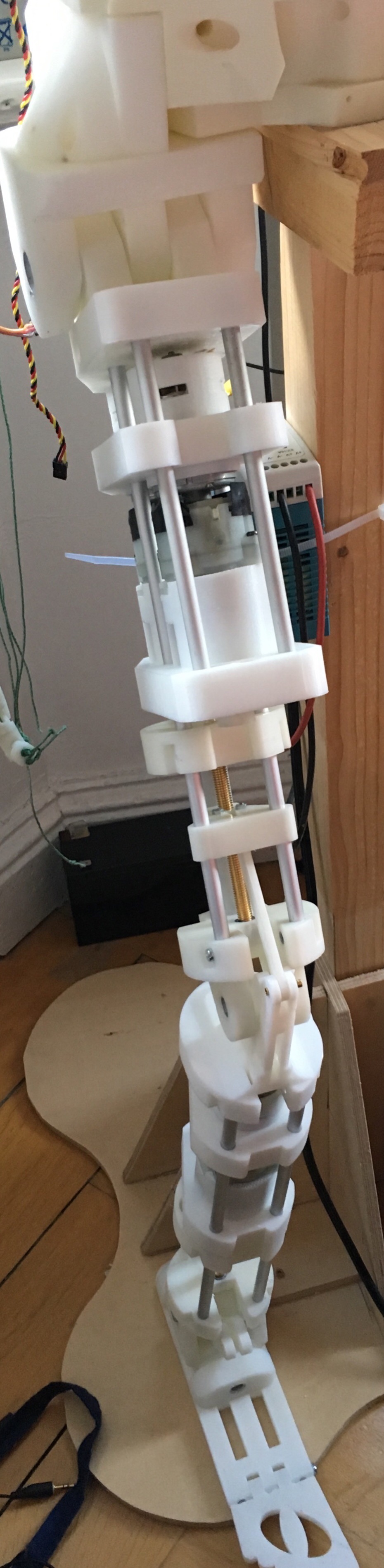

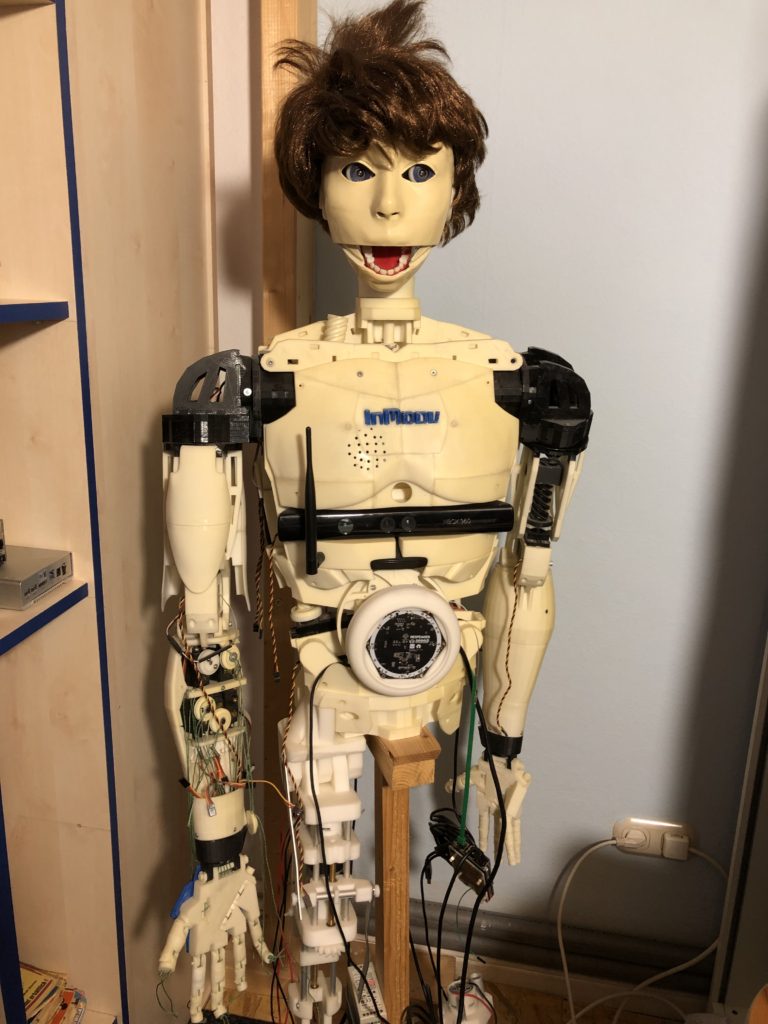

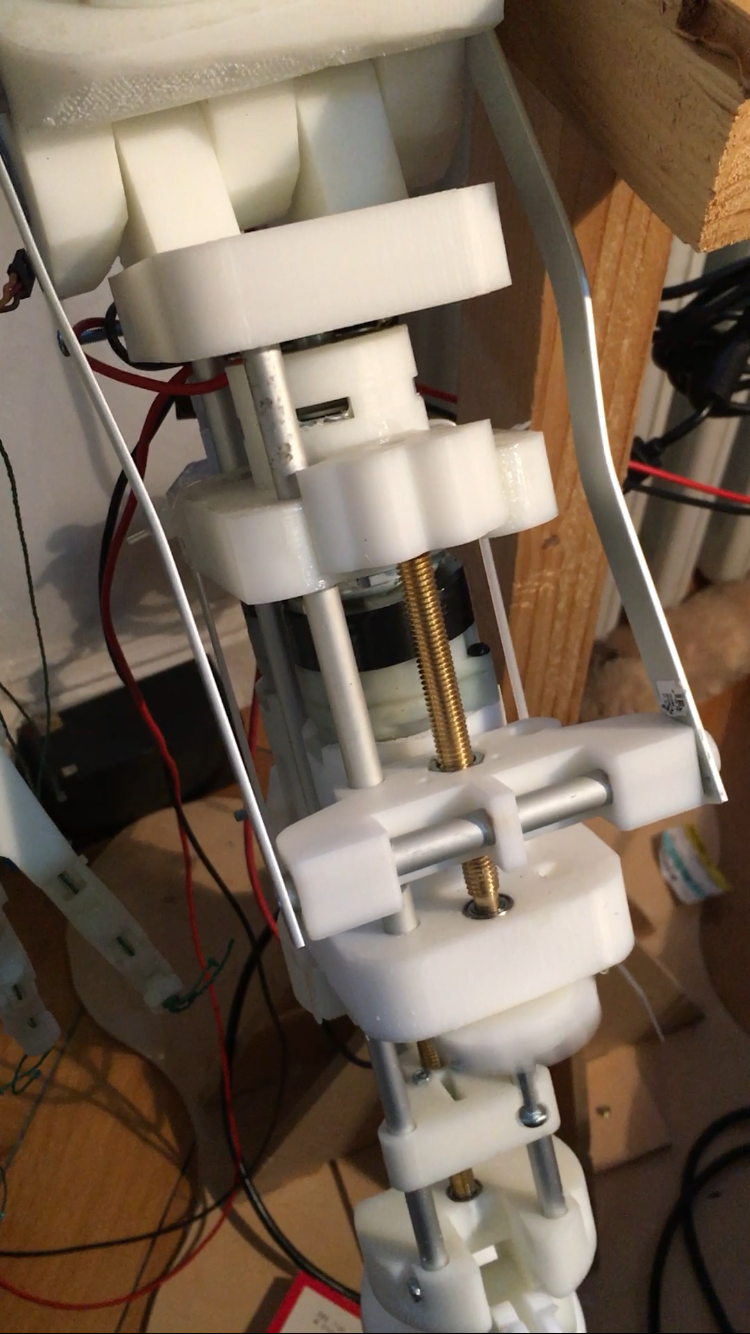

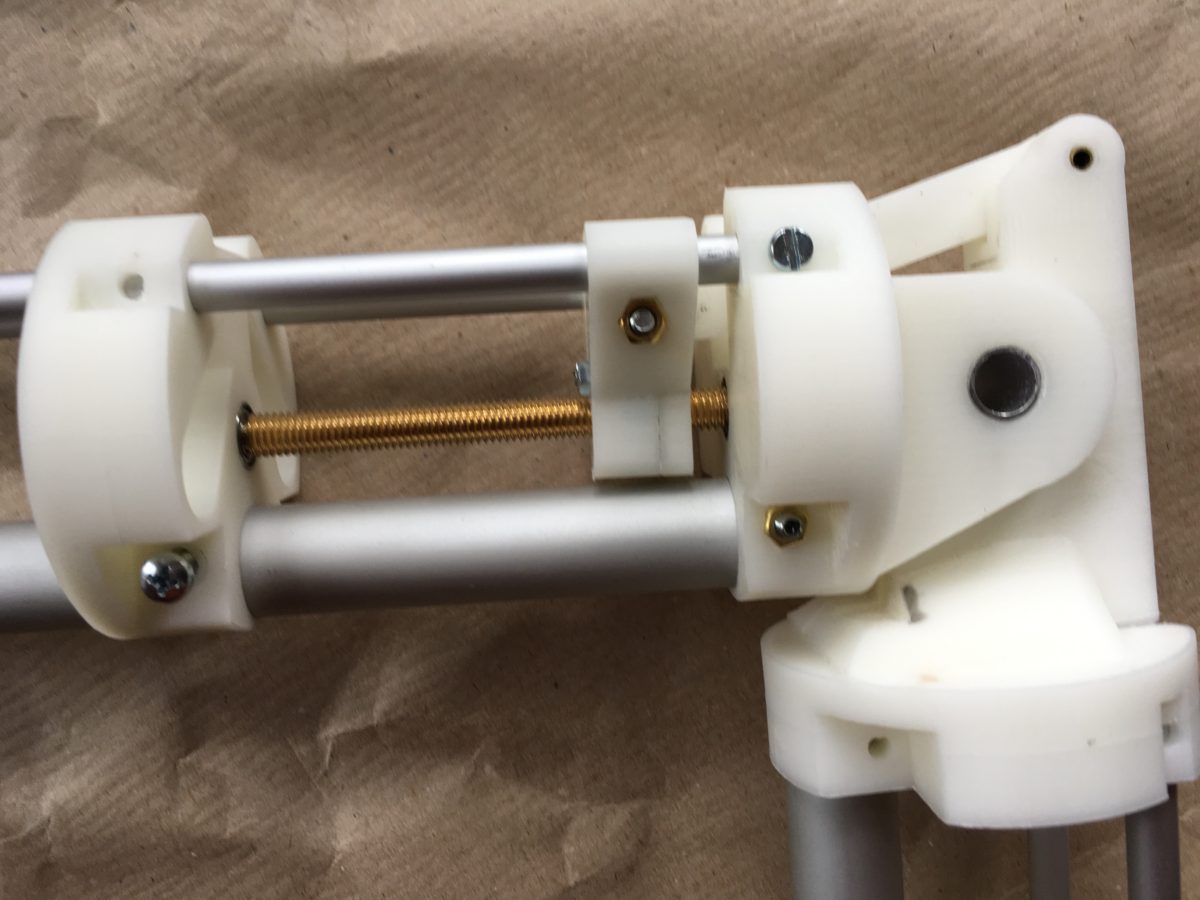

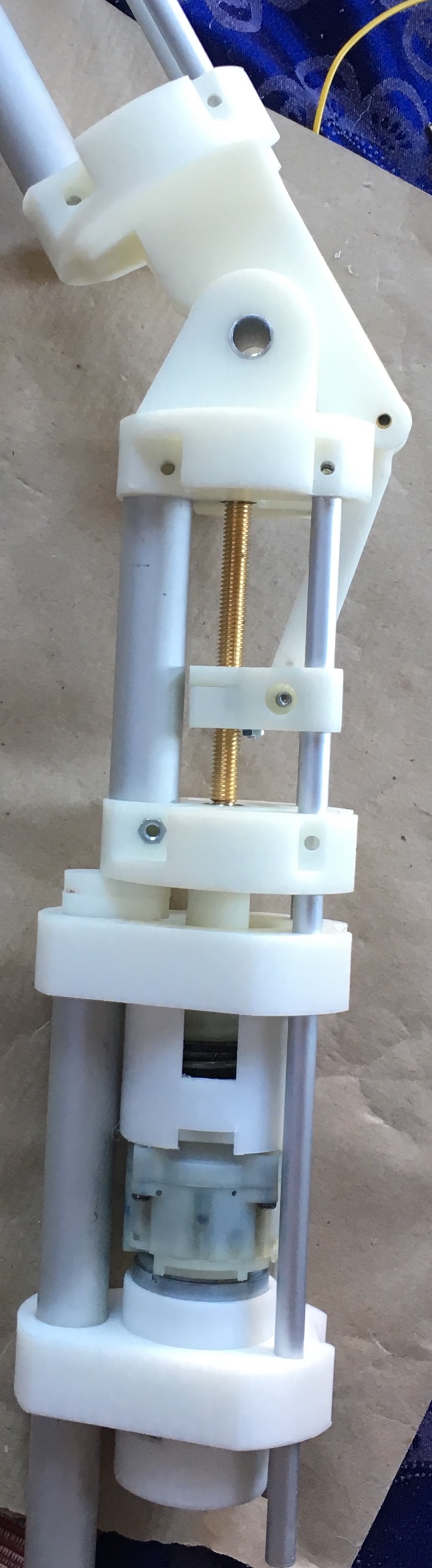

Ja demnächst nach dem die Teile in der Drehbank angepasst sind mehr

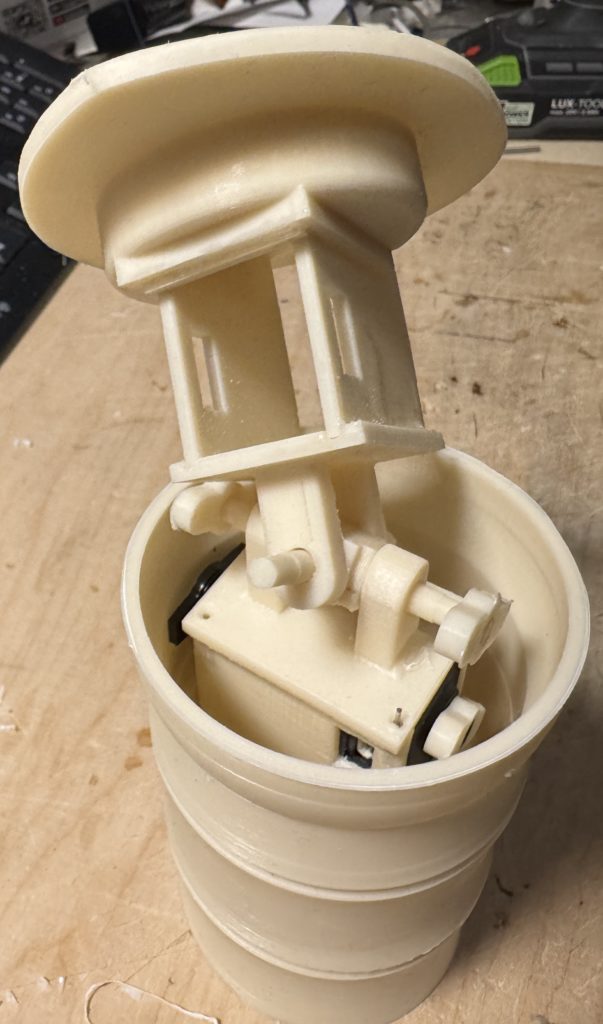

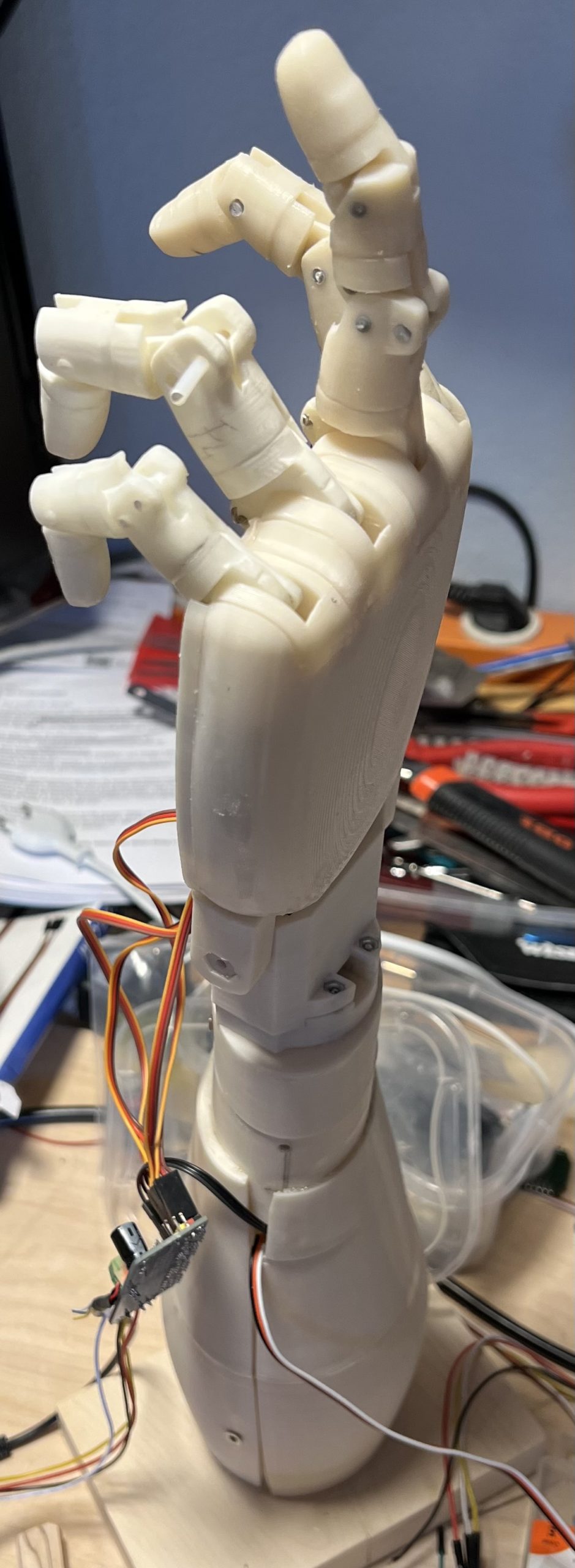

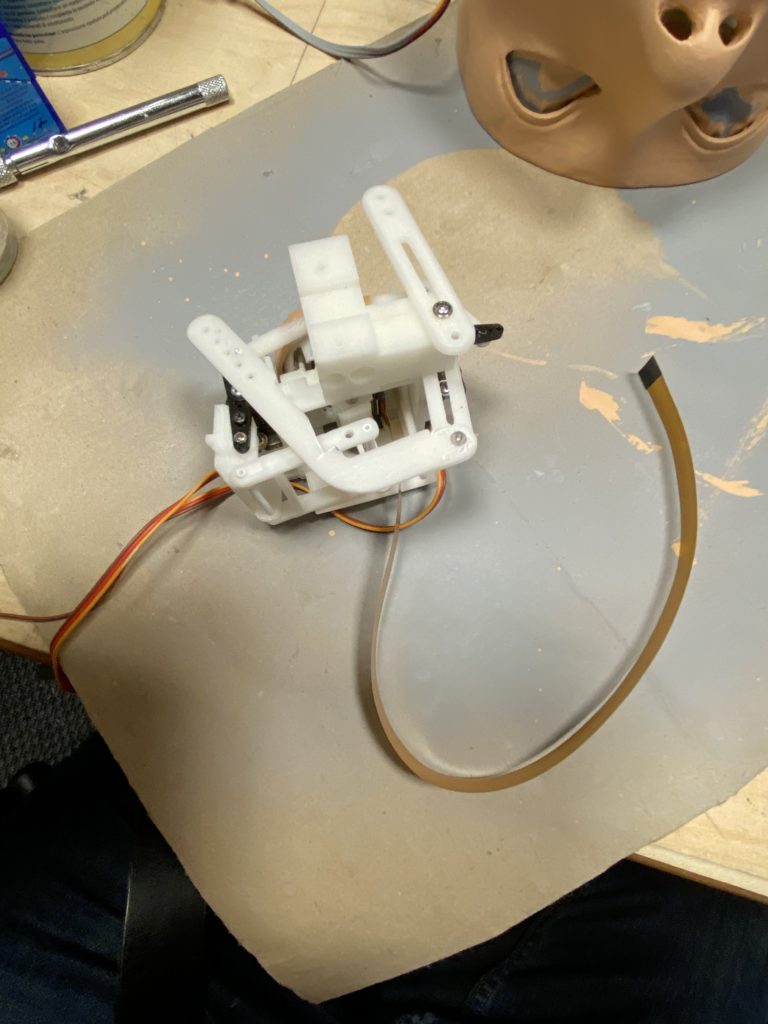

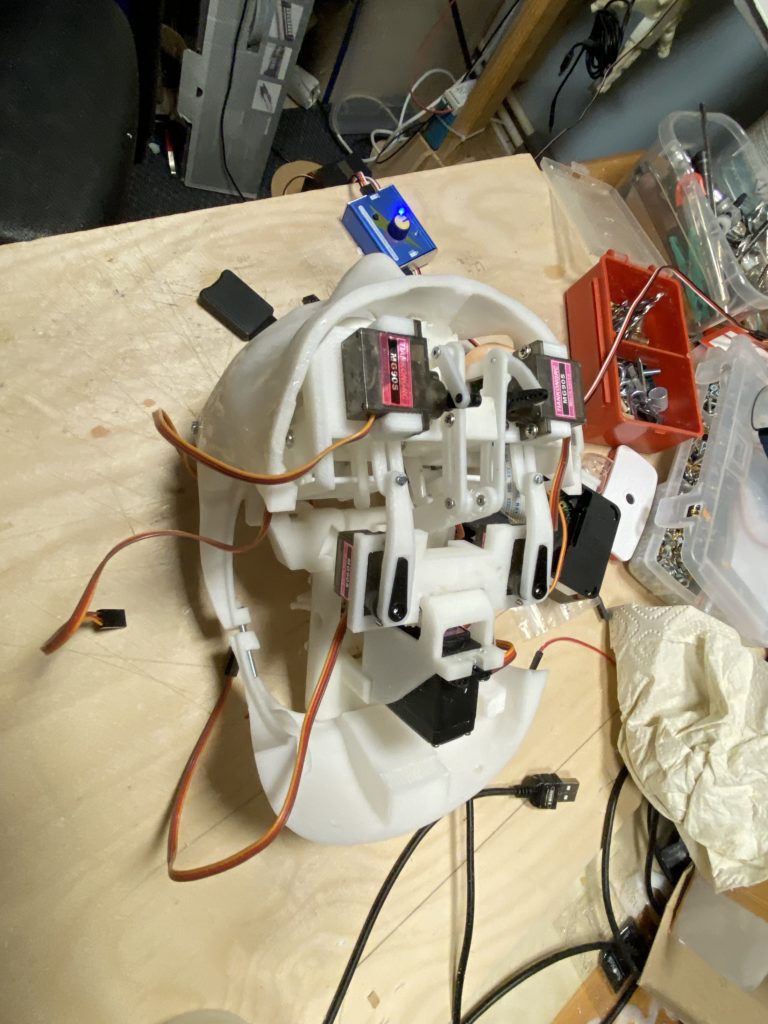

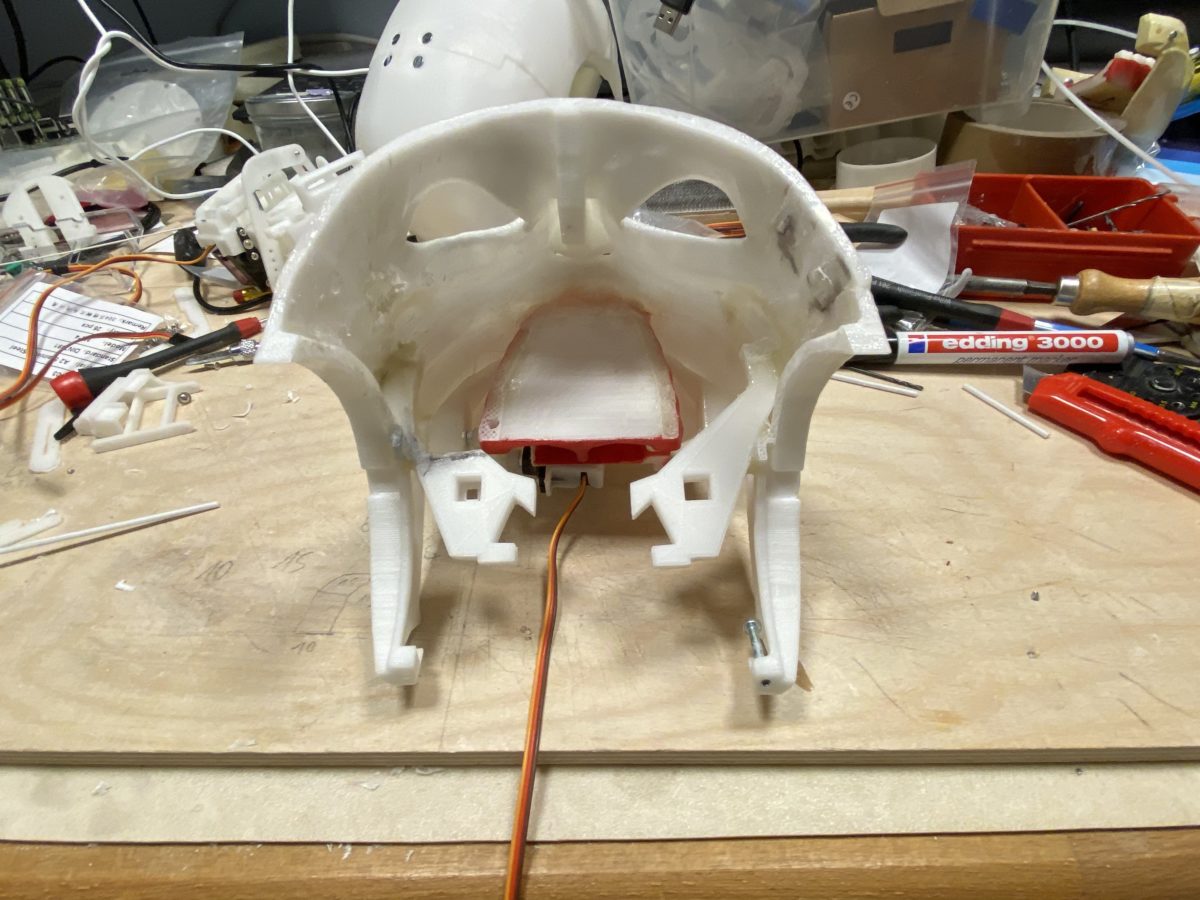

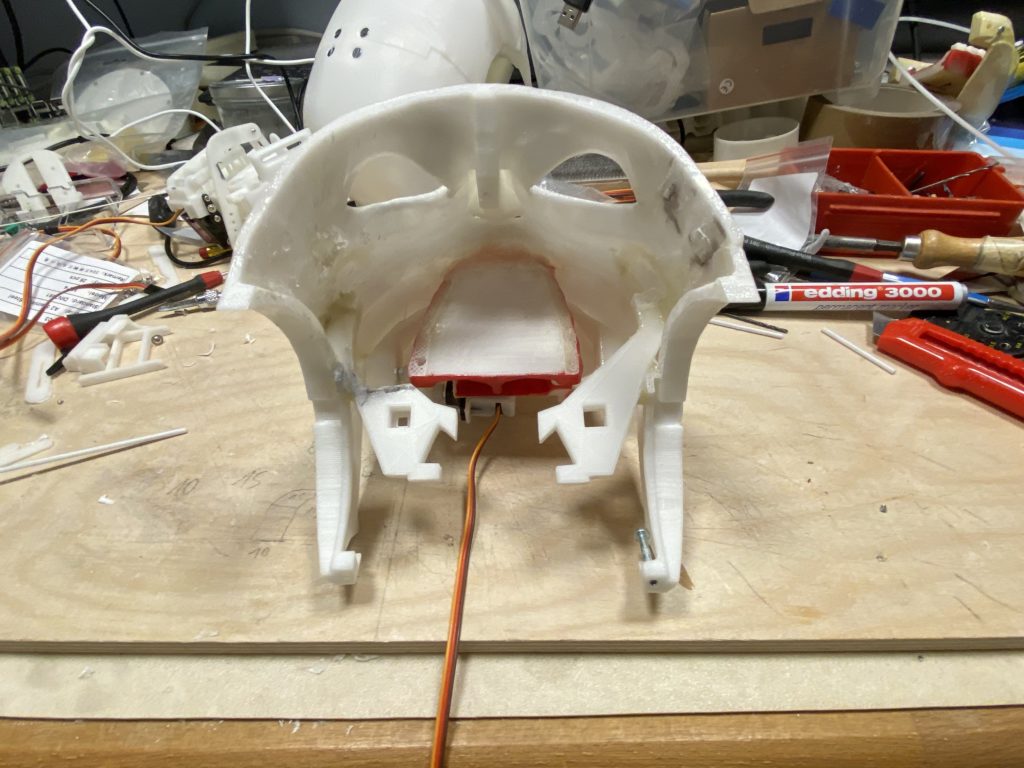

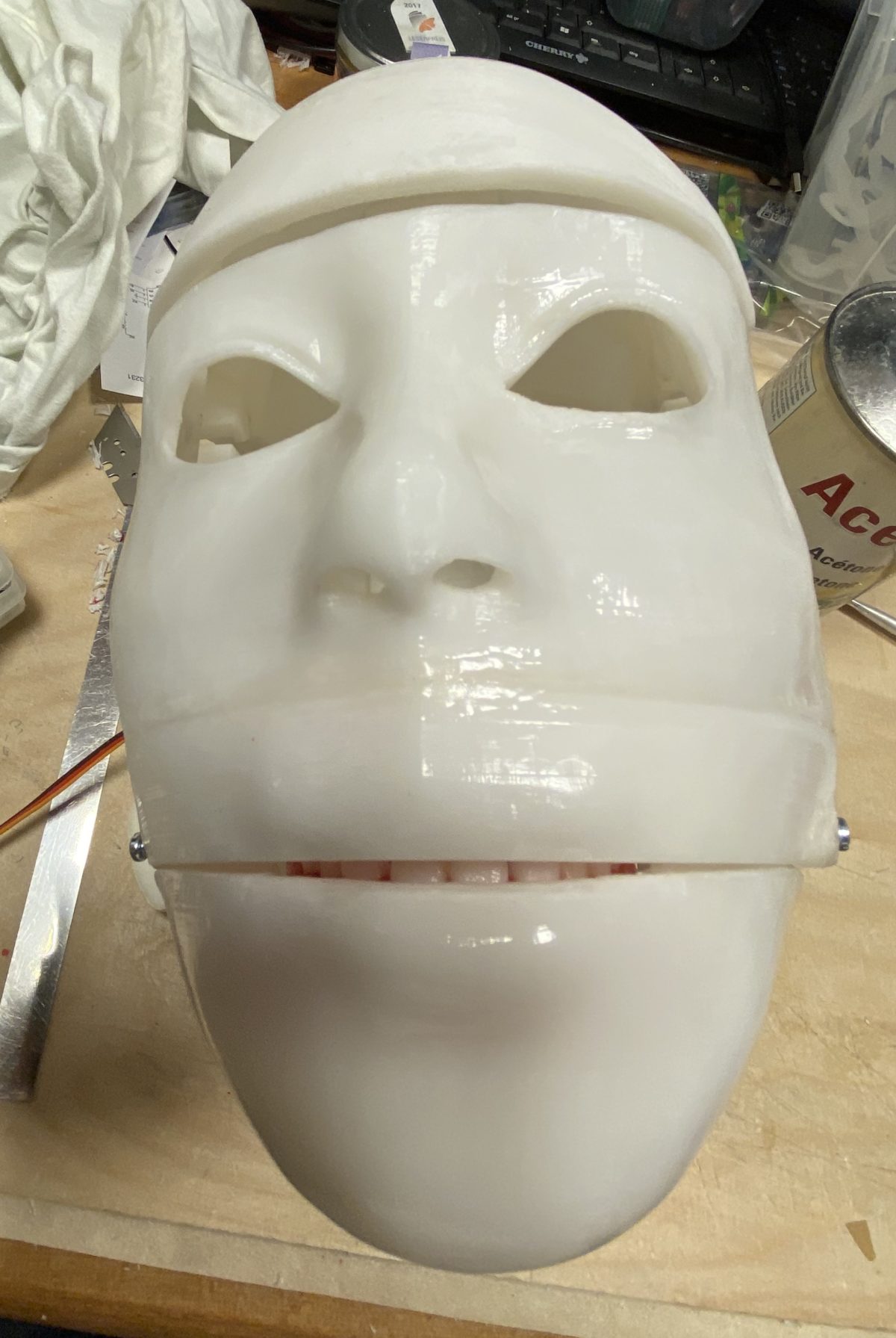

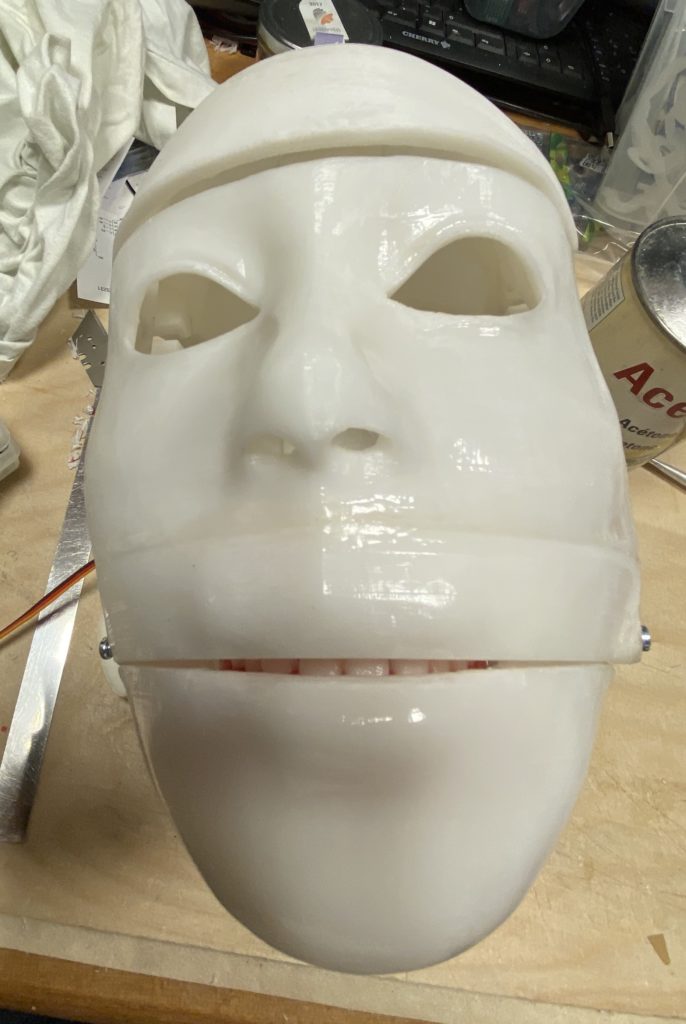

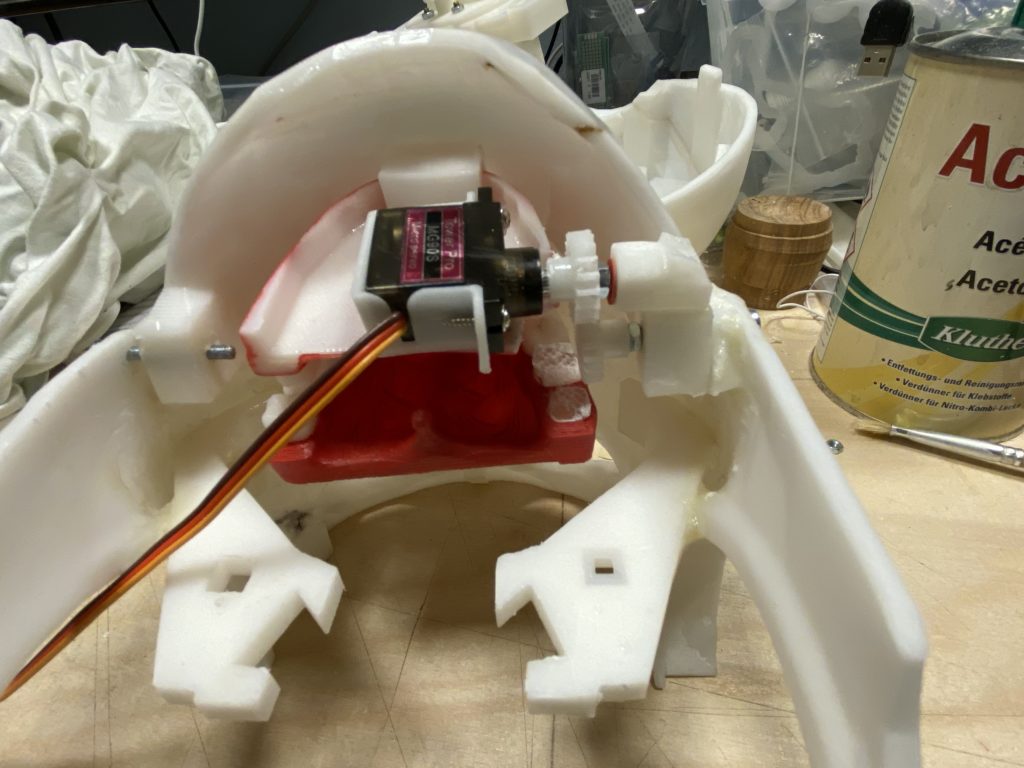

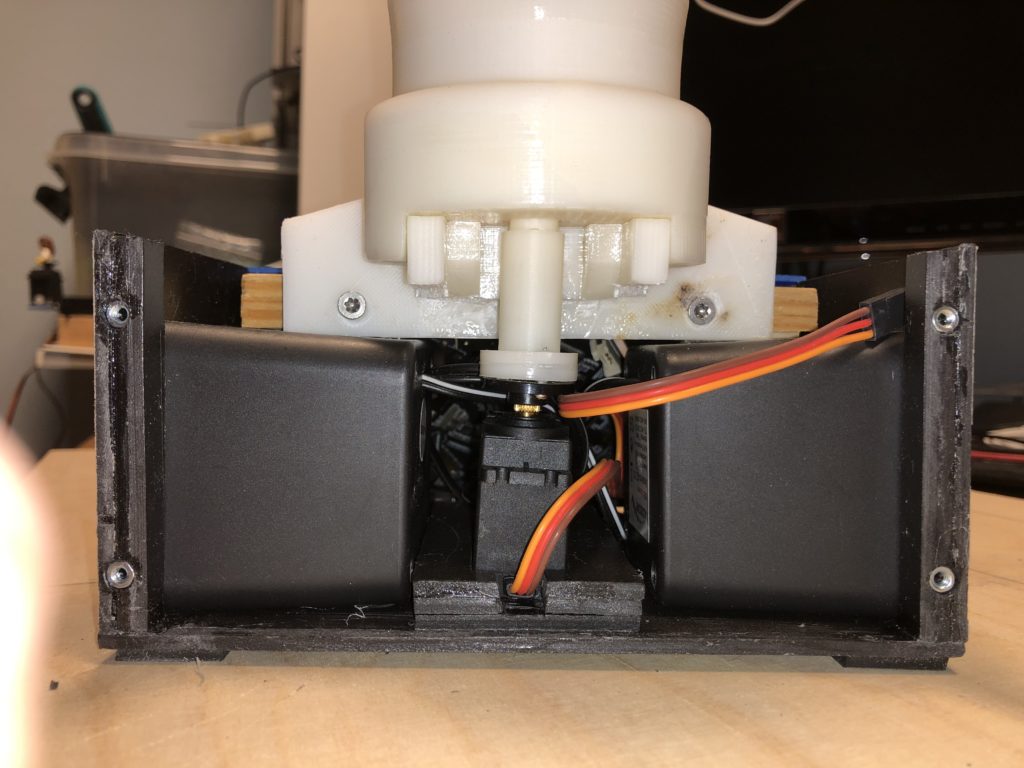

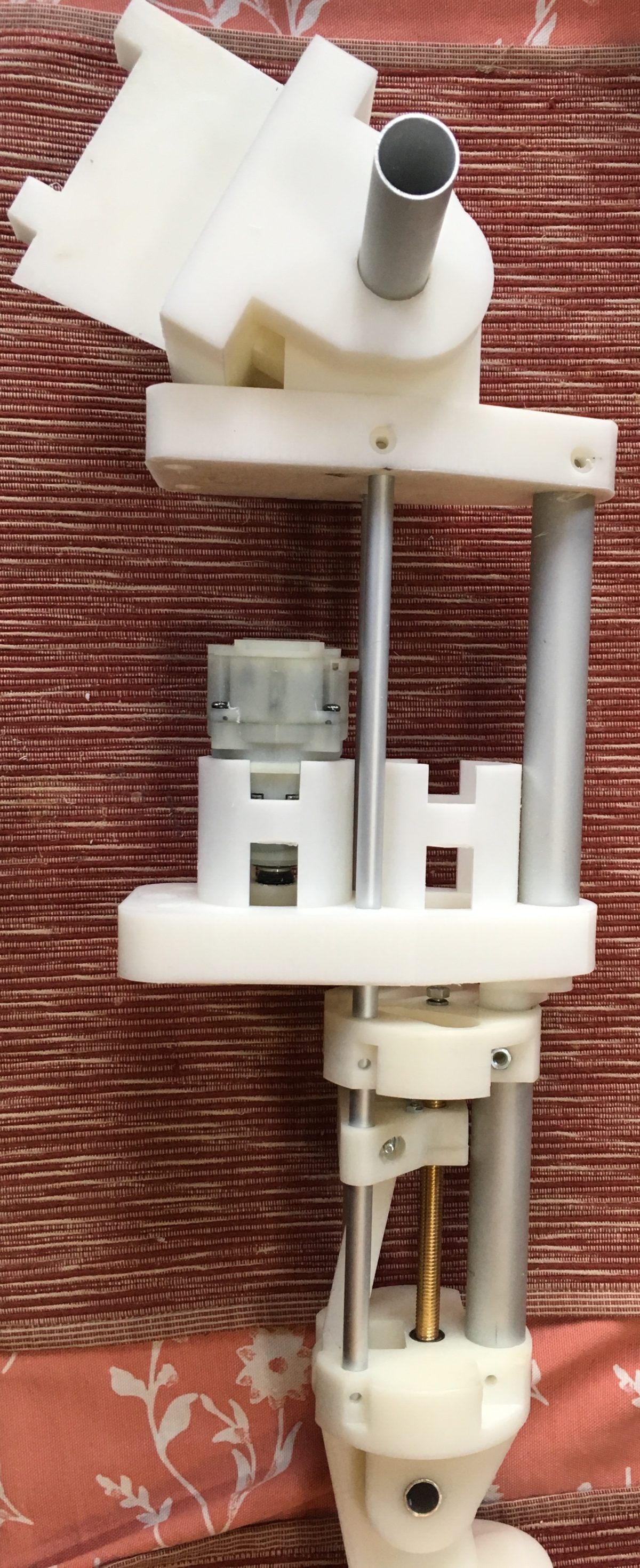

Beim neuen Hals läuft die Mechanik ohne größere Reibung

Die neue Version ist optimiert und ich musste keine größeren manuellen Arbeiten daran vornehmen. Leichter ist sie auch

Nur der Wetterbericht wird online geholt

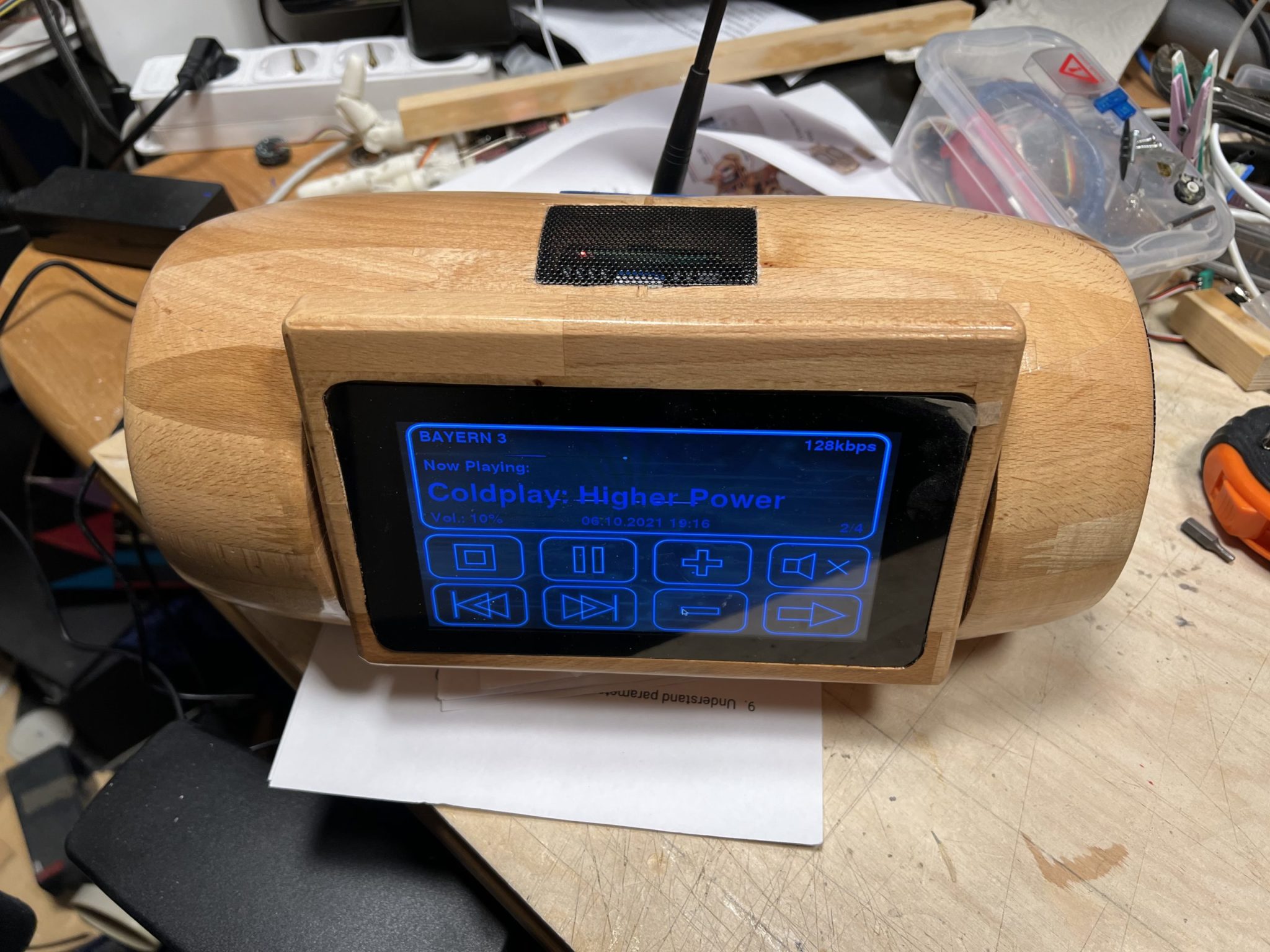

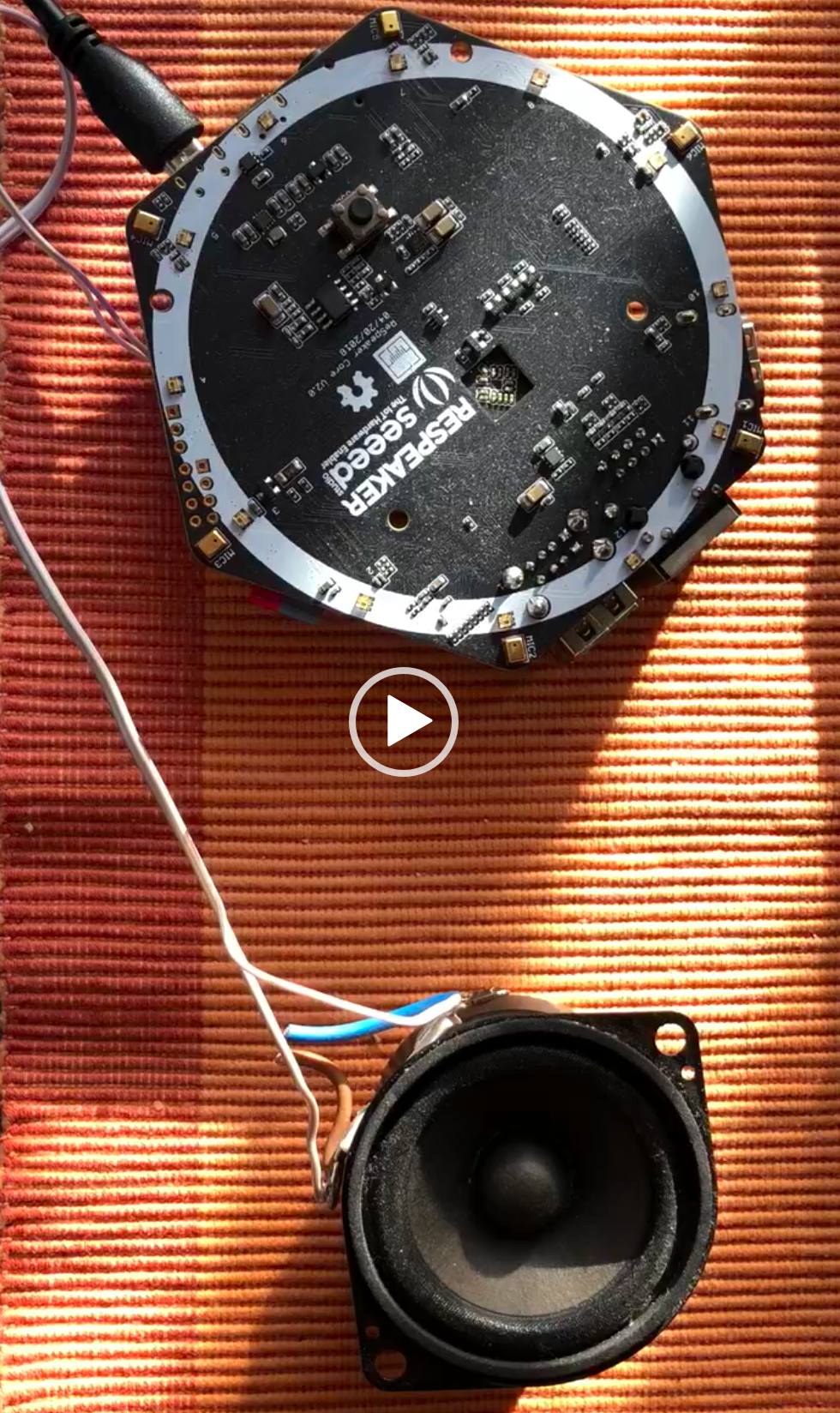

Nun mal wieder etwas vom Ky. Er hört jetzt Offline auf seinen Namen.

Das Ganze wird durch den Seeed Respeaker core V2 realisiert mit

einem Raspbian onbord.

Die Spracherkennung erfolgt durch die Software snips komplett offline nachdem man

im Internet auf deren Webseite entsprechende Dateien erzeigt hat.

Zum Beispiel habe ich gesagt: Kai hebe den rechten Arm

Dann erfolgt folgendes:

Watching on localhost:1883 (MQTT)

[Hotword] detected on site default, for model kai

[Asr] was asked to stop listening on site default

[[Hotword] was asked to toggle itself ‚off‘ on site default

[Dialogue] session with id ‚ce08d1ea-ace7-4cbd-8bb4-e6db248d319b‘ was started on site default

[Asr] was asked to listen on site default

[Asr] captured text „hebe den rechten arm“ in 3.0s

[Asr] was asked to stop listening on site default

[Nlu] was asked to parse input „hebe den rechten arm“

[Nlu] detected intent dsgra:heben with probability 1.000 for input „hebe den rechten arm“

Slots ->

SEITE_rechts -> rechts

KT_Arm -> Arm

[09:14:32] [Dialogue] New intent detected dsgra:heben with probability 1.000

Slots ->

SEITE_rechts -> rechts

KT_Arm -> Arm

Jetzt fehlt nur noch eine entsprechende Umsetzung der Befehle

Hi ich habe im Internet die Webseite snips.ai ausfindig gemacht.

Die stellen ein Portal zur Verfügung wo man einen eigenen Assistenten anlegen kann.

Dieser kann dann offline !!!! die entsprechenden Sätze und Worte verstehen.

Das ganze hat Intents und Skills .

Zuerst spreche ich das sogenannte Wake oder Hotword, in meinem Fall Ky (Kai) und dann den Satz drehe den Rumpf nach links.

drehe den [Rumpf](KT_Rumpf) nach [links](SEITE_links)

thomas sagt drehe [beide](SEITE_beide) [Arme](KT_Arm)

thomas sagt drehe den [linken](SEITE_links) [Arm](KT_Arm)

drehe Deinen [Kopf](KT_Kopf) nach [rechts](SEITE_rechts)

drehe Deinen [Kopf](KT_Kopf) nach [links](SEITE_links)

So lange nichts in den Blog gestellt,

ich habe mir für den Raspberry Pi eine Stimme für 20$ gekauft

Noch ein bischen wackelig aber ansonsten ok

Ein 5v 10A HutschienenNetzteil welches über den +Adj

auf 6V gepimpt worden ist.

Dient als Ersatz für den Akku beim experimentieren.

Der ist immer am Ende gewesen wenn die Softwareentwicklung

in Ihre spannende Phase getreten ist.

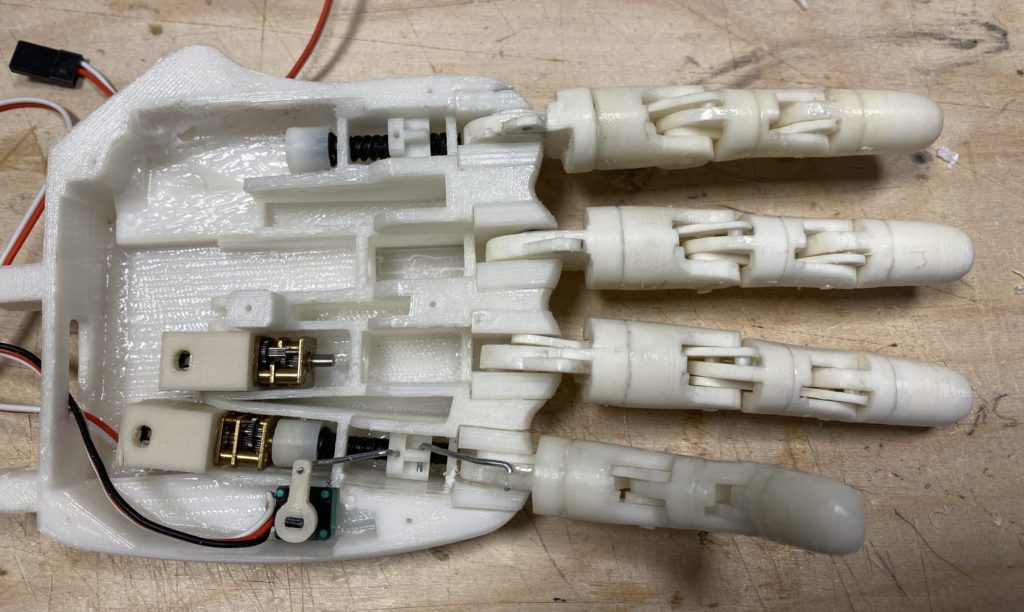

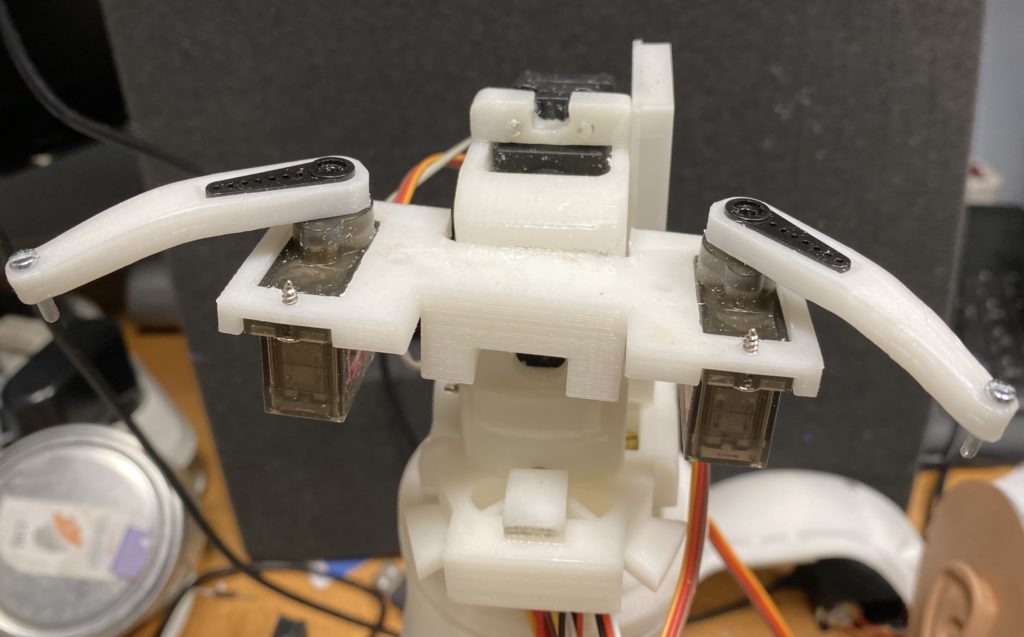

Der Blick auf die eingebauten Raspis und der Arduino Mega mit seinem Halter.

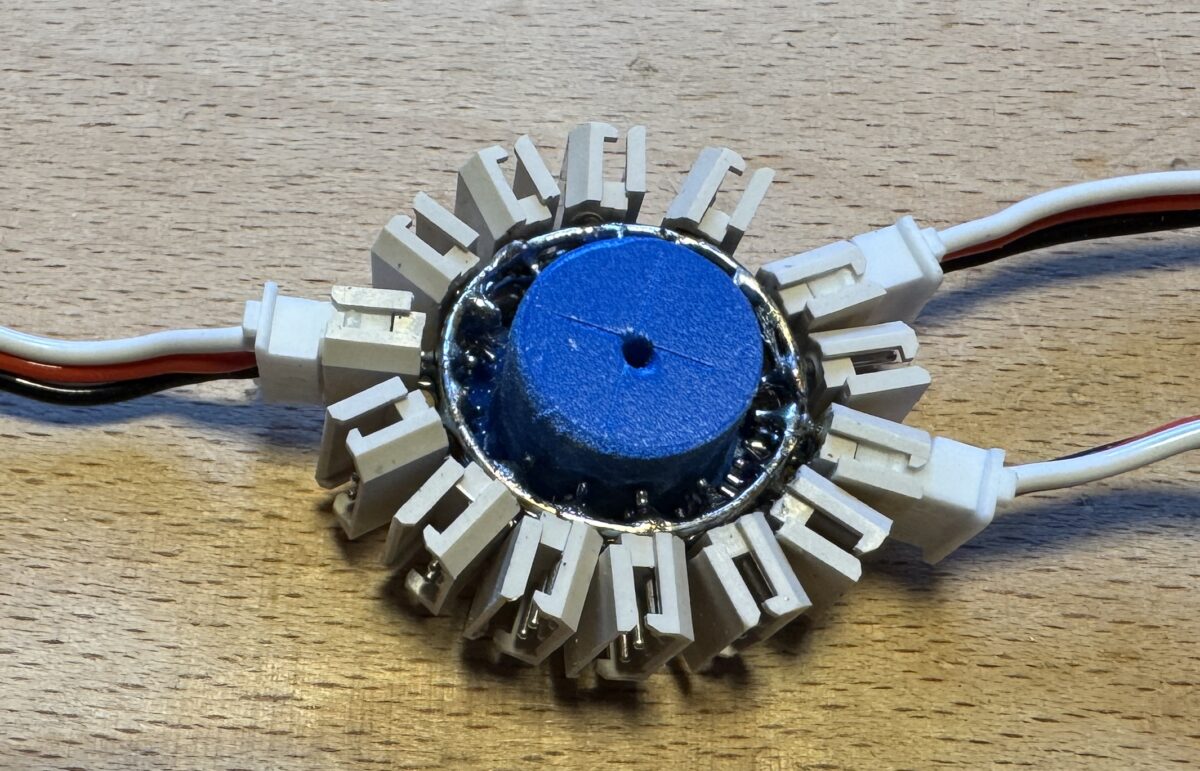

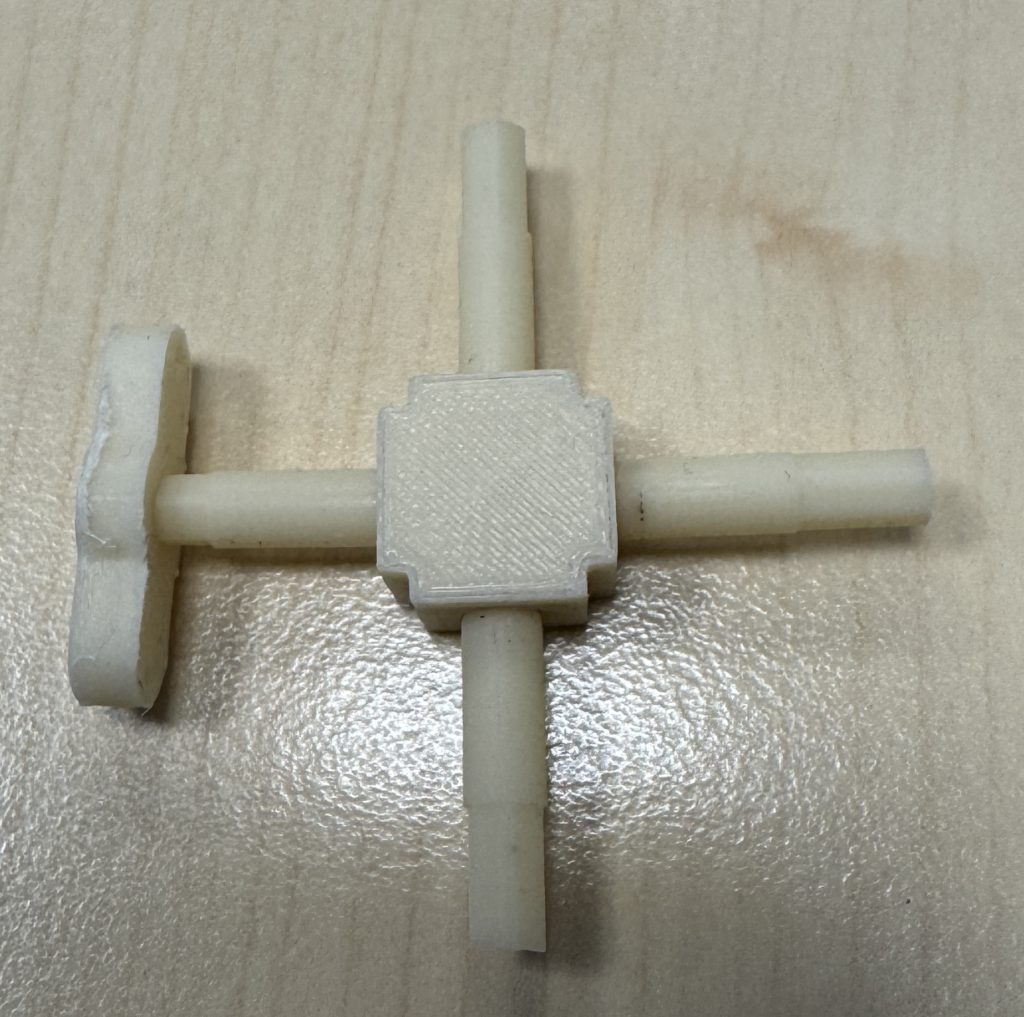

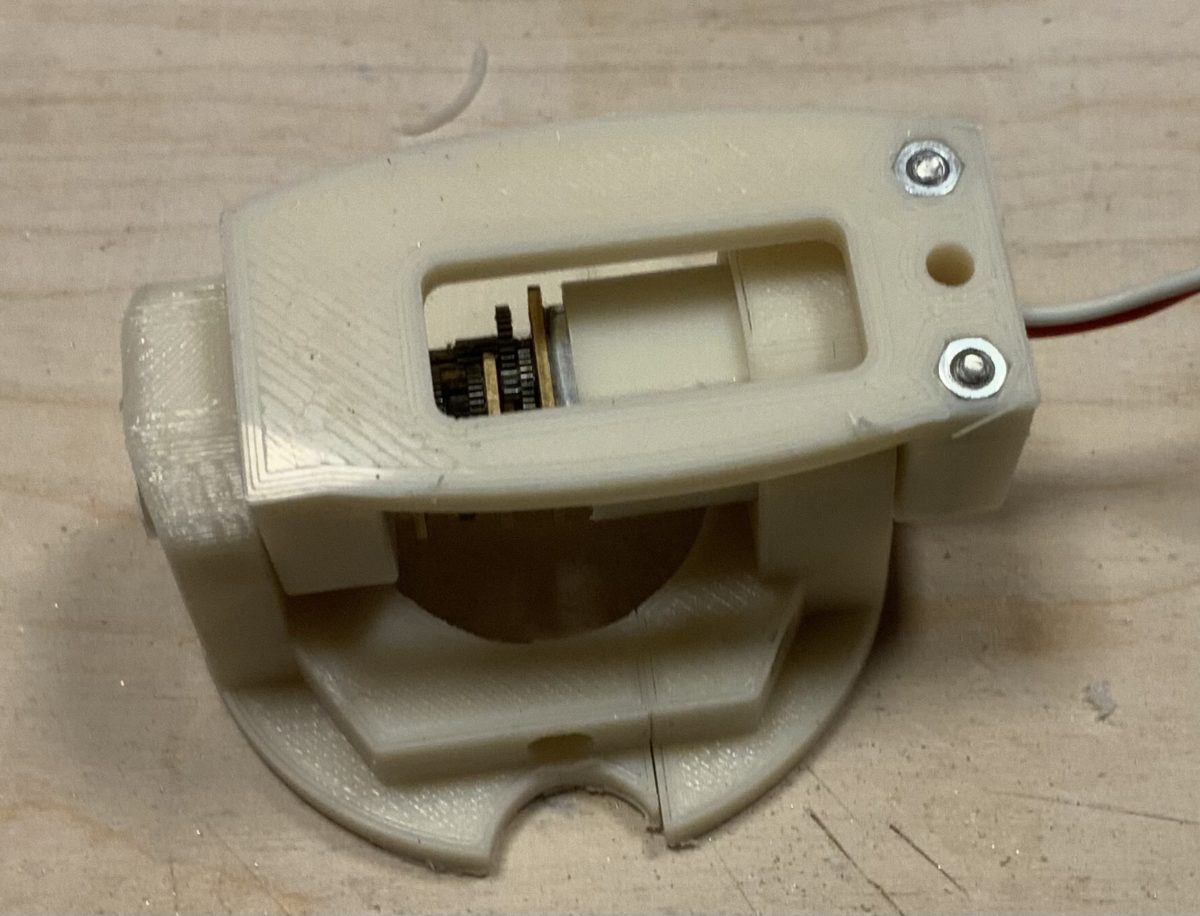

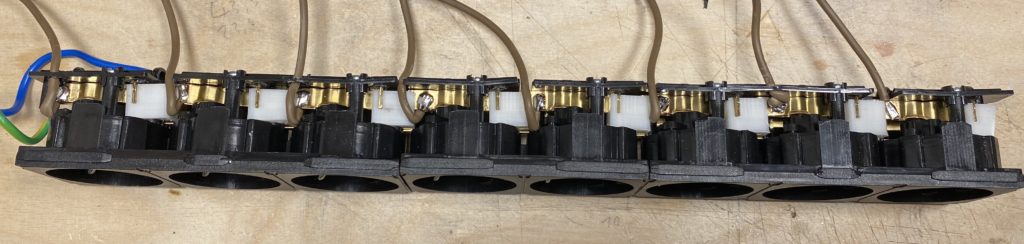

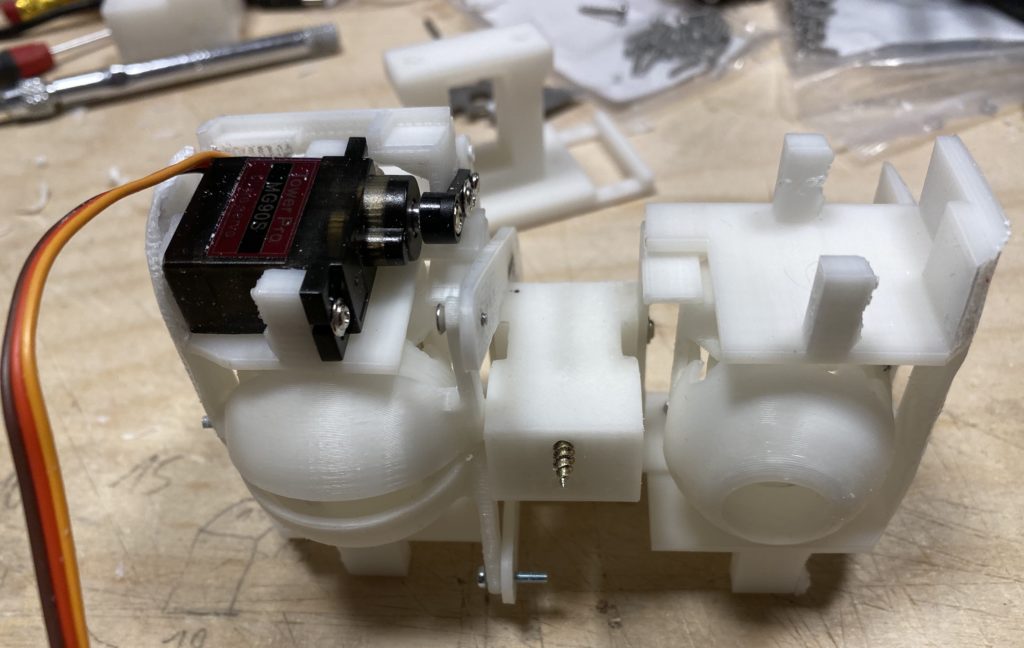

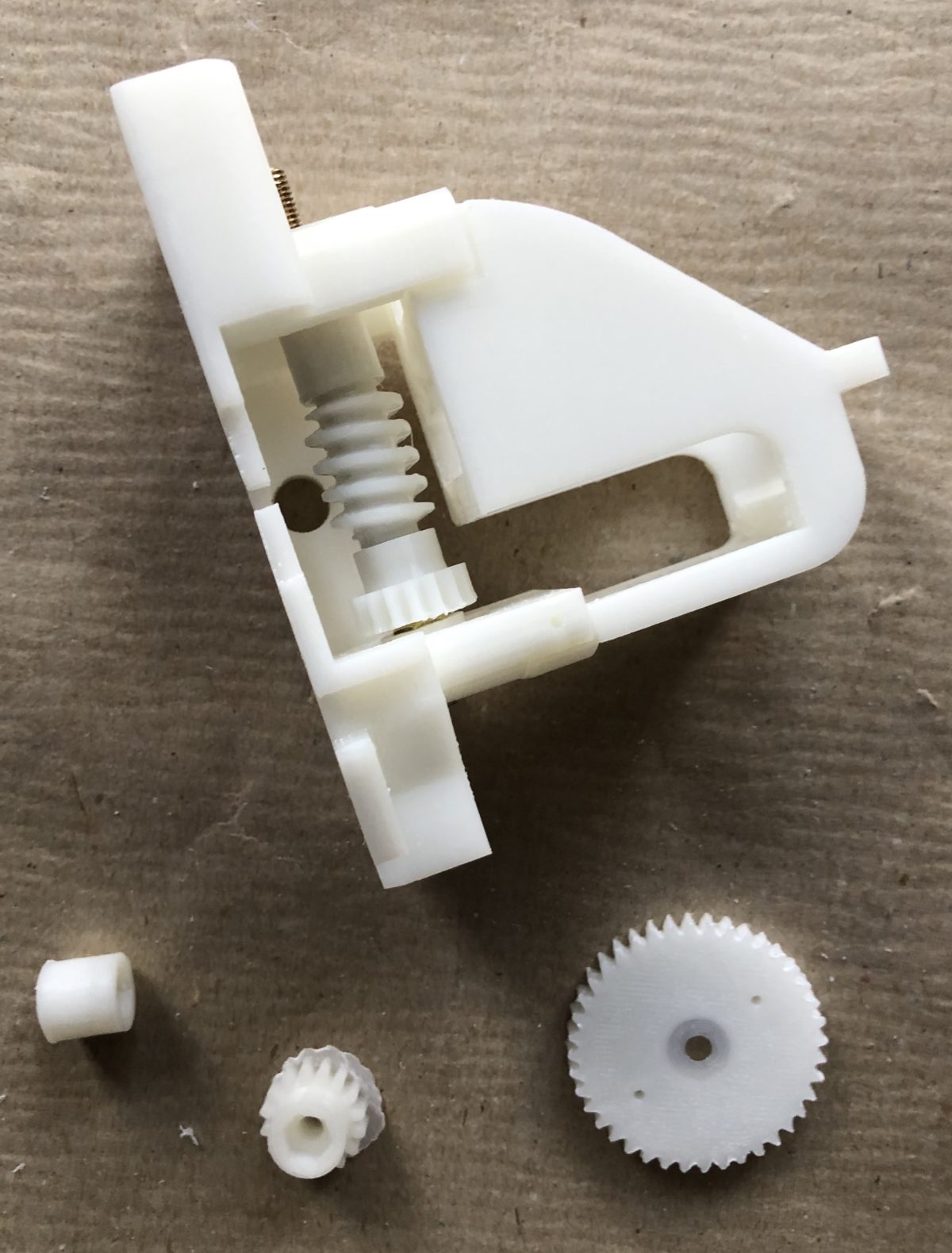

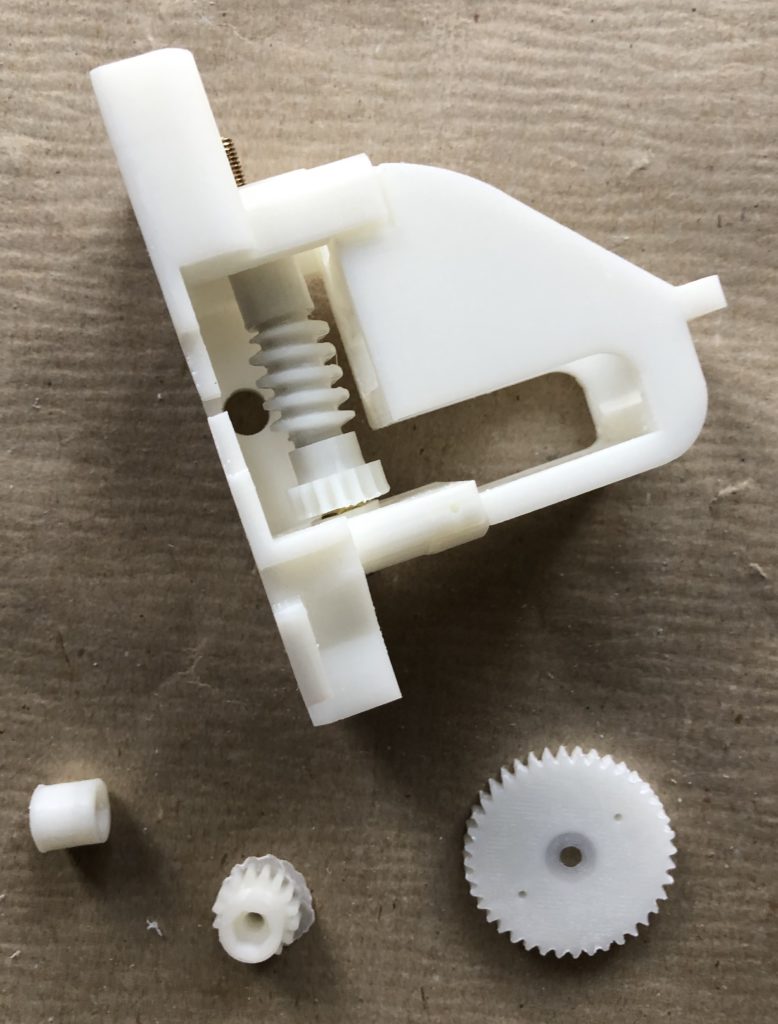

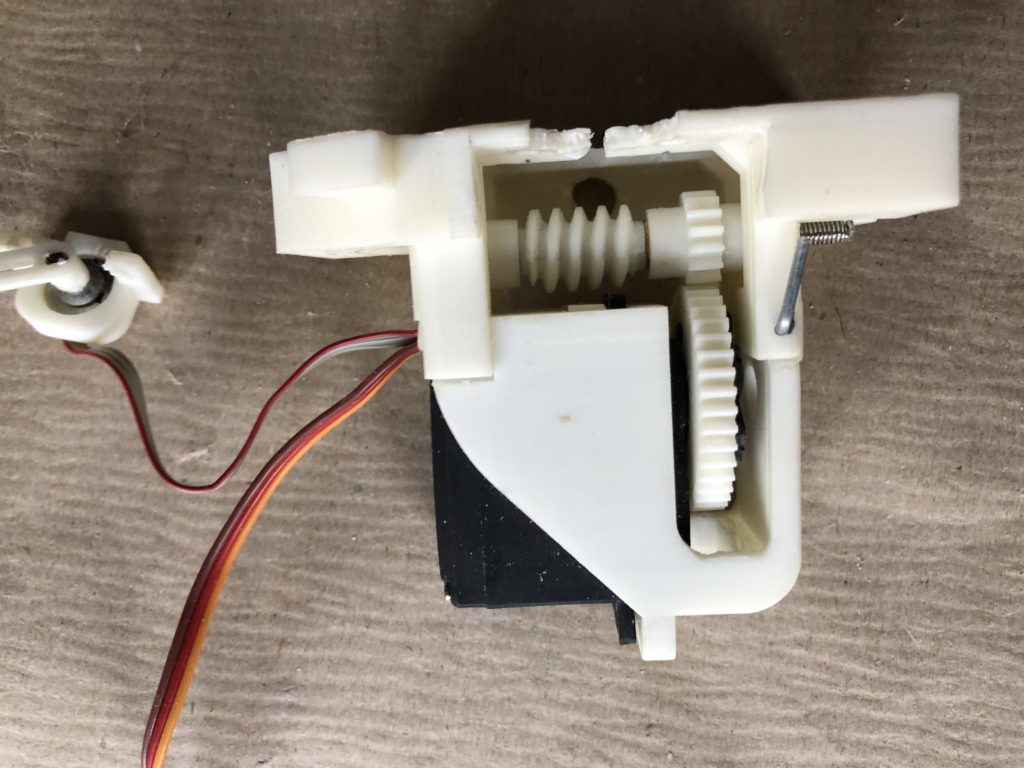

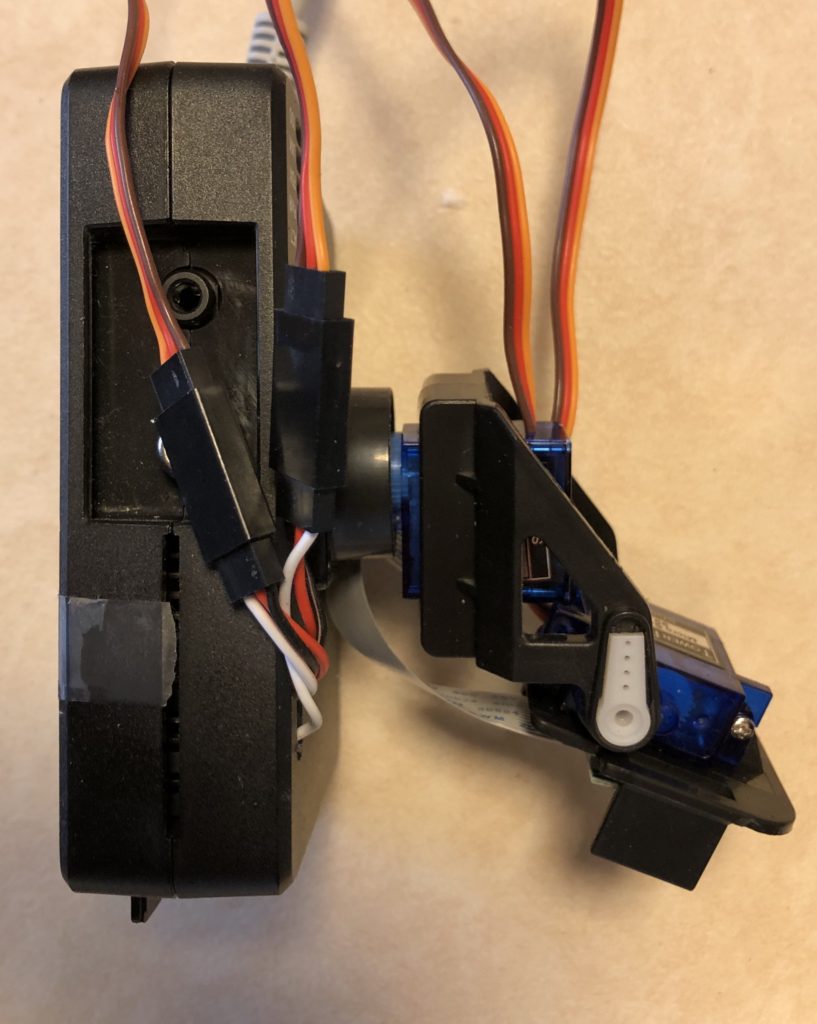

Der Klebestift und die bereits ausgebaute Schnecke

Der Motor mit Kupplung und das Servopoti was als Drehachse fungiert

Mit dem Inhalt eines Klebestiftes (Schnecke)

Wird der Finger gekrümmt

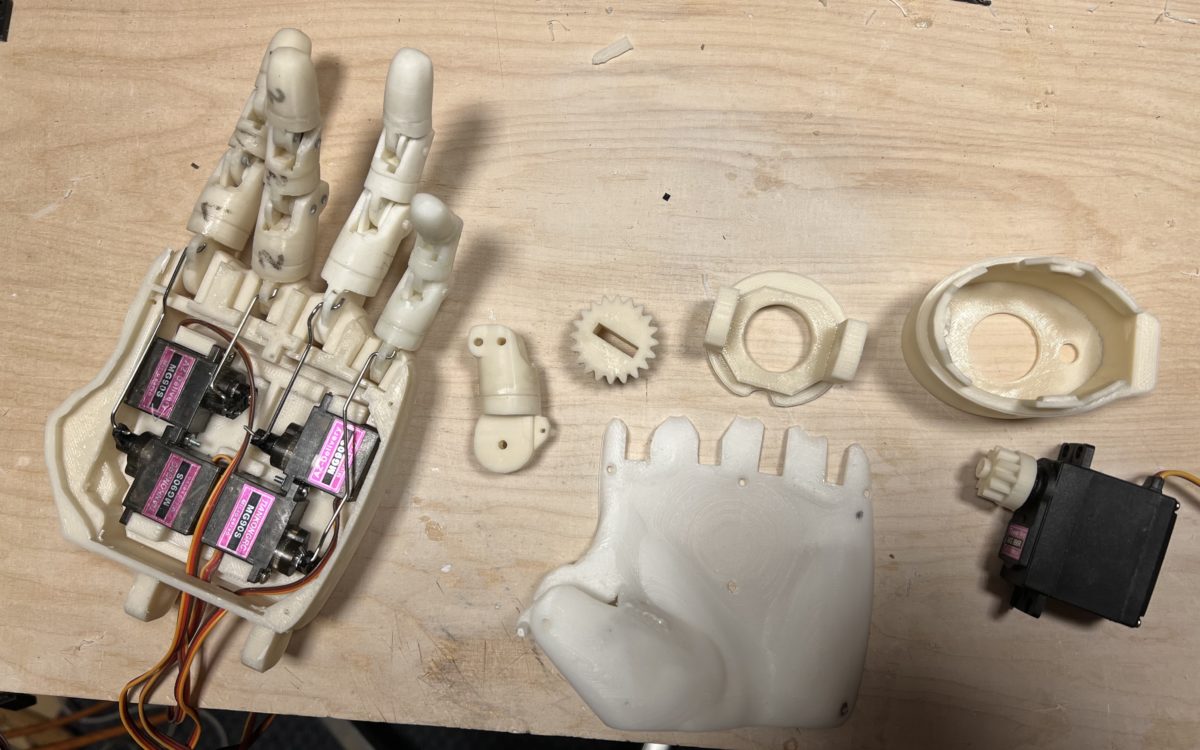

Das ganze ist eine Abänderung des http://www.thingiverse.com/thing:118031 von Gael Langevin

Es soll noch ein Motor angeflanscht werden